上一篇

反向传播网络未响应

- 行业动态

- 2025-05-04

- 2

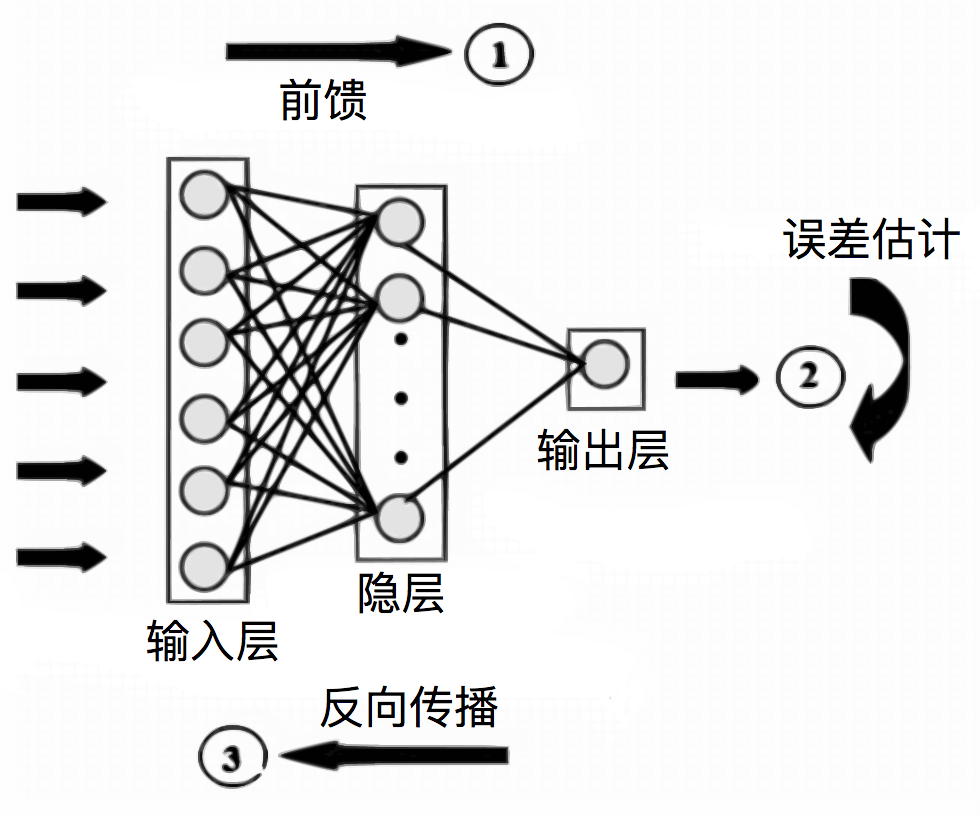

反向传播网络未响应可能因梯度消失/爆炸、学习率过高或过低、权重初始化不当、数据预处理异常或网络结构设计不合理

数据相关问题

| 问题类型 | 具体表现 | 解决方案 |

|---|---|---|

| 数据预处理错误 | 输入数据未归一化或标准化,导致梯度不稳定 | 对输入数据进行标准化(均值为0,方差为1)或归一化(缩放到[0,1]范围) |

| 标签格式错误 | 分类任务中标签未转换为独热编码(One-Hot) | 检查标签格式,例如使用tf.one_hot或sklearn.preprocessing.LabelBinarizer |

| 数据分布不均衡 | 某些类别样本过多,导致模型偏向主导类别 | 使用过采样(如SMOTE)、欠采样或加权损失函数平衡数据分布 |

| 数据损坏 | 训练数据中存在NaN或异常值 | 清洗数据,替换或删除异常值,确保数据完整性 |

示例:

若输入图像像素值范围为[0,255],未归一化直接输入模型,可能导致梯度爆炸(尤其是使用Sigmoid激活函数时),此时需将数据缩放为[0,1]或[-1,1]。

模型结构问题

网络层数过深

- 问题:深层网络容易出现梯度消失(如Sigmoid/Tanh激活函数)或梯度爆炸(如ReLU未配合正则化)。

- 解决方案:

- 减少层数或使用残差网络(ResNet)缓解梯度消失。

- 更换激活函数(如Leaky ReLU、ELU)或添加Batch Normalization。

输出层与任务不匹配

- 问题:例如分类任务输出层未使用Softmax,或回归任务使用交叉熵损失。

- 解决方案:

- 分类任务:输出层节点数=类别数,搭配Softmax和交叉熵损失。

- 回归任务:输出层节点数=1,使用MSE损失。

权重初始化不当

- 问题:若权重初始化为全0,会导致所有神经元输出相同,破坏反向传播。

- 解决方案:

- 使用He初始化(ReLU激活)或Xavier初始化(Tanh/Sigmoid激活)。

- 示例(TensorFlow):

tf.keras.initializers.HeNormal()

超参数配置问题

| 超参数 | 异常表现 | 调整方法 |

|---|---|---|

| 学习率(LR) | 学习率过高→损失震荡/NaN;过低→损失不变 | 从1e-3开始,逐步减小(如1e-4,1e-5)或使用学习率调度器 |

| 批量大小(Batch Size) | 批量过大→内存不足;过小→梯度噪声大 | 尝试32/64/128,结合GPU内存调整 |

| 正则化系数 | 正则化过强→模型欠拟合 | 逐步增加L2正则化系数(如1e-4→1e-3) |

示例:

若使用SGD优化器且学习率为0.1,可能导致损失剧烈震荡,可切换为Adam优化器(默认学习率0.001)或降低学习率至1e-4。

实现代码问题

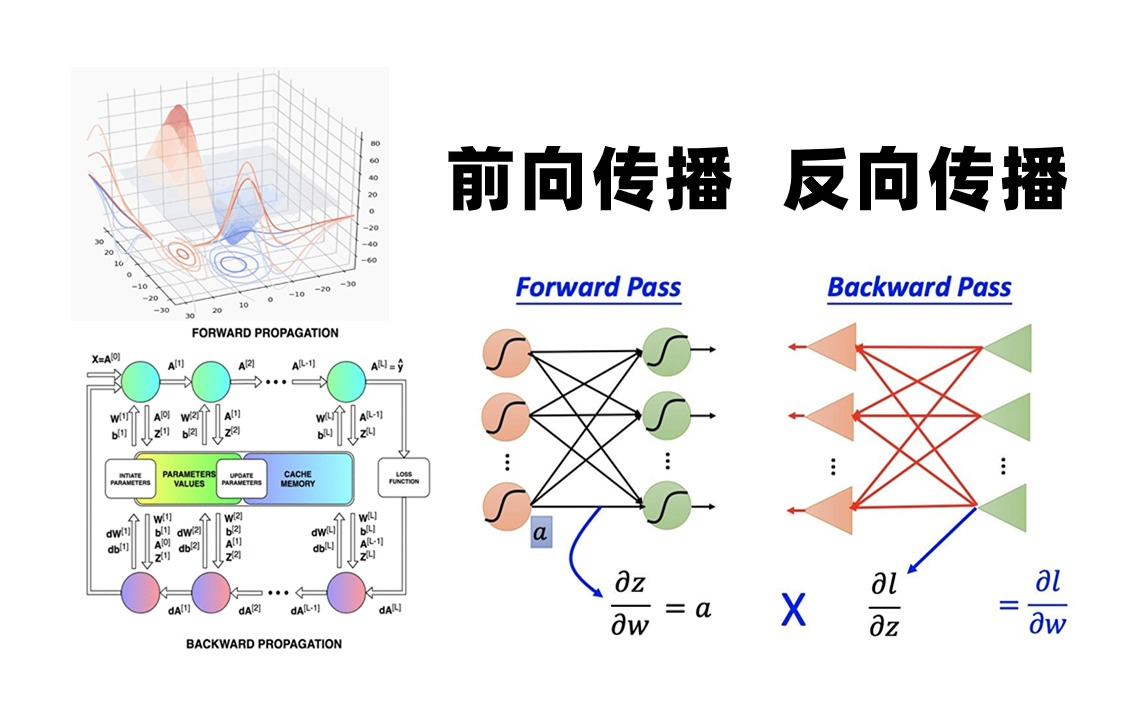

梯度计算错误

- 常见问题:

- 未正确实现反向传播公式(如忘记对激活函数求导)。

- 损失函数未对输出层求导(例如回归任务中使用绝对值损失)。

- 解决方案:

- 使用框架自动求导(如TensorFlow的

GradientTape或PyTorch的autograd)。 - 手动检查梯度公式,例如Sigmoid导数为

s(1-s),ReLU导数为分段函数。

- 使用框架自动求导(如TensorFlow的

- 常见问题:

权重更新逻辑错误

- 问题:例如更新权重时未应用学习率,或误用梯度上升而非梯度下降。

- 解决方案:

- 确认权重更新公式:

w = w learning_rate gradient - 检查代码符号,确保梯度方向正确。

- 确认权重更新公式:

框架API误用

- 问题:例如Keras中忘记调用

model.compile(),或PyTorch中未启用model.train()模式。 - 解决方案:

- 检查框架文档,确保训练流程正确(如

model.fit()前编译模型)。 - 验证是否禁用了梯度计算(如PyTorch的

torch.no_grad())。

- 检查框架文档,确保训练流程正确(如

- 问题:例如Keras中忘记调用

硬件与环境问题

GPU内存不足

- 表现:模型加载后显存溢出,训练卡死。

- 解决方案:

- 降低批量大小或简化模型。

- 使用混合精度训练(如TensorFlow的

tf.keras.mixed_precision)。

框架版本兼容性

- 问题:例如TensorFlow 2.x与1.x代码不兼容。

- 解决方案:

- 检查框架版本,更新代码以适配当前版本(如使用

tf.GradientTape替代optimizer.minimize())。

- 检查框架版本,更新代码以适配当前版本(如使用

排查步骤归纳

- 检查数据:确认输入输出格式、归一化、标签编码。

- 验证模型结构:输出层是否匹配任务,权重初始化是否正确。

- 测试超参数:尝试不同学习率和批量大小。

- 调试代码:打印梯度值,确认反向传播是否执行。

- 监控资源:查看GPU显存占用,排除硬件问题。

FAQs

Q1:如何解决梯度消失问题?

- A:

- 更换激活函数为ReLU或Leaky ReLU。

- 添加Batch Normalization。

- 使用预训练模型或残差连接。

- 调整权重初始化(如He初始化)。

Q2:如何验证数据是否正确输入模型?

- A:

- 打印输入数据形状(如

print(X.shape))。 - 随机抽样输入数据,检查数值范围(如图像是否归一化)。

- 确认标签与输出层匹配(如分类任务标签为整数或独热编码)。

- 使用小规模数据测试训练流程(如仅10条样本)。

- 打印输入数据形状(如

通过以上步骤,可系统化解决反向传播网络未响应的问题,若仍无法解决,建议逐步简化模型(如减少层数)或使用框架自带的调试工具(如TensorFlow的tf.debugging模块)。