上一篇

反向传播网络有什么用

- 行业动态

- 2025-05-04

- 3

反向传播网络通过计算预测误差并反向逐层调整权重,利用梯度下降优化模型参数,有效降低损失函数值,提升神经网络对复杂数据的拟合能力,是实现图像识别、语音处理等任务的核心训练

反向传播网络的核心作用与应用场景解析

反向传播(Backpropagation)作为深度学习的核心算法,自20世纪80年代被重新发现以来,彻底改变了神经网络的训练方式,它通过高效计算梯度,解决了多层神经网络参数优化的难题,成为现代人工智能技术的基石,以下从技术原理、核心功能、实际应用及发展意义四个维度展开分析。

反向传播的技术原理与核心机制

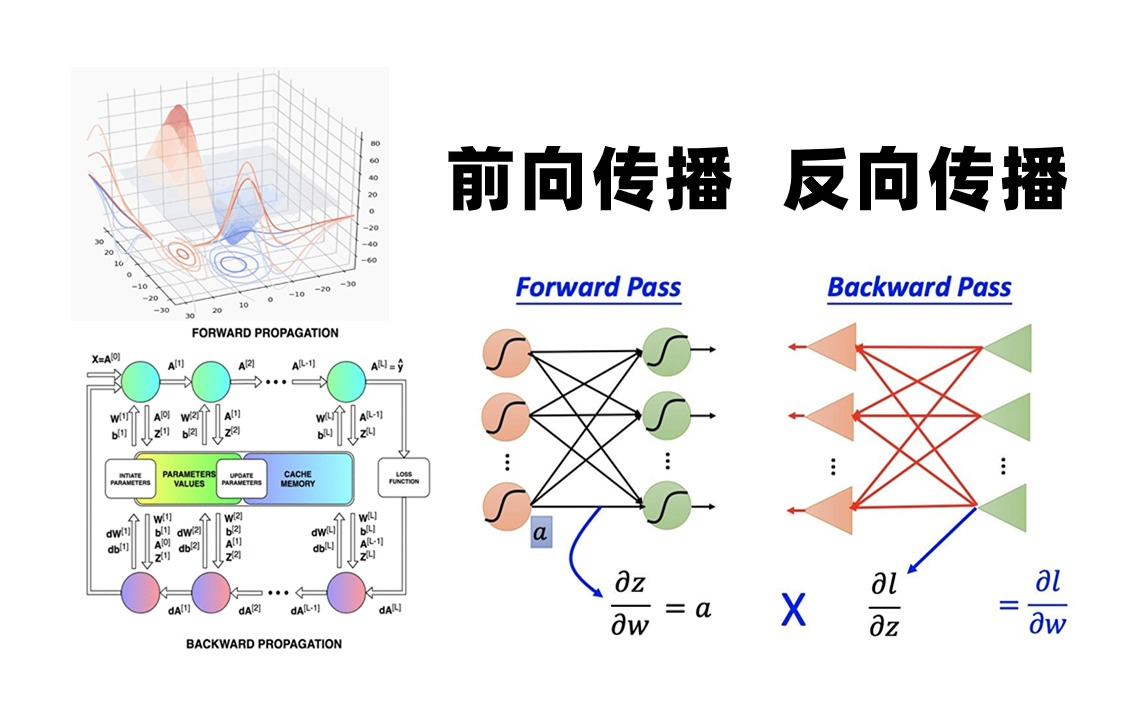

反向传播的本质是通过链式法则(Chain Rule)实现误差的反向传递,从而计算损失函数对各层参数的梯度,其核心流程可分为前向传播与反向传播两个阶段:

| 阶段 | 核心操作 | 数学基础 |

|---|---|---|

| 前向传播 | 输入数据逐层通过神经网络,计算每层输出并最终得到预测值 | 线性代数(矩阵乘法) |

| 反向传播 | 计算输出层误差 逐层反向计算误差对权重的偏导数 更新参数 | 链式法则、梯度下降 |

关键创新点:

- 梯度高效计算:将复合函数的梯度计算分解为各层局部梯度的乘积,时间复杂度从指数级(O(n))降为线性级(O(1))。

- 参数更新策略:通过反向传递的误差信号,结合优化算法(如SGD、Adam)动态调整权重,使损失函数收敛。

反向传播的核心功能与优势

反向传播解决了传统神经网络训练中的两大难题:

- 多层网络参数优化:早期单层网络(如感知机)无法解决非线性问题,而多层网络因梯度消失/爆炸问题难以训练,反向传播通过误差反向流动,使得隐藏层参数可被有效更新。

- 端到端训练:无需手动设计特征提取规则,直接通过数据驱动自动学习输入到输出的映射关系。

对比传统方法:

| 方法 | 参数更新方式 | 适用网络深度 | 计算效率 |

|——————-|————————————–|——————|————–|

| 反向传播 | 自动计算梯度并更新 | 任意深度 | 高 |

| 有限差分法 | 数值逼近梯度 | 浅层 | 低 |

| 手动微调 | 依赖人工经验调整参数 | 浅层 | 极低 |

反向传播的典型应用场景

反向传播的广泛应用推动了人工智能在多个领域的突破,以下是其核心应用场景:

| 领域 | 具体任务 | 技术实现示例 |

|---|---|---|

| 计算机视觉 | 图像分类、目标检测、语义分割 | ResNet、YOLO系列、Mask R-CNN |

| 自然语言处理 | 机器翻译、文本生成、情感分析 | Transformer、BERT、GPT系列 |

| 强化学习 | 机器人控制、游戏AI、自动驾驶决策 | DQN、A3C、PPO算法 |

| 语音识别 | 语音转文本、声纹识别、语音合成 | WaveNet、DeepSpeech |

| 科学计算 | 材料特性预测、基因序列分析、流体模拟 | Graph Neural Network、物理信息神经网络 |

案例分析:

- ImageNet竞赛突破:2012年AlexNet利用反向传播在ImageNet分类任务中将误差率降低至15.3%,远超传统方法,标志着深度学习在视觉领域的崛起。

- AlphaGo Zero:通过反向传播自我对弈,40天训练后超越人类棋手,展示了强化学习与反向传播结合的潜力。

反向传播的局限性与改进方向

尽管反向传播是深度学习的核心,但仍存在以下挑战:

- 梯度消失/爆炸:深层网络中误差信号可能衰减至零(如Sigmoid激活函数)或无限增大(如未经权重初始化的ReLU)。

- 解决方案:批归一化(Batch Normalization)、残差网络(ResNet)、ReLU激活函数。

- 局部最优解:梯度下降可能陷入鞍点或局部最小值。

- 改进方向:自适应学习率算法(如Adam)、退火策略、随机权重初始化。

- 训练效率瓶颈:超深网络(如万亿参数模型)的反向传播耗时巨大。

- 优化技术:分布式训练、混合精度计算、梯度检查点(Gradient Checkpointing)。

FAQs:关于反向传播的常见问题解答

Q1:反向传播与梯度下降是什么关系?

A:梯度下降是参数优化的算法框架,而反向传播是梯度下降在神经网络中的具体实现,反向传播负责高效计算损失函数对各层参数的梯度,梯度下降则利用这些梯度更新参数,两者结合构成了“计算梯度→更新参数”的闭环。

Q2:为什么深层网络必须依赖反向传播?

A:深层网络的参数呈指数级增长,传统手动调参或随机搜索无法找到最优解,反向传播通过链式法则将误差信号逐层传递,使得每个隐藏层的参数都能根据全局损失进行调整,若无反向传播,深层网络的训练将因梯度计算不可行性而失效。