反向传播网络用来干嘛

- 行业动态

- 2025-05-04

- 2

反向传播网络用于训练神经网络,通过反向传递误差调整权重,优化模型

反向传播网络的核心功能与应用场景解析

反向传播(Backpropagation)是深度学习领域最重要的算法之一,它通过高效计算梯度解决了多层神经网络的训练难题,以下从技术原理、核心功能、应用场景及优化方向四个维度展开详细分析。

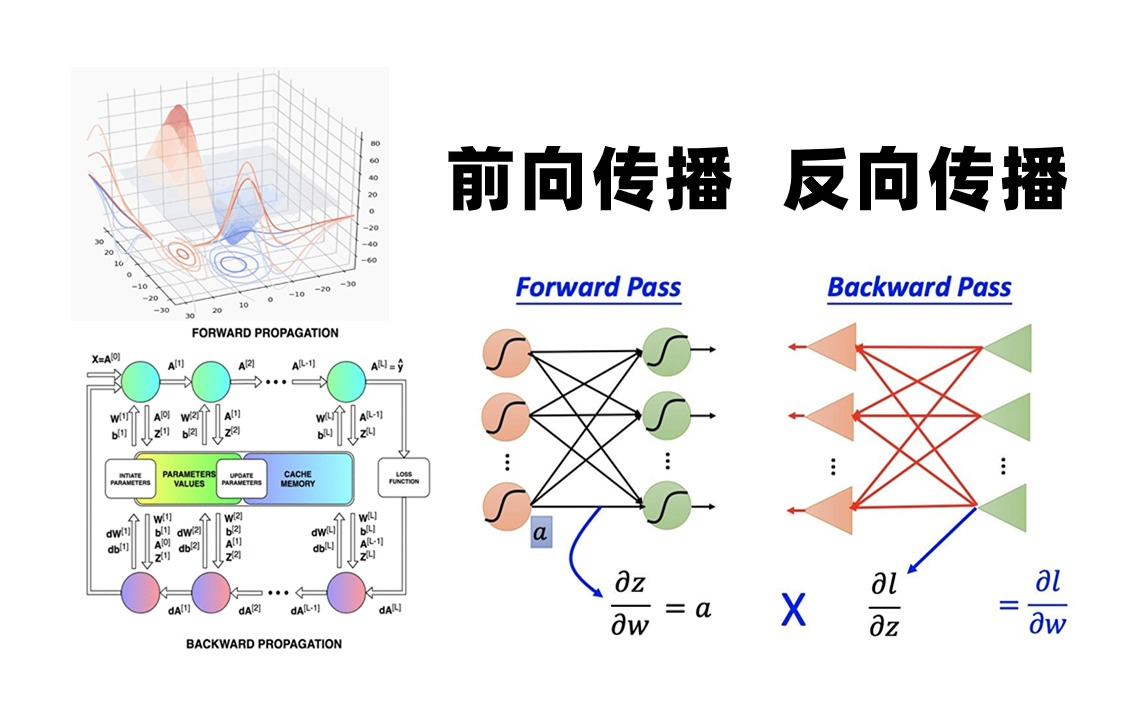

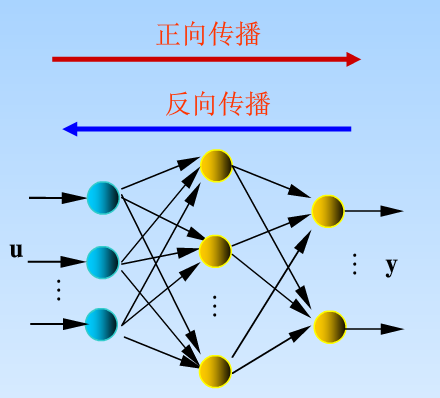

反向传播的技术原理

反向传播的本质是通过链式法则(Chain Rule)实现误差的逆向传递,其核心目标在于计算损失函数对网络参数的梯度,以下是关键步骤的分解:

| 步骤 | 过程描述 | 数学表达 |

|---|---|---|

| 前向传播 | 输入数据通过各层神经元计算预测值 | $a^{(l)} = f(W^{(l)}a^{(l-1)} + b^{(l)})$ |

| 损失计算 | 比较预测值与真实标签的误差 | $L = frac{1}{2}sum (y_i hat{y}_i)^2$ |

| 反向传播 | 从输出层到输入层逐层计算梯度 | $frac{partial L}{partial W^{(l)}} = delta^{(l+1)}a^{(l)T}$ |

| 参数更新 | 基于梯度下降法调整权重 | $W^{(l)} leftarrow W^{(l)} eta delta^{(l)}a^{(l-1)T}$ |

核心创新点:

- 梯度高效计算:将复杂网络的梯度计算复杂度从指数级(O(2^N))降为线性级(O(N))

- 误差信号分解:通过$delta$变量将全局误差分解为各层局部梯度

- 通用性框架:适用于任意深度的前馈神经网络结构

反向传播的核心功能

非线性建模能力释放

通过堆叠非线性激活函数(如ReLU、Sigmoid),网络可拟合复杂函数关系,反向传播通过梯度引导参数调整,使多层结构突破单层感知机的限制。

端到端训练实现

消除手工特征工程需求,直接从原始数据学习最优特征表示,例如在图像分类任务中,网络自动提取边缘、纹理等多层次特征。动态特征学习

- 低层特征:边缘检测、颜色斑块等通用模式

- 中层特征:部件级组合(如眼睛、车轮等)

- 高层特征:抽象语义概念(如”猫” vs “狗”的区分特征)

泛化能力提升

通过正则化技术(如Dropout、Batch Normalization)控制参数空间,使模型在未见过的数据上保持性能。

典型应用场景与案例

| 应用领域 | 具体任务 | 技术特点 |

|---|---|---|

| 计算机视觉 | 图像分类/目标检测 | 卷积神经网络(CNN)结合反向传播自动提取空间特征 |

| 自然语言处理 | 机器翻译/文本生成 | Transformer架构通过反向传播学习词向量表示 |

| 强化学习 | 游戏AI/机器人控制 | Policy Gradient算法依赖反向传播优化策略网络 |

| 语音处理 | 语音识别/合成 | RNN-Transducer模型通过反向传播学习声学特征 |

| 医疗诊断 | 病理图像分析/基因预测 | 3D卷积网络处理医学影像数据 |

典型案例分析:

- ImageNet分类:AlexNet通过8层CNN+反向传播,将图像识别错误率从26%降至15%

- AlphaGo Zero:纯强化学习框架,仅用3天训练即超越人类专家棋力

- BERT模型:通过掩码语言模型预训练,刷新11项NLP任务基准记录

技术挑战与优化方向

梯度消失/爆炸问题

- 原因:深层网络中梯度连乘导致数值不稳定

- 解决方案:

- 激活函数改进(ReLU替代Sigmoid)

- 批量归一化(Batch Normalization)

- 残差连接(ResNet)

计算资源瓶颈

- VGG-16训练需约15GB显存

- 优化策略:

- 分布式训练(Horovod框架)

- 模型压缩(知识蒸馏、剪枝)

- 近似计算(量化训练)

过拟合控制

| 方法 | 作用机制 | 效果提升 |

|——|———-|———-|

| Dropout | 随机失活神经元 | 降低参数耦合度 |

| Data Augmentation | 增强训练数据多样性 | 提升模型鲁棒性 |

| Early Stopping | 监控验证集性能 | 防止过度训练 |

技术演进趋势

- 自适应学习率:AdaBelief、LookAhead等优化器动态调整步长

- 无监督学习:Contrastive Learning推动自监督训练发展

- 硬件协同设计:Tensor Core、Neural Architecture Search等专用技术涌现

- 可解释性研究:Grad-CAM、Integrated Gradients等可视化工具开发

FAQs

Q1:反向传播与梯度下降是什么关系?

A:梯度下降是参数优化的数学基础,反向传播是梯度计算的具体实现方法,前者定义了”如何移动”,后者解决了”往哪走”的问题,两者结合构成神经网络训练的核心框架。

Q2:为什么深度网络必须用反向传播?

A:传统BP算法(如感知机学习规则)仅适用于单层网络,多层网络需要计算中间层梯度,而反向传播通过链式法则实现了这一过程,没有它,深层模型