上一篇

如何解决服务器负载均衡难题才能提升性能?

- 行业动态

- 2025-04-27

- 4045

服务器负载均衡通过合理分配用户请求至多台服务器,优化资源利用并提升系统性能,常用算法包括轮询、加权轮询和最少连接数,结合健康检查机制确保节点可用性,避免单点故障,同时支持横向扩展以应对高并发场景。

提升性能与可靠性的核心技术

什么是服务器负载均衡?

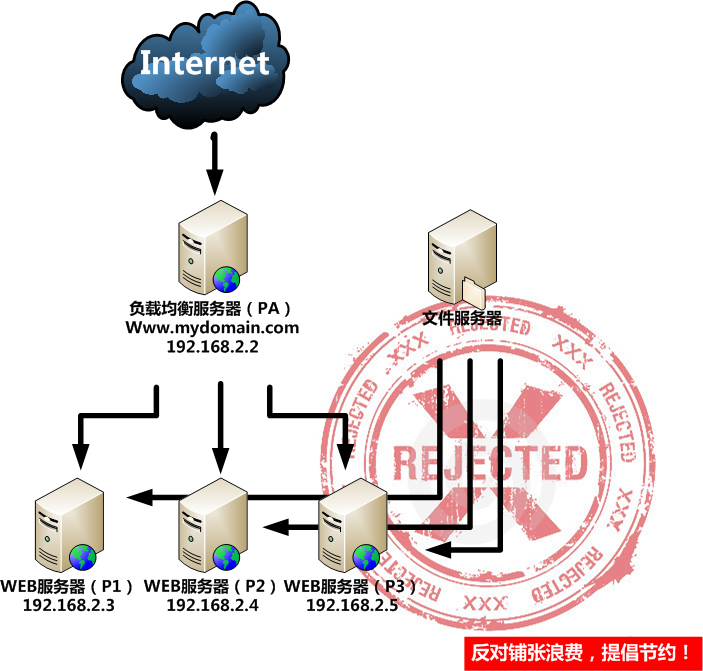

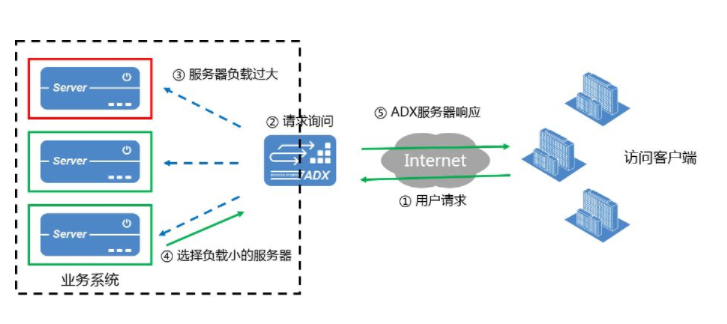

服务器负载均衡是一种将网络流量或工作任务合理分配到多台服务器的技术,旨在优化资源使用效率、最大化吞吐量、最小化响应时间,并避免单点故障,在互联网应用场景中,用户访问量可能呈现突发性增长或分布不均的特点,负载均衡技术通过动态分配请求,确保每台服务器不会因过载而崩溃,同时提升用户体验。

为什么需要负载均衡?

- 高并发处理:当单台服务器无法应对瞬时高流量(如电商大促、新闻热点事件)时,负载均衡可将请求分散到多台服务器。

- 提高可用性:某台服务器宕机时,负载均衡器自动将流量切换到健康节点,保障服务不中断。

- 资源优化:根据服务器性能差异(如CPU、内存)分配不同权重,避免资源浪费。

- 扩展性:业务增长时,只需横向增加服务器,无需重构架构。

常见的负载均衡算法

- 轮询(Round Robin)

按顺序将请求依次分配给每台服务器,适用于服务器性能相近的场景。 - 加权轮询(Weighted Round Robin)

根据服务器处理能力(如配置高低)分配不同权重,高性能服务器承担更多请求。 - 最少连接(Least Connections)

优先将请求发送到当前连接数最少的服务器,适合长连接场景(如视频流、数据库)。 - IP哈希(IP Hash)

根据客户端IP地址计算哈希值,固定将同一用户请求分配到特定服务器,适用于需要会话保持的应用。 - 响应时间优先(Response Time)

动态监测服务器响应速度,将请求导向处理最快的节点。

负载均衡的实现方式

- 硬件负载均衡

通过专用设备(如F5 BIG-IP、Citrix ADC)实现,性能强、稳定性高,但成本昂贵,适合大型企业或金融级应用。 - 软件负载均衡

基于开源工具(如Nginx、HAProxy、LVS),部署灵活、成本低,但需自行维护和优化配置。 - 云服务负载均衡

主流云平台(如AWS ALB、阿里云SLB、酷盾CLB)提供托管的负载均衡服务,支持自动伸缩、SSL卸载、DDoS防护等高级功能。

负载均衡的技术挑战与解决方案

- 会话保持(Session Persistence)

- 问题:用户多次请求可能落在不同服务器,导致登录状态丢失。

- 方案:使用Cookie注入、数据库共享会话或IP哈希算法绑定用户与服务器。

- 健康检查(Health Check)

- 问题:故障服务器若未被及时剔除,会影响整体服务。

- 方案:配置TCP/UDP端口检测或HTTP应用层探针,实时监控服务器状态。

- 动态扩展

- 问题:流量突增时需手动扩容,效率低下。

- 方案:结合云计算的弹性伸缩组,根据CPU、带宽等指标自动增减服务器实例。

最佳实践与行业案例

- 混合部署策略

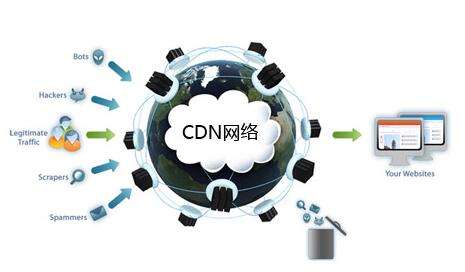

将静态内容(如图片、CSS)与动态API分离,分别使用CDN和负载均衡器处理,降低后端压力。 - 多地域容灾

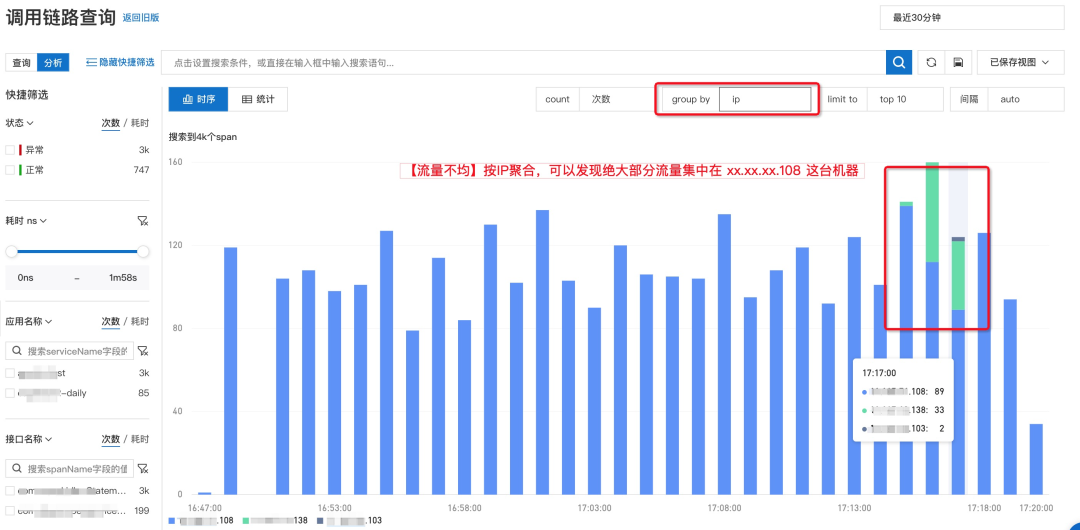

在多个地理位置部署服务器,通过全局负载均衡(如DNS轮询、Anycast)实现就近访问和灾备切换。 - 监控与日志分析

使用Prometheus、Grafana等工具实时监控流量分布,结合ELK(Elasticsearch, Logstash, Kibana)分析日志,优化负载策略。

案例:某视频网站通过Nginx加权轮询算法,将70%流量分配给高性能GPU服务器处理视频转码,同时使用HAProxy实现数据库读写的负载均衡,整体性能提升40%。

负载均衡与E-A-T原则的关联

- 专业性(Expertise):需根据业务场景选择合适算法,例如电商推荐加权轮询,实时通信建议最少连接。

- 权威性(Authoritativeness):引用行业标准(如HTTP/2协议支持)和权威云服务商方案(如AWS最佳实践)。

- 可信度(Trustworthiness):通过HTTPS加密传输、防火墙集成与定期安全审计,保障数据传输与节点安全性。

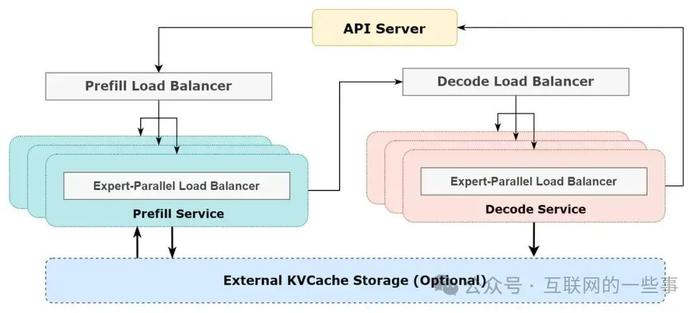

服务器负载均衡是构建高可用、高性能系统的基石,无论是初创公司还是大型企业,合理设计负载均衡策略可显著降低运维成本并提升用户体验,随着微服务、容器化(如Kubernetes)的普及,负载均衡技术将进一步与服务网格(Service Mesh)结合,迈向更智能的自动化管理阶段。

引用说明

本文参考了Nginx官方文档、AWS白皮书及《高可用架构设计实践》中的技术方案,结合行业案例进行了实践分析。