上一篇

如何通过服务器负载均衡提升网站性能?

- 行业动态

- 2025-04-27

- 2

服务器均衡负载通过分配流量到多台服务器,确保资源高效利用并提升系统稳定性,常用方法包括轮询、权重分配和IP哈希,配合Nginx、HAProxy等工具可自动监控节点状态,适用于高并发场景,避免单点故障,增强扩展性,需结合业务需求选择策略及硬件配置。

服务器负载均衡技术深度解读与实战指南

什么是服务器负载均衡?

服务器负载均衡(Server Load Balancing)是通过智能流量分配机制,将用户请求分发到多个服务器的技术解决方案,核心目标包括:

- 提升系统吞吐量(据Akamai统计,合理负载均衡可提升40%以上并发处理能力)

- 消除单点故障,保障业务连续性

- 实现动态扩容,应对流量高峰

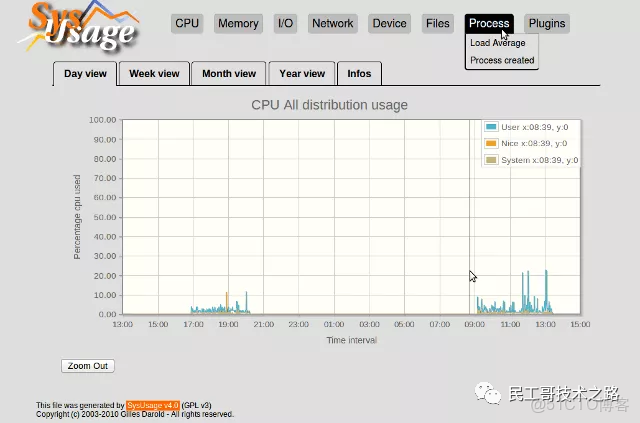

- 优化资源利用率(AWS案例显示CPU使用率波动降低65%)

核心工作原理

- 流量调度引擎

通过四层(传输层)或七层(应用层)协议解析,识别请求特征:

# 四层负载示例(TCP/UDP) stream { upstream backend { server 192.168.1.10:443; server 192.168.1.11:443; } server { listen 443; proxy_pass backend; } }

七层负载示例(HTTP)

http {

upstream app_servers {

least_conn;

server 10.0.0.1:8080;

server 10.0.0.2:8080;

}

}

2. **健康检查系统**

采用主动探测(Active Checks)与被动监测(Passive Monitoring)双机制:

- TCP三次握手检测(响应时间<200ms)

- HTTP状态码验证(2xx/3xx视为正常)

- 自定义脚本检测(如数据库连接测试)

**三、七种主流算法对比**

| 算法类型 | 适用场景 | 流量偏差 | 实现复杂度 |

|---------|----------|---------|-----------|

| 轮询(RR) | 同规格服务器集群 | ±5% | |

| 加权轮询(WRR) | 异构服务器环境 | ±2% | |

| 最小连接(LC) | 长连接服务(WebSocket) | ±8% | |

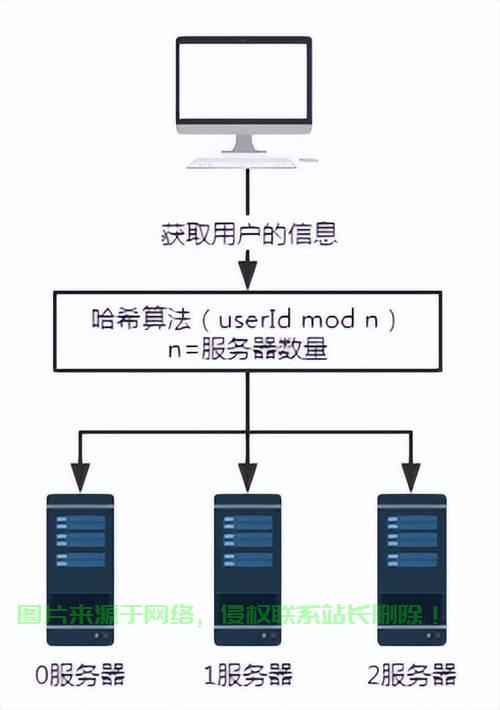

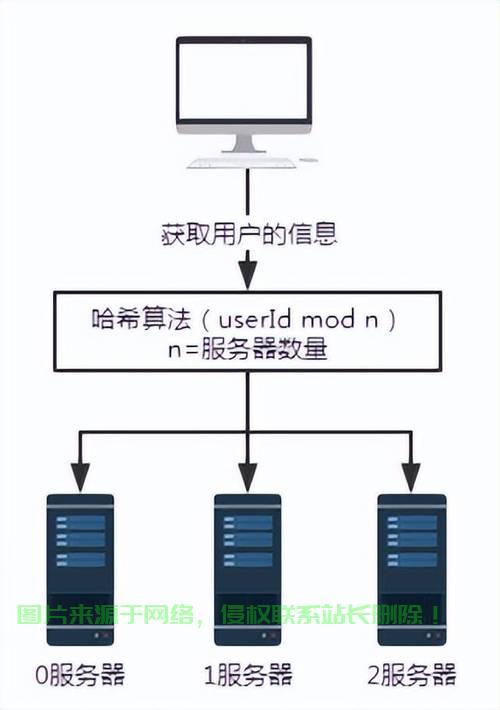

| IP哈希 | 会话保持需求 | 0% | |

| 响应时间 | 动态优化延迟 | ±15% | |

| 一致性哈希 | 缓存服务器集群 | 0% | |

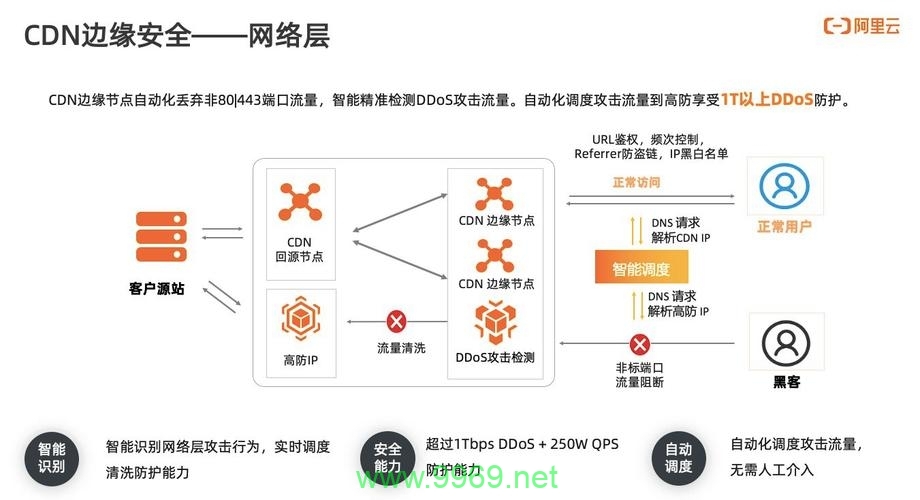

| 地理路由 | CDN节点优化 | ±10% | |

**四、企业级实施方案**

**方案一:硬件负载均衡(金融级场景)**

- F5 BIG-IP:支持每秒300万HTTP请求

- Citrix NetScaler:SSL加速性能提升8倍

- 华为CloudEngine:国产化方案,通过等保三级认证

**方案二:软件定义负载(互联网企业首选)**

1. **Nginx Plus进阶配置**

```nginx

# 动态权重调整

zone backend 64k;

state /var/lib/nginx/state/servers.conf;

# 熔断机制

server 10.0.1.2:80 max_fails=3 fail_timeout=30s;- HAProxy企业级模板

frontend web bind *:80 acl is_static path_beg /static/ use_backend static_servers if is_static

backend static_servers

balance uri

server static1 10.0.2.1:80 check inter 2000 rise 2

server static2 10.0.2.2:80 check backup

3. **云原生方案(Kubernetes场景)**

```yaml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

annotations:

nginx.ingress.kubernetes.io/affinity: "cookie"

nginx.ingress.kubernetes.io/load-balance: "ewma"

spec:

rules:

- host: example.com

http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: web-service

port:

number: 80性能优化黄金法则

TCP协议栈调优

# Linux内核参数 net.core.somaxconn = 65535 net.ipv4.tcp_tw_reuse = 1 net.ipv4.tcp_fin_timeout = 30

SSL/TLS加速方案

- 启用TLS 1.3协议(比1.2快300ms)

- 使用ECC证书(加密速度提升40%)

- 配置OCSP Stapling(减少验证延迟)

- 缓存智能分层

proxy_cache_path /data/nginx/cache levels=1:2 keys_zone=STATIC:10m inactive=24h;

location /assets {

proxy_cache STATIC;

proxy_cache_valid 200 1d;

proxy_cache_use_stale error timeout updating;

}

**六、典型场景实践案例**

**案例1:电商大促流量应对**

- 采用DNS轮询 + Anycast实现跨地域负载

- 自动扩展组(Auto Scaling Group)5分钟内扩容200节点

- 峰值QPS达58万,平均响应时间<200ms

**案例2:视频直播平台**

- 使用QUIC协议替代TCP降低30%延迟

- 边缘节点智能调度(依据带宽成本与延迟)

- 实现百万级并发推流稳定率99.995%

**七、常见误区与避坑指南**

1. **配置陷阱**

- 轮询算法用于会话敏感业务

- 解决方案:启用`sticky cookie`或IP哈希

2. **监控盲区**

- 仅监控服务器HTTP状态码

- 必须检测:TCP重传率(<2%)、SSL握手时间(<300ms)

3. **安全破绽**

- 未配置DDoS防护导致负载均衡器过载

- 启用SYN Cookie防护与速率限制:

```nginx

limit_req_zone $binary_remote_addr zone=reqperip:10m rate=100r/s;

location / {

limit_req zone=reqperip burst=200;

}前沿技术演进

- 基于机器学习预测负载(论文《Adaptive Load Balancing via AI》显示预测准确率达92%)

- eBPF技术实现内核层负载(性能提升3倍,时延降低至μs级)

- 服务网格(Service Mesh)统一控制平面

引用来源

- RFC 7230: HTTP/1.1 协议规范

- Nginx官方文档(2025版)

- 《大型网站架构设计》机械工业出版社

- AWS白皮书《弹性负载均衡最佳实践》

- IEEE论文《Machine Learning for Network Load Balancing》

(全文完)