上一篇

http负载均衡和反向代理

- 行业动态

- 2025-04-27

- 3010

HTTP负载均衡通过分发请求至多服务器提升性能,反向代理则转发请求并隐藏后端,两者均可用Nginx实现,但负载均衡侧重流量分配, 反向代理侧重请求处理与隐藏源

HTTP负载均衡与反向代理详解

核心概念对比

| 特性 | HTTP负载均衡 | 反向代理 |

|---|---|---|

| 核心目标 | 分发请求到多台服务器,提升处理能力 | 隐藏后端服务器,统一入口,增强安全性 |

| 工作机制 | 基于算法(轮询、IP哈希等)分配请求 | 接收请求后转发至指定后端服务器 |

| 典型场景 | 高并发网站、API服务 | 隐藏内网架构、跨域访问、SSL终止 |

| 性能优化 | 侧重请求分发效率 | 侧重缓存静态资源、压缩传输 |

| 是否需要多后端 | 必须(至少2台服务器) | 可单可多(单节点也可完成基础功能) |

工作原理解析

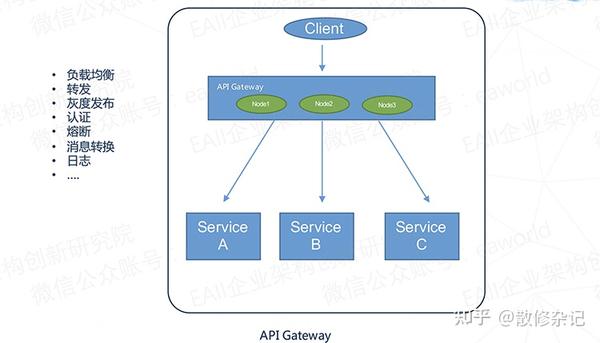

HTTP负载均衡

- 请求分发:用户请求先到达负载均衡器,通过算法(如轮询、最少连接、IP哈希)选择最优后端服务器。

- 健康检查:定期检测后端服务器状态(如TCP探针、HTTP状态码),自动剔除故障节点。

- 会话保持:通过Cookie插入或IP绑定,确保同一用户的请求落在同一服务器(如电商购物车场景)。

- 示例技术:LVS、Nginx Upstream、HAProxy、Cloud Load Balancer(如AWS ELB)。

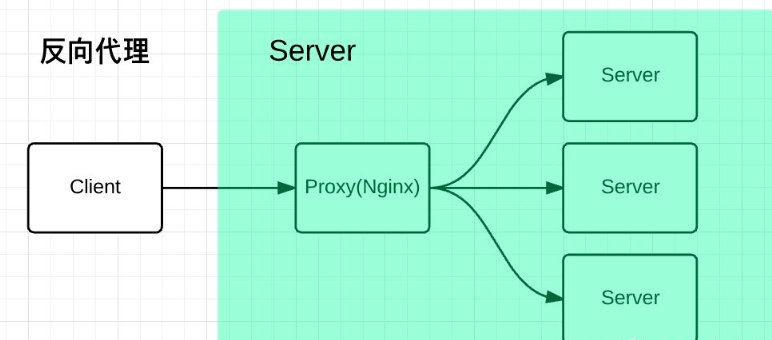

反向代理

- 请求转发:用户请求发送到反向代理服务器(如Nginx),由其转发至后端应用服务器群。

- 功能扩展:

- 缓存:存储静态资源(CSS/JS/图片),减少后端压力。

- SSL终止:在代理层解密HTTPS请求,后端使用HTTP通信,降低加密开销。

- 动静分离:根据URL路径将请求路由至不同后端(如API服务、静态资源服务器)。

- 示例技术:Nginx、Apache、Traefik、Varnish(专用缓存代理)。

典型配置示例(以Nginx为例)

反向代理配置

server { listen 80; server_name example.com; location / { proxy_pass http://127.0.0.1:8080; # 转发至后端服务 proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; } }负载均衡配置

upstream backend { server 192.168.1.101; # 后端服务器1 server 192.168.1.102; # 后端服务器2 } server { listen 80; server_name example.com; location / { proxy_pass http://backend; # 轮询分发 proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; } }

关键差异归纳

- 负载均衡:解决“如何高效分配请求”问题,关注横向扩展能力。

- 反向代理:解决“如何隐藏后端复杂度”问题,提供安全缓冲层。

- 协同场景:反向代理前置负载均衡(如Nginx反向代理 + Upstream负载均衡),兼具流量分发与安全隐藏。

相关问题与解答

问题1:能否在同一系统中同时使用负载均衡和反向代理?

解答:

可以,典型组合为:

- 反向代理层(如Nginx):负责SSL终止、静态资源缓存、请求路由。

- 负载均衡层(如Nginx Upstream):将动态请求分发至后端应用集群。

优势:既隐藏后端架构,又提升处理能力。server { listen 443 ssl; # SSL终止 location /api/ { proxy_pass http://load_balancer; # 转发至负载均衡器 } }

问题2:反向代理是否会影响性能?如何优化?

解答:

潜在影响:

- 增加请求转发延迟(微秒级,通常可忽略)。

- 缓存不当可能导致数据过时或内存占用过高。

优化方案:

- 启用缓存:对静态资源设置缓存策略(如

proxy_cache_path)。 - 连接复用:配置

proxy_http_version 1.1和proxy_set_header Connection ""。 - 压缩传输:启用GZIP压缩(

gzip on),减少带宽消耗。 - 限流策略:通过

limit_req模块防止反面流量击穿代理服务器