上一篇

反向代理实现负载均衡

- 行业动态

- 2025-05-03

- 2

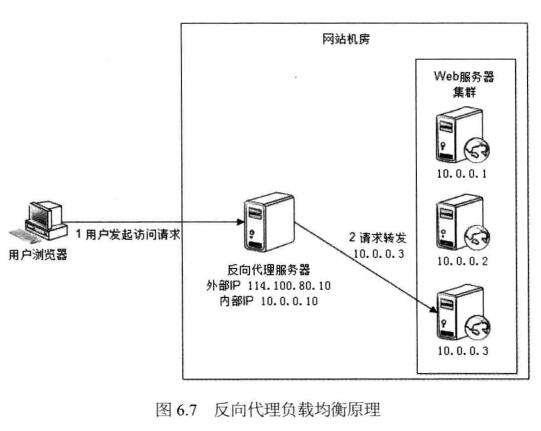

反向代理通过接收客户端请求,按轮询、权重等策略将流量分发至多台源服务器,实现请求均衡负载,同时隐藏后端架构,提升

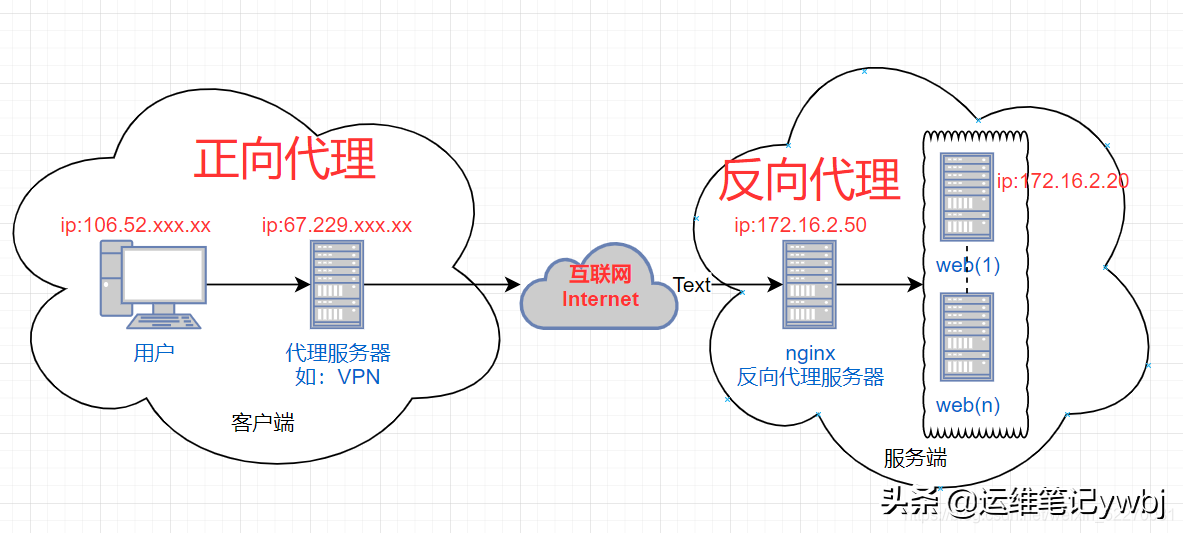

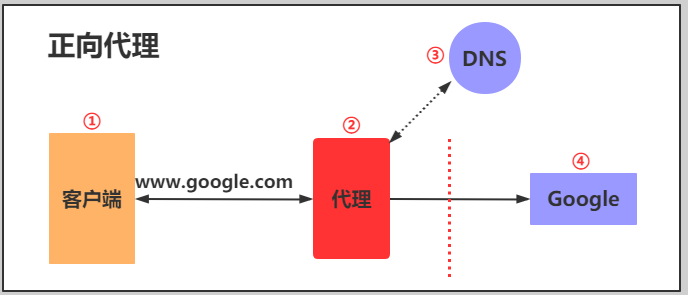

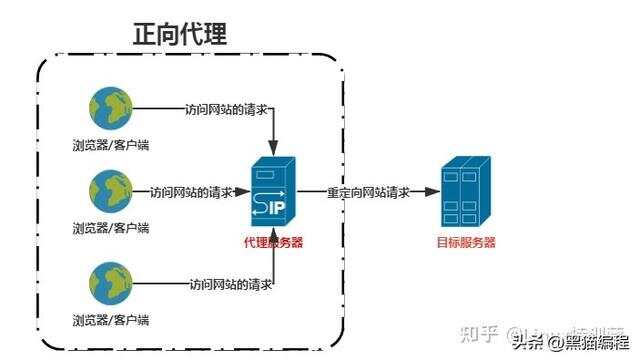

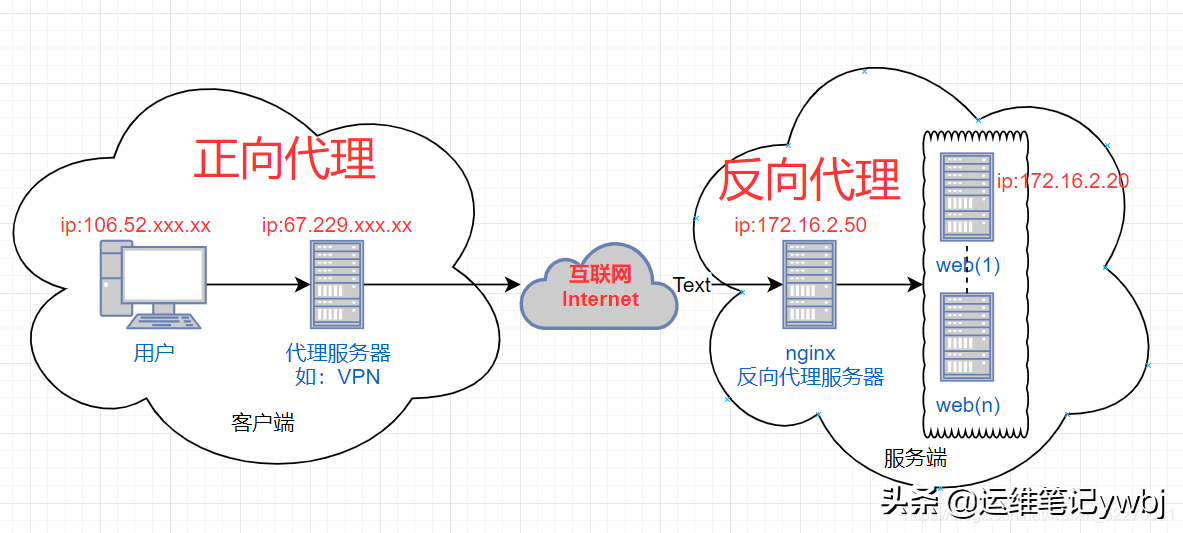

反向代理与负载均衡是现代网络架构中提升服务可用性和性能的核心技术组合,通过反向代理服务器实现流量分发,既能隐藏后端服务器真实地址,又能均衡处理客户端请求,这种组合在高并发场景下尤为重要,以下是关于反向代理实现负载均衡的系统性解析:

核心概念解析

| 技术类型 | 定义 | 典型应用场景 |

|---|---|---|

| 反向代理 | 以代理服务器接收客户端请求,转发至后端服务器群,返回响应给客户端 | 网站加速、安全防护、负载均衡 |

| 负载均衡 | 将传入请求按策略分配到多台服务器,避免单点过载 | 电商大促、云计算资源调度 |

反向代理服务器(如Nginx、Apache)作为流量入口,通过负载均衡算法将请求分发给后端服务器集群,这种架构既实现了请求的智能分发,又提供了SSL卸载、缓存加速等附加功能。

负载均衡实现机制

主流负载均衡策略对比:

| 策略类型 | 工作原理 | 适用场景 |

|---|---|---|

| 轮询(Round Robin) | 按顺序循环分配请求给后端服务器 | 服务器性能相近的场景 |

| 加权轮询 | 为不同服务器设置权重比例,按权重分配请求 | 服务器性能差异显著的环境 |

| IP哈希 | 根据客户端IP计算哈希值,固定分配到特定服务器 | 需要会话保持的Web应用 |

| 最少连接数 | 动态选择当前连接数最少的服务器 | 长连接/请求处理时间差异大的场景 |

实际部署中常采用混合策略,例如Nginx默认使用加权轮询,同时支持IP哈希会话保持,某电商平台通过Nginx实现的负载均衡架构示例:

http {

upstream backend {

server 192.168.1.101 weight=5; # 高性能服务器

server 192.168.1.102 weight=3; # 标准服务器

server 192.168.1.103 max_fails=3; # 容错机制

}

server {

location / {

proxy_pass http://backend;

proxy_set_header X-Real-IP $remote_addr;

}

}

}高级功能实现

健康检查

通过主动探测(如TCP连接测试)或被动监控(统计响应状态码),自动剔除故障节点,Nginx配置示例:server 192.168.1.103 max_fails=2 fail_timeout=30s;

会话保持

采用Cookie插入或IP哈希技术维持用户会话连续性,电商购物车场景常使用:proxy_set_header Cookie $proxy_cookie;

动静分离

通过正则匹配实现静态资源与动态请求的分流:location ~ .(jpg|css)$ { root /data/static; } location /api { proxy_pass http://backend_api; }

性能优化策略

| 优化维度 | 实施方法 |

|---|---|

| 连接复用 | 启用Keep-Alive减少TCP握手开销 |

| 缓存机制 | 配置代理缓存(如Squid)存储静态内容 |

| SSL优化 | 在反向代理层终止SSL,减少后端服务器加密开销 |

| 压缩传输 | 启用gzip压缩降低带宽占用(需权衡CPU消耗) |

实测数据显示,启用连接复用可使Web服务器吞吐量提升30%-50%,SSL终止可降低后端CPU消耗约40%。

典型故障排查

| 问题现象 | 可能原因 | 解决方案 |

|---|---|---|

| 请求响应延迟 | 后端服务器过载 | 增加权重/扩容节点 |

| 频繁502错误 | 健康检查配置不当 | 调整fail_timeout参数 |

| Session丢失 | 未开启会话保持 | 添加IP哈希策略 |

| SSL证书报错 | 证书链不完整 | 检查CA证书配置 |

FAQs

Q1:反向代理与CDN有什么区别?

A:核心差异在于服务层级,CDN侧重全球范围的内容缓存加速,通过边缘节点分发静态资源;反向代理主要在数据中心层面进行流量调度,处理动态请求,两者常配合使用,CDN作为前端缓存层,反向代理负责内部负载均衡。

Q2:如何选择负载均衡算法?

A:需结合业务特性评估:

- 无状态API服务 → 轮询/加权轮询

- 用户登录系统 → IP哈希

- 视频流媒体 → 最少连接数

建议通过压力测试验证不同算法的性能表现,Nginx支持运行时动态切换