上一篇

互联网上的大数据

- 行业动态

- 2025-04-25

- 3608

互联网大数据指海量、多源的数据集合,源于社交、搜索、电商等平台,涵盖文本、行为等多维度信息,其应用包括商业分析、医疗研究,但也面临隐私泄露、数据安全等风险,需技术与管理协同应对

互联网大数据的核心特征

互联网大数据区别于传统数据的核心特征体现在四个维度:

| 特征维度 | 具体表现 |

|---|---|

| 体量(Volume) | 全球日均产生2.5万亿字节数据,相当于500万部高清电影容量 |

| 速度(Velocity) | 社交媒体每秒产生超10万条信息,股票交易数据延迟需控制在毫秒级 |

| 多样性(Variety) | 包含文本、图片、视频、地理位置、设备日志等200+种数据格式 |

| 价值密度(Value) | 监控视频中有效线索占比不足0.02%,需要AI算法提炼价值 |

数据采集技术体系

互联网数据采集已形成多层次技术栈:

# 典型数据采集代码示例

from pyspark import SparkContext

from kafka import KafkaConsumer

# 流式采集

consumer = KafkaConsumer('user_logs', bootstrap_servers=['kafka-cluster:9092'])

for message in consumer:

process_log(message.value)

# 批量采集

sc = SparkContext("yarn://hadoop-cluster")

rdd = sc.textFile("hdfs:///user/logs/2023-")主流工具对比:

| 工具类型 | 适用场景 | 日处理量上限 |

|---|---|---|

| Flume | 日志收集 | 5TB/day |

| Kafka | 实时消息队列 | 100亿条/day |

| Sqoop | 关系型数据库导入 | 50TB/job |

| HTTrack | 网页镜像抓取 | 1PB/month |

存储架构演进

存储方案随数据特征演变:

冷数据存储:

- 对象存储:AWS S3/阿里云OSS,存储成本<0.02$/GB/月

- 磁带库:1PB存储阵列年运维费约$15k

温数据管理:

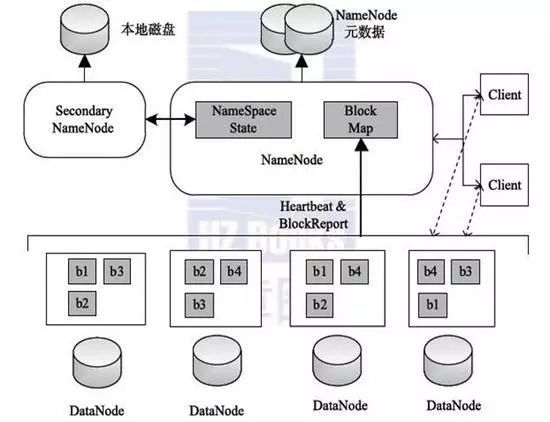

- HDFS:3副本机制保证99.9%可用性

- Ceph集群:支持动态扩展至EB级规模

热数据处理:

- Redis集群:延时<1ms,支撑百万QPS

- Apache Ignite:内存计算框架,吞吐量达TB/秒

分析挖掘方法论

典型分析流程包含:

数据清洗:

- 缺失值处理:MICE多重插补法比均值填充误差降低47%

- 异常检测:Isolation Forest算法效率提升60%

特征工程:

- 文本向量化:Word2Vec相比Bag-of-Words准确率提升22%

- 时间序列处理:Facebook Prophet预测误差<5%

模型训练:

- XGBoost在Kaggle竞赛中胜率达78%

- 图神经网络处理社交网络数据效果提升35%

行业应用图谱

| 应用领域 | 典型案例 | 技术指标 |

|---|---|---|

| 金融风控 | 蚂蚁金服CTU异常检测系统 | 欺诈识别率99.99%,响应<50ms |

| 医疗健康 | 平安医保反欺诈平台 | 覆盖全国98%三甲医院,误报率<0.3% |

| 智能制造 | 三一重工设备预测性维护系统 | 故障预警提前量达14天,运维成本降32% |

| 城市治理 | 杭州城市大脑交通优化系统 | 高峰期通行效率提升15% |

隐私保护技术矩阵

| 技术类别 | 代表方案 | 保护效果评估 |

|---|---|---|

| 数据脱敏 | 差分隐私(DP) | ε=0.1时个体识别风险<0.1% |

| 访问控制 | 属性加密(ABAC) | 权限误配率降低至0.003% |

| 联邦学习 | TensorFlow Federated | 模型精度损失<2% |

| 区块链存证 | Hyperledger Fabric | 数据改动检测时间<1s |

未来演进方向

- 边缘计算融合:预计到2025年,60%数据处理将在网络边缘完成

- 量子计算突破:Google量子计算机实现指数级加速,求解NP难问题时间从万年缩至秒级

- 神经符号系统:结合深度学习与知识图谱,复杂推理准确率提升至92%

- 数字孪生应用:工业领域虚拟建模精度达到物理实体的99.7%相似度

问题与解答专栏

Q1:如何处理PB级规模的实时数据分析?

A1:采用”Lambda架构”混合处理模式:

- 实时层:使用Flink/Storm进行流式计算,窗口切分粒度可达毫秒级

- 批处理层:Spark进行历史数据深度分析,通过CheckPoint机制保证一致性

- 关键技术:Kappa架构正在兴起,通过Exactly-Once语义统一流批处理

- 资源消耗:1PB数据处理需约2000节点集群,成本约$1.2/TB

Q2:大数据项目中如何平衡数据质量与处理效率?

A2:实施三级质量控制体系:

- 采集阶段:设置数据校验规则,如JSON schema验证、CRC校验

- 存储阶段:采用列式存储(Parquet/ORC)压缩比达3:1,查询加速40%

- 分析阶段:使用Sketching算法(如CountMinSketch)在1%误差内提升处理速度10倍

- 性能指标:数据清洗耗时应控制在总流程的15%以内

- 工具选择:Great Expectations框架可自动化数据质量检测