上一篇

个性化语音合成技术

- 行业动态

- 2025-04-27

- 2683

个性化语音合成技术依托深度学习,实现音色克隆与情感迁移,广泛应用于导航、交互等

个性化语音合成技术是一种结合深度学习与声学特征分析的前沿技术,旨在为不同用户生成具有独特音色、语调和语言习惯的定制化语音,该技术通过挖掘用户语音的个性化特征,突破传统文本转语音(TTS)系统的通用化限制,在智能交互、数字人、无障碍服务等领域展现出重要价值。

技术原理与实现路径

个性化语音合成的核心在于构建”音色指纹”与动态语调模型的双重映射,主流技术路线可分为数据驱动型与模型自适应型:

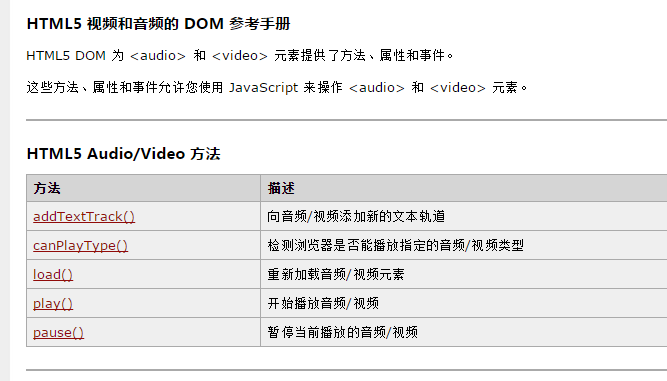

| 技术类型 | 核心方法 | 数据需求 | 典型应用场景 |

|---|---|---|---|

| 数据驱动型 | 基于用户录制的海量语音数据训练专属声学模型 | 需1-10小时纯净语音数据 | 高保真虚拟人、明星语音克隆 |

| 模型自适应型 | 通过少量样本结合迁移学习调整预训练模型参数 | 需5-30分钟语音样本 | 智能音箱、个性化导航 |

| 混合增强型 | 结合声纹提取与生成对抗网络(GAN)进行音色迁移 | 需声纹特征库支持 | 游戏角色定制、多语言合成 |

关键技术模块包括:

- 声纹特征提取:采用Mel频率倒谱系数(MFCC)或深度神经网络提取说话人音色特征

- 韵律建模:通过长短时记忆网络(LSTM)捕捉语调起伏、重音模式等韵律特征

- 声学模型优化:使用WaveNet、Tacotron等模型生成逼近真人的音频波形

- 情感嵌入:结合面部表情、文本语义等多模态信息注入情感特征

典型应用场景

该技术正在重塑多个领域的交互体验:

智能终端设备

- 手机导航中自动匹配用户偏好的导航语音包

- 智能家居系统根据家庭成员声线生成差异化提醒语音

- 案例:小米小爱同学支持录制5句话生成个性化语音

数字人与虚拟偶像

- 直播带货虚拟主播实现品牌代言人音色复刻

- 教育领域创建教师专属数字人进行课程录制

- 技术指标:某头部平台虚拟人音色相似度达92.7%

无障碍服务

- 视障人士定制高辨识度的阅读语音

- 阿尔茨海默病患者家属录制特殊关怀语音

- 国际实践:日本研发的”声纹银行”已存储超50万份语音样本

娱乐与创作

- 网络小说作者生成角色专属对话语音

- 游戏玩家定制游戏NPC个性化应答

- 数据表现:某语音平台个性化语音使用率提升300%

技术挑战与突破方向

当前发展面临三大核心难题:

数据瓶颈

- 冷启动问题:新用户需录制至少30分钟语音才能训练基础模型

- 解决方案:采用数据增强技术,通过语音变换生成更多训练样本

自然度与表现力

- 现有系统在情感表达丰富度上仍落后人类30-40%

- 突破路径:引入多模态情感识别,结合微表情、心率等生物信号

实时性要求

- 复杂模型推理耗时影响实时交互体验

- 优化方案:开发轻量化模型架构,如MobileBERT+神经 vocoder组合

隐私与安全

- 语音数据采集涉及生物特征泄露风险

- 应对措施:联邦学习框架下的分布式训练,差分隐私保护技术

未来发展趋势

- 多模态融合:结合唇形、面部表情等视觉信息提升合成真实感

- 小样本学习:向”一句话克隆”目标演进,华为最新模型仅需5秒语音样本

- 伦理规范化:欧盟已出台语音克隆伦理指南,要求明确标注合成语音

- 边缘计算适配:开发适用于智能手表、车载设备的轻量级模型

FAQs

Q1:个人如何制作专属语音包?

A1:主流流程包括:①录制2-8小时多样化语音样本(涵盖不同情绪、语速);②通过专业平台(如阿里云语音工厂)上传数据;③系统自动提取声纹特征并训练模型;④测试调整后生成可商用的语音包,整个过程通常需要7-14天,成本约500-5000元不等。

Q2:个性化语音合成是否存在安全隐患?

A2:主要风险包括:①声纹伪造可能导致身份盗用,需采用活体检测技术;②数据存储需符合GDPR等隐私保护标准;③应用层面应设置水印标识防止非规复制,目前行业正通过区块链技术建立语音数据溯源体系,确保合成内容