上一篇

什么是存储与处理数据的文件?

在数字化时代,数据是企业和个人的核心资产,存储和处理数据的文件是承载信息并支持其高效操作的关键载体,其形式多样,包括文本文件、数据库文件、图像文件等,这些文件需结合特定技术和工具,才能实现数据的持久化存储和动态分析。

常见存储数据的文件类型

- 文本文件(TXT/CSV):纯文本格式,轻量且兼容性强,适合存储结构化或半结构化数据,CSV文件通过逗号分隔字段,广泛用于数据交换。

- 结构化文件(XML/JSON):支持嵌套数据,常用于API交互和配置文件,JSON以键值对形式存储数据,更易被现代编程语言解析。

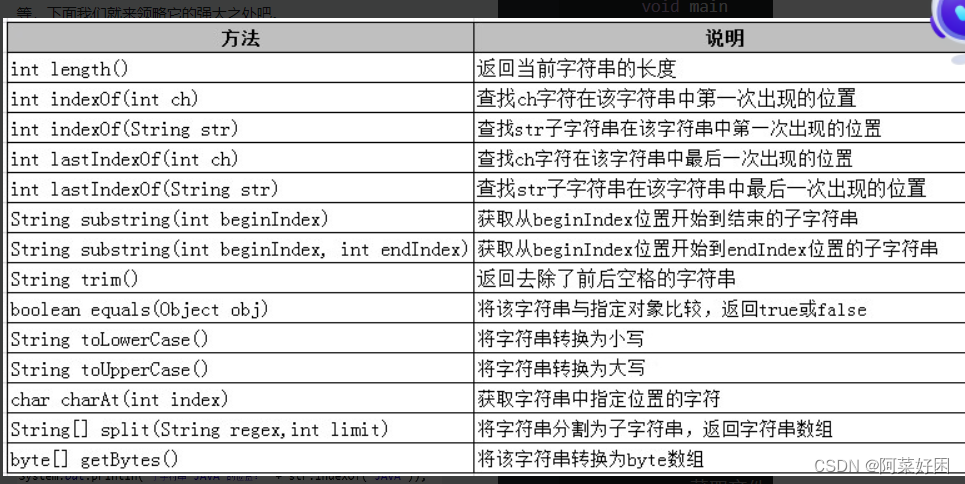

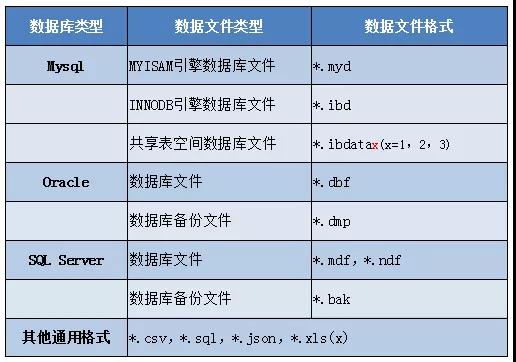

- 二进制文件(数据库文件/图像文件):以二进制编码保存,如MySQL的

.ibd文件或JPEG图像,这类文件存储效率高,但需专用工具读写。 - 专有格式文件(Excel/Parquet):Excel支持公式和图表;Parquet采用列式存储,适合大数据分析场景,压缩率比CSV高75%以上。

| 类型 | 优势 | 局限 | 典型场景 |

|---|---|---|---|

| CSV | 跨平台兼容 | 无数据类型校验 | 数据导入导出 |

| JSON | 支持复杂结构 | 冗余度高 | API接口数据 |

| Parquet | 高效压缩 | 需依赖专用库 | 大数据分析 |

数据存储的核心技术

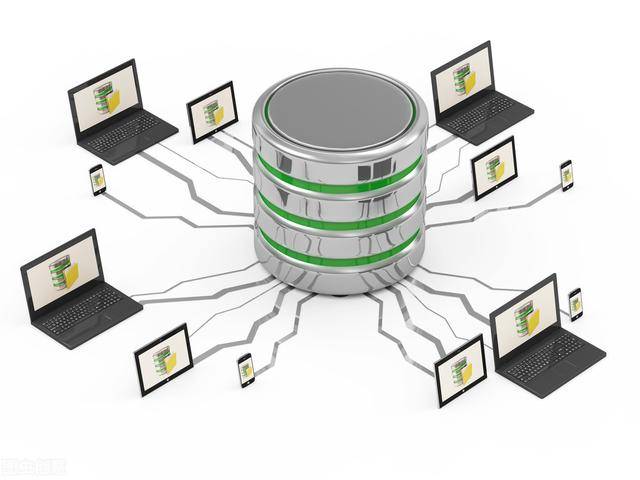

数据库系统

- 关系型数据库(MySQL/Oracle):通过SQL管理结构化数据,支持ACID事务,适合财务系统等高一致性场景。

- 非关系型数据库(MongoDB/Redis):MongoDB支持灵活文档结构,Redis以内存存储实现毫秒级响应。

云存储与分布式系统

- AWS S3提供99.999999999%持久性,支持PB级数据存储。

- HDFS(Hadoop分布式文件系统)将文件切片存储于多节点,实现高吞吐量。

数据处理的关键技术与工具

- ETL工具(Informatica/Talend):实现数据清洗转换,例如将CSV数据加载到数据仓库。

- 编程语言库(Python Pandas/Spark):Pandas支持DataFrame操作,Spark可在集群中并行处理TB级数据。

选择文件与技术的决策框架

- 数据规模:单机小数据可用CSV,PB级数据需HDFS+Parquet。

- 访问模式:随机读写选数据库,批量分析用列式存储。

- 一致性要求:金融交易需关系型数据库,日志分析可接受最终一致性。

行业应用案例

- 电商推荐系统:用户行为数据以JSON格式存入MongoDB,通过Spark实时生成推荐结果。

- 物联网设备监控:传感器数据以Parquet存储于HDFS,用Flink进行流式异常检测。

参考文献

- Apache Parquet官方文档(parquet.apache.org)

- AWS S3存储类别白皮书(aws.amazon.com/s3)

- MongoDB数据建模指南(mongodb.com)