上一篇

文件数据如何高效导入导出数据库?快速操作教程分享

- 行业动态

- 2025-04-15

- 2007

通过文件与数据库交互可实现数据高效迁移,程序通常先读取文件内容(如CSV、JSON),经格式转换后批量导入数据库;查询时从库中提取数据,按需生成结构化文件进行本地存储,确保信息同步与持久化。

文件存入数据库的核心步骤

文件格式解析

根据文件类型(如CSV、JSON、Excel)选择对应解析工具。- Python的

pandas库可快速读取Excel或CSV文件:import pandas as pd data = pd.read_csv('data.csv') - JSON文件可使用内置的

json模块解析。

- Python的

数据清洗与验证

- 过滤无效字符(如SQL注入符号或)。

- 检查数据类型(如日期格式是否统一)。

- 处理缺失值(填充默认值或删除空行)。

数据库连接与写入

使用编程语言对应的数据库驱动(如Python的sqlite3、pymysql),通过以下步骤操作:- 建立数据库连接

import sqlite3 conn = sqlite3.connect('database.db') cursor = conn.cursor() - 执行SQL语句

推荐参数化查询防止注入攻击:cursor.executemany('INSERT INTO table VALUES (?, ?)', data_tuples) - 提交事务并关闭连接

conn.commit() conn.close()

- 建立数据库连接

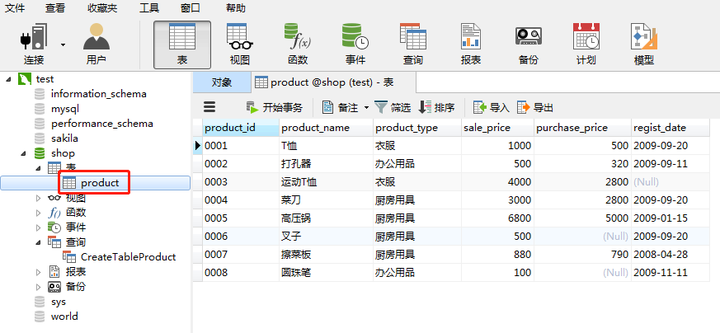

从数据库读取数据的核心方法

直接查询与导出

执行SELECT语句获取数据,转换为所需格式:cursor.execute('SELECT * FROM table') results = cursor.fetchall() df = pd.DataFrame(results, columns=['col1', 'col2']) df.to_csv('output.csv', index=False)批量处理优化

- 使用分页查询(

LIMIT和OFFSET)避免内存溢出。 - 启用数据库连接池(如

SQLAlchemy)提升并发性能。

- 使用分页查询(

安全与权限控制

- 为数据库用户分配最小必要权限(如只读权限)。

- 记录操作日志,便于审计追踪。

必须注意的实践细节

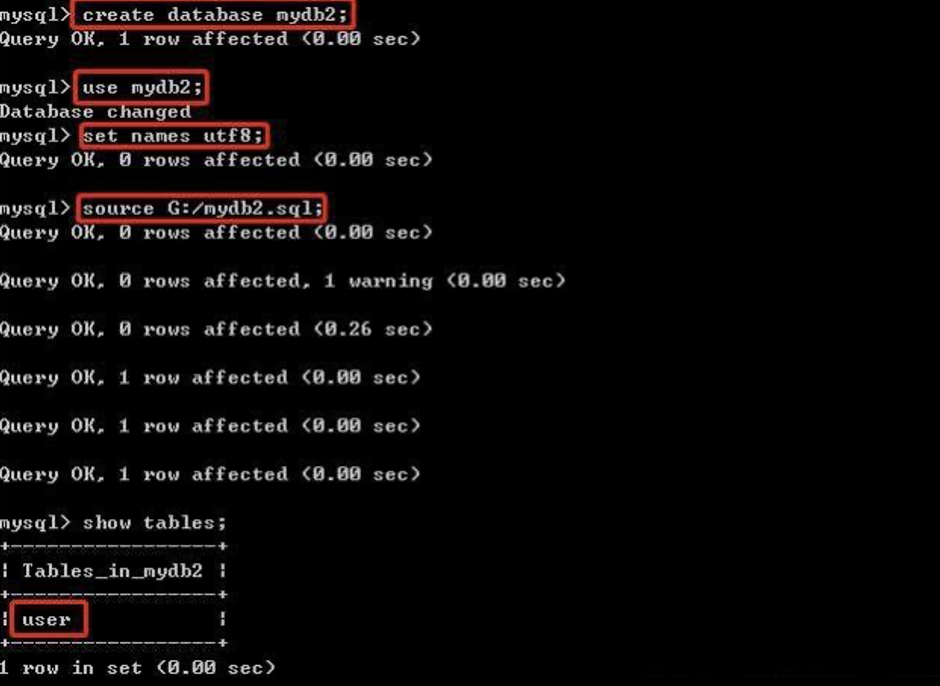

字符编码统一

确保文件、程序、数据库三端的编码一致(推荐UTF-8),避免中文乱码。事务与回滚机制

写入数据时启用事务,出错时执行rollback()保证数据一致性:try: cursor.execute(sql) conn.commit() except Exception as e: conn.rollback()大文件分块处理

当文件超过100MB时,采用流式读取(如Python的csv.reader逐行加载)或分批次插入。数据类型映射

数据库字段类型需与文件数据匹配,- 文本文件中的数字可能被误判为字符串,需显式转换。

- 日期字段需统一时区。

常见问题与解决方案

问题1:导入速度慢

优化方案:- 关闭数据库自动提交(

autocommit=False)。 - 使用批量插入(

executemany)替代逐行插入。

- 关闭数据库自动提交(

问题2:特殊字符导致报错

解决方案:- 转义单引号(→)。

- 使用ORM框架(如Django ORM)自动处理转义。

问题3:不同数据库兼容性

差异化处理:- MySQL使用

LOAD DATA INFILE快速导入CSV。 - MongoDB通过

mongoimport工具直接导入JSON。

- MySQL使用

引用说明

本文代码示例参考来源:

- Python官方文档(https://docs.python.org/3/library/sqlite3.html)

- MySQL 8.0参考手册(https://dev.mysql.com/doc/)

- Pandas文档(https://pandas.pydata.org/docs/)

- MongoDB官方指南(https://www.mongodb.com/docs/)