openstack物理机损坏

- 物理机

- 2025-08-03

- 23

OpenStack云计算环境中,物理机的稳定运行是保障上层虚拟机和服务正常运转的基础,当物理机发生损坏时(如硬件故障、系统崩溃或引导文件丢失),若未及时采取有效措施,可能导致业务中断甚至数据丢失,以下是针对OpenStack物理机损坏场景的详细处理流程与技术要点:

物理机硬盘故障的处理方案

-

前置准备与风险规避

- 新硬盘选型要求:必须使用同型号、同系列、同容量的全新或未分区/格式化的硬盘,并插入原RAID通道对应的插槽,以确保兼容性和数据一致性;

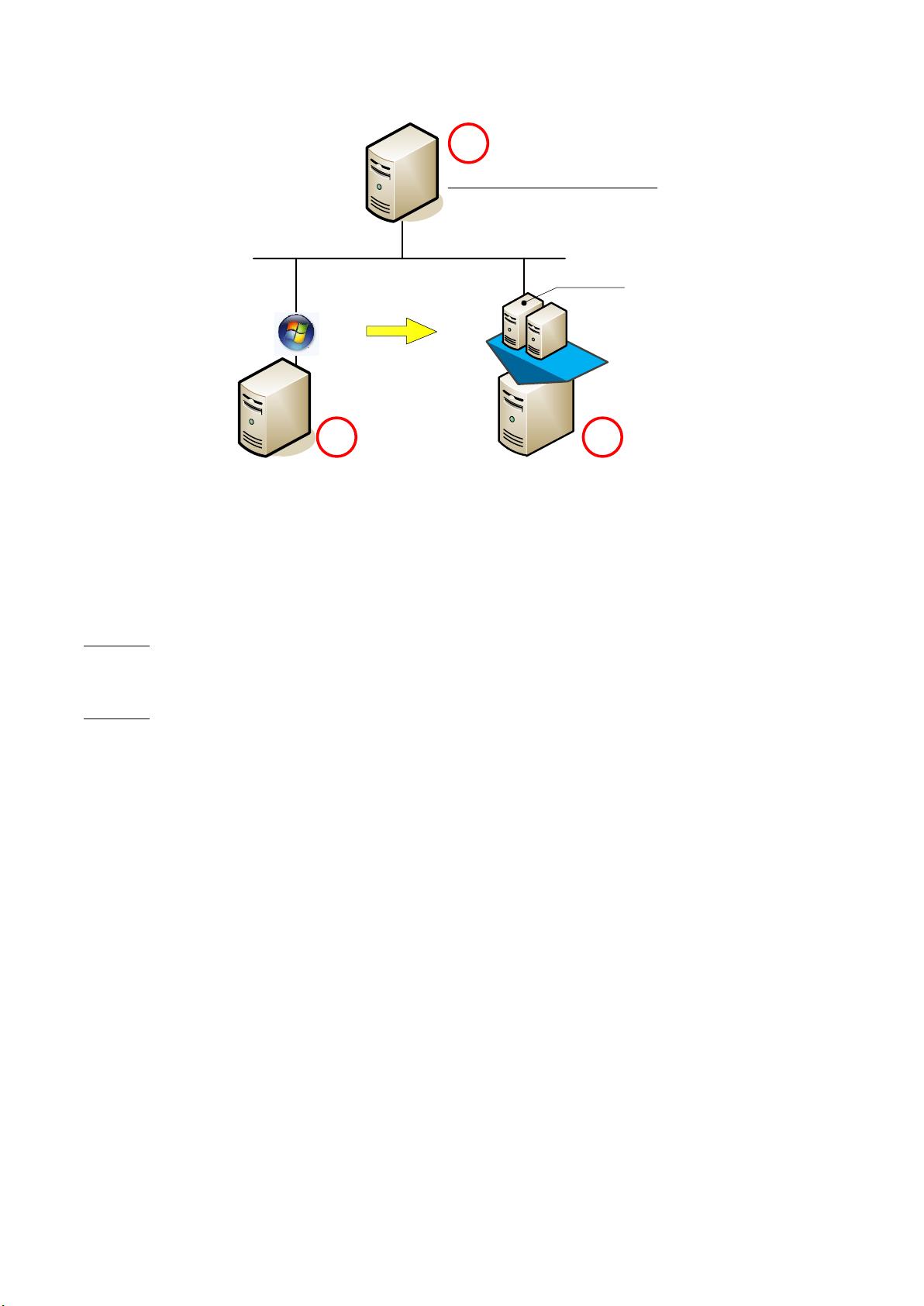

- 关键业务保护机制:对于承载重要云主机的故障物理机,需优先执行热迁移操作,通过OpenStack管理控制台进入“资源中心→硬件设施→计算设施→物理机”界面,定位目标机器后,在其关联的云主机列表中选择待迁移实例,点击“操作>更改物理机”,勾选“启用自动收敛模式”以提高迁移成功率,建议并发迁移任务不超过三个以避免资源争用;

- 维护模式切换:完成迁移后,将故障物理机置于维护状态(操作路径同上),阻止新的任务调度到该节点。

-

硬件更换与验证步骤

- 安全关机操作:通过SSH登录服务器执行双次

sync命令确保缓存写入磁盘,随后输入poweroff命令完全关闭电源; - 阵列配置检查:启动服务器后进入阵列卡BIOS界面,确认新硬盘状态显示为“Rebuild”(重建中),表明正在同步数据;或者登录带外管理页面监控进度;

- 网络连通性测试:重启后使用

zs-show-network命令验证管理网和存储网的网卡状态是否正常,这是后续恢复服务的必要条件。

- 安全关机操作:通过SSH登录服务器执行双次

-

服务恢复流程

当新硬盘就绪且网络正常时,在OpenStack界面退出维护模式,系统将自动重新接纳该节点参与资源调度,此时可将之前迁出的云主机反向迁移回原物理机,逐步恢复正常负载。

底层系统损坏的修复策略

若物理机因异常断电等原因导致GRUB配置丢失、MBR损坏或启动报错(如“Attempted to kill init”),可参照Linux云主机系统修复方案进行干预:

- 引导程序重建:利用Live ISO挂载系统分区,重写GRUB引导信息并修复主引导记录;

- 紧急模式自救:若进入应急Shell环境,可通过

chroot命令挂载根文件系统,手动修正/etc/fstab等关键配置文件; - 镜像还原兜底:预先制作的系统快照此时可发挥作用,通过裸金属服务(Ironic)快速部署干净操作系统镜像。

服务状态异常排查指南

当控制节点显示某台物理机状态为DOWN时,需按以下顺序诊断问题根源:

| 排查阶段 | 具体操作 | 预期结果 |

|—————-|————————————————————————–|——————————|

| 消息队列检查 | 查看RabbitMQ服务是否活跃(systemctl status rabbitmq-server.service) | 服务应处于active运行态 |

| Nova组件复核 | 登录故障节点执行systemctl status openstack-nova-compute.service | 确认计算服务正常运行 |

| 强制重启尝试 | 对异常服务依次执行systemctl restart <service_name> | 日志显示无错误报错 |

| 管理口硬重启 | 上述步骤无效时,通过带外管理端口直接重启设备 | 物理机指示灯恢复正常响应 |

预防性维护建议

- 定期健康巡检:建立硬盘SMART监控体系,提前发现潜在坏道;配置自动巡检脚本每日上报硬件状态;

- 冗余设计优化:采用RAID10等冗余存储模式提升容错能力;跨可用区分布重要业务虚拟机;

- 备份标准化:制定完整的物理机配置备份方案,包括BIOS设置、RAID配置参数及网络拓扑图;

- 灾难演练实施:每季度开展故障模拟演习,验证应急预案有效性。

FAQs

-

问:如何判断是否需要更换整个服务器而非仅替换硬盘?

答:如果经检测发现主板、电源模块或其他核心部件存在不可逆损伤(如电容鼓包、PCB板烧蚀痕迹),或多次硬盘更换后仍频繁出现相同位置故障,则建议整体替换服务器,老旧设备的兼容性问题也可能迫使整机更新。 -

问:物理机进入维护模式期间会影响其他正常运行的节点吗?

答:不会,OpenStack的维护模式仅针对特定物理机生效,该节点会从调度池中暂时移除,但集群内其他健康节点仍可继续承载新增请求,当维护完成后重新启用时,原有负载才会逐步回流