单台物理机能否同时运行成百上千个Docker容器

- 物理机

- 2025-05-29

- 3236

一台物理机可以创建多个Docker容器吗?

答案是肯定的,一台物理机(或虚拟机)可以同时运行成百上千个Docker容器,这是Docker技术的核心优势之一,Docker通过操作系统级别的虚拟化技术实现了高效的资源隔离与管理,使得多个容器可以在同一台宿主机上独立运行,互不干扰,以下将从技术原理、实际应用、资源管理及安全性等方面详细解析这一问题。

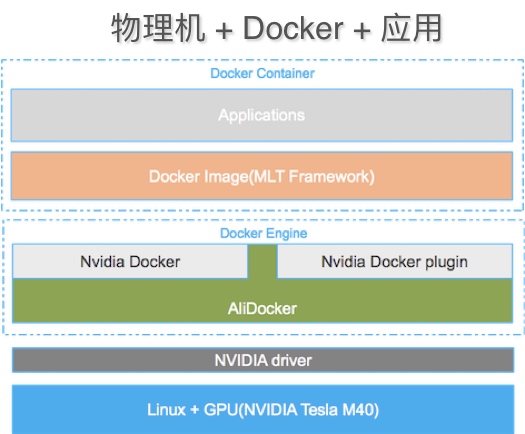

Docker的底层技术支撑

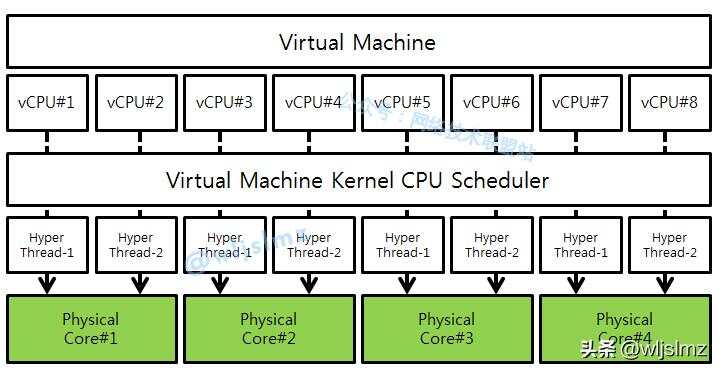

Docker容器与传统的虚拟机(VM)不同,不需要为每个容器分配完整的操作系统,传统虚拟机通过Hypervisor虚拟化硬件资源,每个虚拟机需运行独立的操作系统内核,而Docker容器共享宿主机的Linux内核,仅通过以下技术实现资源隔离:

- Namespaces(命名空间)

提供进程、网络、文件系统等资源隔离,每个容器拥有独立的视图,- PID Namespace:容器内的进程ID独立于宿主机。

- Network Namespace:容器拥有独立的IP地址和网络接口。

- Control Groups(cgroups)

控制资源分配(如CPU、内存、磁盘I/O),避免单个容器耗尽系统资源。 - Union File System(联合文件系统)

以分层方式管理容器镜像,实现高效的存储共享。

Docker容器的启动速度极快(秒级),资源占用极低(通常仅需MB级内存),这是支持多容器并行运行的基础。

为什么可以运行多个容器?

-

资源隔离与共享的平衡

Docker容器共享宿主机内核,但通过Namespace和cgroups实现资源隔离,这使得多个容器既能独立运行(如不同应用、不同配置),又能高效共享宿主机的CPU、内存等资源。 -

轻量级特性

每个容器仅包含应用及其依赖(如库文件、环境变量),无需完整的操作系统,单个容器占用资源极小。

- 一个Nginx容器可能仅需5MB内存。

- 一个Redis容器可能仅需30MB内存。

-

动态资源分配

用户可通过启动参数限制容器的资源使用(如--memory=512m),宿主机可根据负载动态分配资源,避免资源浪费。

实际应用场景

-

微服务架构

企业通常将单体应用拆分为多个微服务(如用户服务、订单服务、支付服务),每个服务运行在独立的容器中,通过Docker实现快速部署和扩展。 -

开发与测试环境

开发者可为每个项目创建多个容器,分别运行数据库、后端API、前端界面等,实现环境隔离,避免依赖冲突。 -

持续集成/持续交付(CI/CD)

在构建流水线中,每个构建任务可运行于独立容器中,确保任务间互不影响,提升效率。

资源管理与性能优化

虽然一台物理机可运行大量容器,但需合理分配资源以避免性能问题:

-

资源限制

- 通过

docker run命令设置CPU和内存限制:docker run -d --name myapp --cpus=1 --memory=2g myapp-image

- 使用Docker Compose或Kubernetes进行自动化资源调度。

- 通过

-

监控与告警

- 使用工具如

docker stats、Prometheus或Grafana监控容器资源消耗。 - 设置阈值告警,防止资源耗尽导致宿主机崩溃。

- 使用工具如

-

存储与网络优化

- 使用Volume管理持久化数据,避免容器日志占满磁盘。

- 优化容器网络模式(如Bridge、Host或Overlay网络)。

安全性考量

-

内核共享风险

所有容器共享宿主机内核,若某个容器存在破绽,可能影响宿主机或其他容器,因此需:- 定期更新宿主机内核及Docker版本。

- 限制容器权限(如使用

--cap-drop移除不必要的Linux能力)。

-

容器间通信安全

- 使用Docker网络隔离,限制容器间的通信(如通过自定义网络和防火墙规则)。

- 对敏感服务启用TLS加密。

-

镜像安全

- 仅从可信源(如Docker Hub官方镜像)拉取镜像。

- 扫描镜像破绽(使用工具如Trivy、Clair)。

一台物理机可以轻松运行数十甚至数百个Docker容器,这得益于Docker轻量级的资源隔离机制与高效的内核共享设计,无论是开发测试、生产部署,还是构建复杂的微服务架构,Docker都能通过多容器并行运行显著提升资源利用率与运维效率,需注意合理分配资源、加强安全防护,并结合监控工具确保系统稳定。

引用说明

本文技术细节参考自Docker官方文档、Linux内核Namespaces与cgroups说明,以及云计算领域最佳实践案例。

作者:某云计算架构师,10年DevOps与容器化部署经验,专注于企业级容器化解决方案。