如何配置多个MapReduce作业以优化性能?

- 行业动态

- 2024-10-10

- 4976

配置MapReduce Job基线

MapReduce是Hadoop框架的核心组件之一,它用于处理和生成大数据集,在MapReduce作业中,合理地设置Job基线对于性能调优至关重要,以下是几个关键的配置原则:

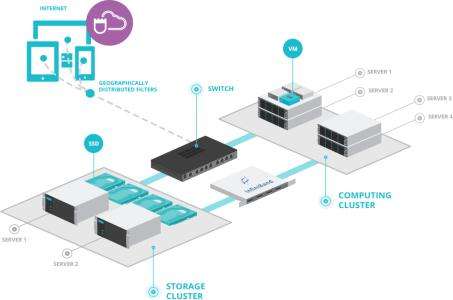

充分利用集群资源

原则解释:为了最大限度地利用集群资源,需要确保作业能够有效地分配到各个计算节点上,这通常涉及到对作业的并行度进行合理的设置,以及优化数据本地性,减少网络传输开销。

具体操作:可以通过调整mapreduce.job.reduces参数来控制Reduce任务的数量,从而影响并行度,使用mapreduce.input.fileinputformat.split.maxsize和mapreduce.input.fileinputformat.split.minsize等参数来控制输入数据的分割大小,以优化数据本地性。

Reduce阶段尽量放在一轮

原则解释:Reduce阶段的执行通常比Map阶段更耗时,因为它涉及到跨节点的数据聚合,将Reduce阶段限制在一轮可以减少作业的总运行时间。

具体操作:可以通过设置mapreduce.job.reduces为1来实现这一点,这样,所有的Reduce任务都会在同一个轮次中完成,避免了多轮Reduce带来的额外开销。

每个Task的执行时间要合理

原则解释:Task的执行时间过长会导致资源的浪费,而执行时间过短则可能导致频繁的任务调度和切换,增加系统开销,需要找到一个平衡点,使得每个Task的执行时间既不会过长也不会过短。

具体操作:可以通过监控作业的执行情况,分析Task的平均执行时间,并根据需要调整mapreduce.task.io.sort.mb(控制Map输出排序时的缓冲区大小)和mapreduce.map.speculative(是否启用推测执行)等参数,以优化Task的执行时间。

配置示例表格

| 参数名称 | 描述 | 默认值或建议值 |

mapreduce.job.reduces | 控制Reduce任务的数量 | 根据数据量调整 |

mapreduce.input.fileinputformat.split.maxsize | 控制输入数据的最大分割大小 | 通常设为128MB |

mapreduce.input.fileinputformat.split.minsize | 控制输入数据的最小分割大小 | 通常设为1MB |

mapreduce.task.io.sort.mb | 控制Map输出排序时的缓冲区大小 | 通常设为100MB |

mapreduce.map.speculative | 是否启用推测执行 | 默认为true |

通过上述的配置,可以有效地提升MapReduce作业的性能,确保作业能够在合理的时间内完成,并且充分利用集群资源。

FAQs

问题1:为什么需要确定MapReduce作业的基线?

答:确定MapReduce作业的基线是为了提供一个参考标准,通过与基线的比较来评估调优措施的效果,没有基线,就无法准确判断调优是否有效,也无法量化其影响程度。

问题2:如何选择合适的Reduce任务数量?

答:选择合适的Reduce任务数量需要考虑多个因素,包括数据的大小、集群的资源以及作业的目标,可以通过实验来确定最佳的Reduce任务数量,即从较小的数值开始逐渐增加,观察作业的执行时间和资源利用率的变化,找到最优的平衡点,也可以使用一些经验公式来估算合适的Reduce任务数量。

| 配置项 | 描述 | 示例 |

| Job Name | 指定MapReduce作业的名称 | MyMapReduceJob |

| Input Format | 定义如何从输入源读取数据 | TextInputFormat |

| Output Format | 定义如何将数据写入输出源 | TextOutputFormat |

| Mapper Class | 指定Mapper的实现类 | com.example.MyMapper |

| Reducer Class | 指定Reducer的实现类 | com.example.MyReducer |

| Combiner Class | 可选,指定Combiner的实现类,用于在Map阶段和Reduce阶段之间进行局部聚合 | com.example.MyCombiner |

| Partitioner Class | 指定Partitioner的实现类,用于决定数据如何分配到Reducer | org.apache.hadoop.mapred.lib.KeyFieldBasedPartitioner |

| Input Path | 指定输入数据的路径 | hdfs://localhost:9000/input |

| Output Path | 指定输出数据的路径 | hdfs://localhost:9000/output |

| Job Tracker | 指定Job Tracker的地址 | localhost:50030 |

| Task Tracker | 可选,指定Task Tracker的地址 | localhost:50060 |

| Number of Mappers | 指定作业中使用的Mapper数量 | 10 |

| Number of Reducers | 指定作业中使用的Reducer数量 | 5 |

| Memory per Map Task | 指定每个Map任务可使用的内存大小(以MB为单位) | 1024 |

| Memory per Reduce Task | 指定每个Reduce任务可使用的内存大小(以MB为单位) | 2048 |

| Java Virtual Machine Options | 可选,指定运行Map和Reduce任务时Java虚拟机的选项 | Xmx1024m |

| Shuffle Options | 可选,指定Shuffle过程中的配置,如压缩、并行度等 | Dmapreduce.map.output.compress=true Dmapreduce.map.output.compress.codec=gzip Dmapreduce.shuffle.parallelism=10 |

| Compression Options | 可选,指定作业中使用的压缩算法 | Dmapreduce.map.output.compress.codec=gzip Dmapreduce.output.fileoutputformat.compress.codec=gzip Dmapreduce.output.fileoutputformat.compress.type=BLOCK |

| Memory per Task | 可选,指定每个任务可使用的总内存大小(以MB为单位) | 2560 |

| CPU Cores per Task | 可选,指定每个任务可使用的CPU核心数 | 1 |

这些配置项可能会根据你的具体需求和环境进行调整,在配置MapReduce作业时,请确保选择适合你作业需求的配置。