如何高效更新MySQL数据库并让Spark作业访问数据?

- 行业动态

- 2024-10-11

- 4429

Spark作业访问MySQL数据库的方案包括使用JDBC连接、DataFrames API和第三方库如SparkJDBC。

MySQL数据库更新方案:Spark作业访问MySQL数据库的方案

1. 环境准备

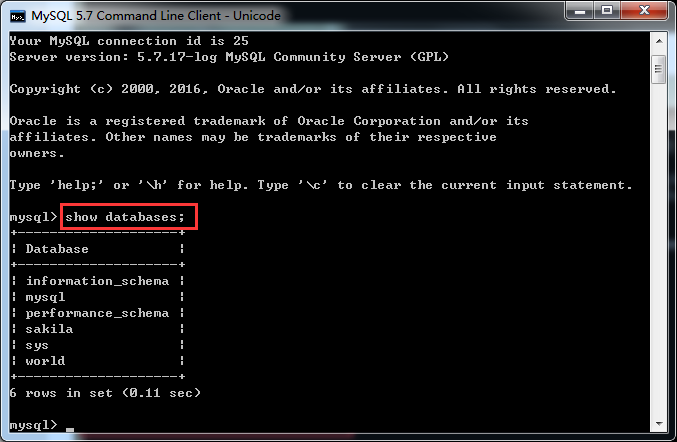

1.1 安装MySQL数据库

确保已经安装并配置好MySQL数据库,并且能够正常启动和运行。

1.2 安装Spark

确保已经安装并配置好Apache Spark,并且能够正常启动和运行。

1.3 安装JDBC驱动

下载MySQL的JDBC驱动程序(mysqlconnectorjava),并将其放置在Spark的lib目录下。

2. 配置Spark连接MySQL

2.1 加载JDBC驱动

在Spark应用程序中,使用SparkSession来加载MySQL的JDBC驱动。

import org.apache.spark.sql.{SparkSession, DataFrame}

val spark = SparkSession.builder()

.appName("MySQL Update Example")

.getOrCreate()2.2 读取MySQL数据

使用Spark SQL的jdbc方法从MySQL数据库中读取数据到DataFrame中。

import org.apache.spark.sql.{DataFrame, SparkSession}

val jdbcDF: DataFrame = spark.read

.format("jdbc")

.option("url", "jdbc:mysql://localhost:3306/database_name")

.option("dbtable", "table_name")

.option("user", "username")

.option("password", "password")

.load()2.3 更新MySQL数据

使用DataFrame的write方法将数据写回MySQL数据库。

jdbcDF.write

.mode("overwrite") // 选择写入模式:append、overwrite、ignore、error

.jdbc("jdbc:mysql://localhost:3306/database_name", "table_name", new java.util.Properties())3. 示例代码

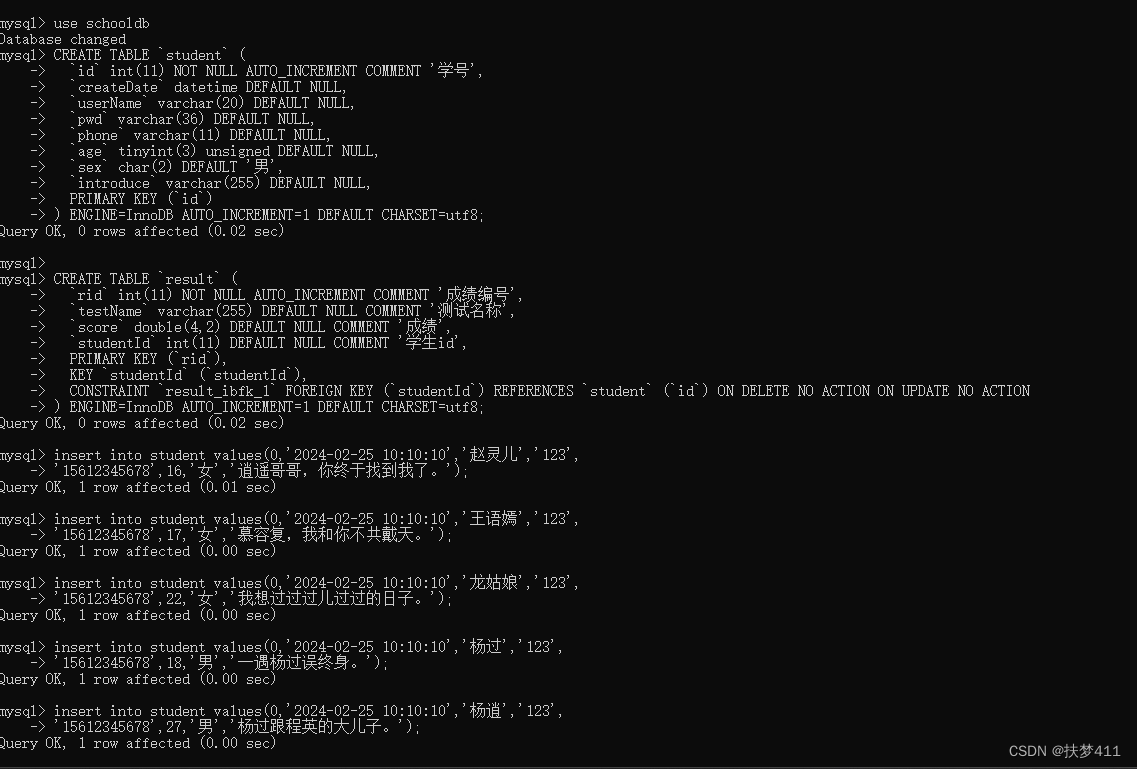

下面是一个示例代码,演示如何通过Spark作业更新MySQL数据库的数据。

import org.apache.spark.sql.{DataFrame, SparkSession}

object MySQLUpdateExample {

def main(args: Array[String]): Unit = {

// 创建SparkSession

val spark = SparkSession.builder()

.appName("MySQL Update Example")

.getOrCreate()

// 读取MySQL数据

val jdbcDF: DataFrame = spark.read

.format("jdbc")

.option("url", "jdbc:mysql://localhost:3306/database_name")

.option("dbtable", "table_name")

.option("user", "username")

.option("password", "password")

.load()

// 对数据进行转换或计算(根据需求自定义)

val updatedDF: DataFrame = jdbcDF.transform(_ => /* 自定义转换逻辑 */)

// 更新MySQL数据

updatedDF.write

.mode("overwrite") // 选择写入模式:append、overwrite、ignore、error

.jdbc("jdbc:mysql://localhost:3306/database_name", "table_name", new java.util.Properties())

// 关闭SparkSession

spark.stop()

}

}请根据实际需求修改代码中的数据库连接信息、表名、用户名和密码等参数,根据业务需求自定义数据的转换逻辑。

| 方案 | 描述 | Spark作业访问MySQL数据库 |

| 连接方式 | 通过JDBC连接MySQL数据库 | 在Spark作业中使用JDBC连接器连接MySQL数据库 |

| 驱动类名 | com.mysql.cj.jdbc.Driver | 在Spark作业中指定MySQL JDBC驱动类的全路径 |

| 连接URL | jdbc:mysql://

| 替换为MySQL服务器的IP地址、端口号和数据库名称 |

| 用户名 |

| 替换为MySQL数据库的用户名 |

| 密码 |

| 替换为MySQL数据库的密码 |

| 读取数据 | 使用Spark SQL读取MySQL数据库中的表数据 | 使用Spark SQL读取JDBC连接中指定的MySQL数据库表 |

| 写入数据 | 使用Spark SQL将数据写入MySQL数据库 | 使用Spark SQL将数据写入JDBC连接中指定的MySQL数据库表 |

| 数据转换 | 在Spark作业中对数据进行处理和转换 | 在Spark作业中对读取的数据进行处理和转换,然后将结果写入MySQL数据库 |

| 错误处理 | 使用trycatch语句捕获和处理异常 | 在Spark作业中使用trycatch语句捕获和处理JDBC连接和操作过程中可能出现的异常 |

| 性能优化 | 使用批处理、索引等技术提高数据读取和写入性能 | 在Spark作业中采用批处理、索引等技术优化数据读取和写入性能 |

示例代码:

from pyspark.sql import SparkSession

创建SparkSession

spark = SparkSession.builder

.appName("MySQL Example")

.getOrCreate()

创建JDBC连接

jdbc_url = "jdbc:mysql://<host>:<port>/<database>?useSSL=false"

driver = "com.mysql.cj.jdbc.Driver"

user = "<username>"

password = "<password>"

读取MySQL数据

df = spark.read.format("jdbc")

.option("url", jdbc_url)

.option("driver", driver)

.option("user", user)

.option("password", password)

.option("dbtable", "<table_name>")

.load()

处理数据

...

写入MySQL数据

df.write.format("jdbc")

.option("url", jdbc_url)

.option("driver", driver)

.option("user", user)

.option("password", password)

.option("dbtable", "<table_name>")

.mode("overwrite")

.save()注意:

1、请将示例代码中的<host>,<port>,<database>,<username>,<password>,<table_name>替换为实际值。

2、根据实际需求,您可能需要在Spark作业中添加更多操作,如数据清洗、转换等。