上一篇

hive将结果保存至mysql

- 行业动态

- 2025-05-13

- 3

Hive结果可导出为CSV文件,通过MySQL LOAD DATA或Sqoop工具实现数据迁移至MySQL

Hive与MySQL集成

Hive是基于Hadoop的数据仓库工具,擅长处理大规模离线数据分析,而MySQL是关系型数据库管理系统,常用于在线业务存储,在实际场景中,可能需要将Hive的查询结果同步到MySQL,

- 将分析结果写入MySQL供业务系统调用

- 实现Hive与MySQL的异构数据源同步

- 构建混合存储架构(Hive存原始数据,MySQL存精简结果)

实现Hive到MySQL的数据同步主要有两种技术路径:

- 直接导出:通过Hive SQL将结果写入MySQL表

- ETL工具:使用Sqoop、DataX等工具进行数据传输

前置准备

环境依赖

| 组件 | 版本要求 | 说明 |

|---|---|---|

| Hive | x+/3.x+ | 支持JDBC扩展 |

| MySQL | 7+/8.0+ | 建议使用InnoDB引擎 |

| JDBC驱动 | mysql-connector-java-8.x | 需放入Hive的lib目录 |

| Hadoop生态 | Hadoop 2.x+/3.x+ | 兼容Hive的HDFS文件系统 |

核心配置文件

需在hive-site.xml中添加MySQL JDBC连接配置:

<property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://mysql-server:3306/database?useSSL=false</value> </property> <property> <name>javax.jdo.option.ConnectionDriverName</name> <value>com.mysql.cj.jdbc.Driver</value> </property> <property> <name>javax.jdo.option.ConnectionUserName</name> <value>root</value> </property> <property> <name>javax.jdo.option.ConnectionPassword</name> <value>password</value> </property>

直接导出方法(Hive SQL)

创建MySQL目标表

CREATE TABLE user_stats ( user_id INT PRIMARY KEY, click_count INT, purchase_amount DECIMAL(10,2), last_login TIMESTAMP ) ENGINE=InnoDB;

Hive SQL导出语法

INSERT OVERWRITE DIRECTORY '/tmp/mysql_load' ROW FORMAT DELIMITED FIELDS TERMINATED BY ',' SELECT FROM hive_table;

加载数据到MySQL

mysql -u root -p --local-infile=1 -e " LOAD DATA LOCAL INFILE '/tmp/mysql_load/00000' INTO TABLE user_stats FIELDS TERMINATED BY ',' LINES TERMINATED BY ' ' IGNORE 1 LINES; "

Sqoop导出方法

基本导出命令

sqoop export --connect jdbc:mysql://mysql-server:3306/database --username root --password password --table user_stats --export-dir /user/hive/warehouse/result_table --input-fields-terminated-by ',' --update-key user_id --update-mode allowinsert

增量导出配置

需在Hive表中添加时间戳字段:

ALTER TABLE hive_table ADD COLUMNS (etl_time TIMESTAMP);

导出时增加条件:

sqoop export --where "etl_time > '2023-01-01'" ...

数据类型映射规则

| Hive类型 | MySQL类型 | 说明 |

|---|---|---|

| STRING | VARCHAR(255) | 默认长度255 |

| DOUBLE | DECIMAL(18,4) | 保留4位小数 |

| BIGINT | BIGINT | 需保证主键自增关闭 |

| TIMESTAMP | DATETIME/TIMESTAMP | 建议使用TIMESTAMP(3) |

| BOOLEAN | TINYINT(1) | true=1, false=0 |

| STRUCT | JSON | 需序列化为JSON字符串 |

性能优化策略

| 优化方向 | 具体措施 | 效果提升点 |

|---|---|---|

| 并行导出 | sqoop export --num-mappers 4 | 多线程并行写入 |

| 批量提交 | set mapreduce.job.committer=org.apache.sqoop.mapreduce.DatabaseRecordWriter | 减少事务提交次数 |

| 压缩传输 | --compress + parquet格式 | 降低网络IO消耗 |

| 索引优化 | MySQL目标表添加索引 | 提升后续查询效率 |

| 分区裁剪 | Hive查询使用分区字段过滤 | 减少导出数据量 |

常见问题与解决方案

数据类型不匹配导致导入失败

现象:java.sql.SQLException: Data truncation

原因:Hive的DOUBLE类型精度超过MySQL DECIMAL范围

解决:

- 修改MySQL字段为

DECIMAL(20,6) - 或在Hive中使用

CAST(field AS DECIMAL(20,6))转换类型

Sqoop导出时连接超时

现象:Error: Network error

原因:MySQL默认等待时长过短(8小时)

解决:

- 调整MySQL参数

wait_timeout=28800(8小时→8小时) - Sqoop命令增加

--direct模式绕过MapReduce阶段

FAQs

Q1:Hive导出到MySQL时如何选择导出模式?

A1:若数据量<10万条且实时性要求高,建议使用INSERT INTO直接写入;若数据量>百万或需要分布式处理,优先使用Sqoop的--num-mappers参数进行并行导出,对于增量数据,需结合时间戳字段或主键更新。

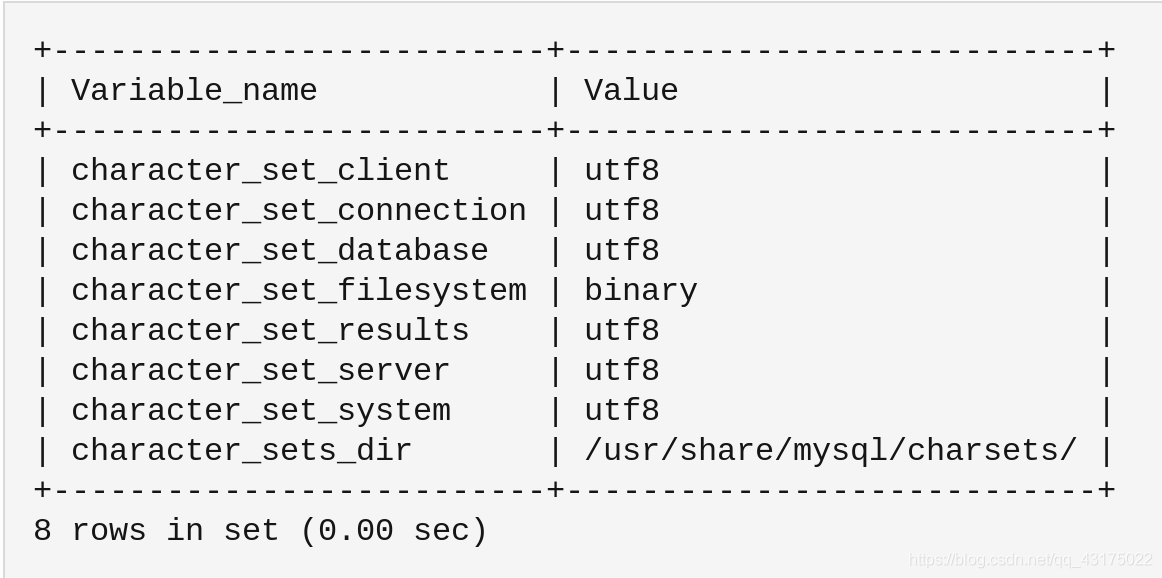

Q2:如何处理Hive与MySQL的字符集编码冲突?

A2:在MySQL建表时显式指定字符集:DEFAULT CHARSET utf8mb4,并在Hive中设置SET mapreduce.map.output.encoding=UTF-8,若出现乱码,可在Sqoop命令中添加`–input-lines-terminated-by ‘u0001’