上一篇

hivemysql关系

- 行业动态

- 2025-05-12

- 8

Hive与MySQL均为数据处理工具,Hive基于Hadoop处理海量数据,适合OLAP;MySQL为关系型数据库,支持事务,适用于OLTP,二者可协同存储元

Hive与MySQL关系解析及对比分析

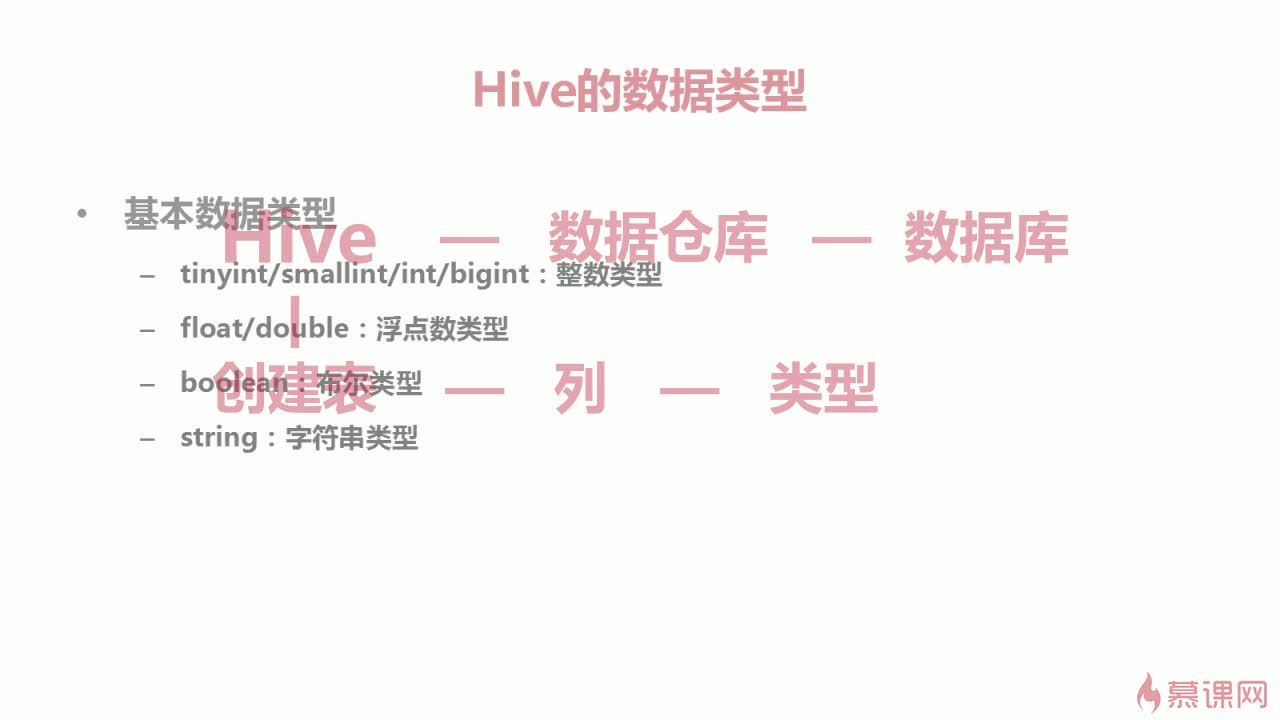

基础概念对比

| 特性 | Hive | MySQL |

|---|---|---|

| 定位 | 数据仓库工具 | 关系型数据库管理系统 |

| 核心功能 | 海量数据批处理查询 | 在线事务处理(OLTP) |

| 数据模型 | 类SQL扩展(HiveQL) | 标准SQL |

| 底层存储 | HDFS(Hadoop分布式文件系统) | InnoDB/MyISAM存储引擎 |

| 适用场景 | 离线数据分析、ETL处理 | 高并发读写、事务型应用 |

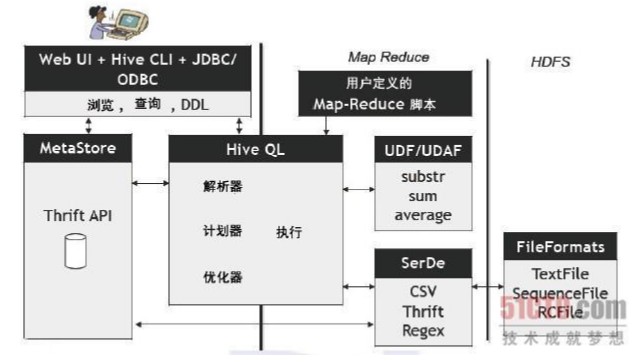

技术架构差异

存储层对比

- Hive:数据以文本/二进制形式存储在HDFS中,采用列式存储(ORC/Parquet格式),支持数据压缩和分区

- MySQL:基于表空间管理,支持行级锁定,通过B+树索引实现快速检索,默认存储引擎InnoDB支持ACID事务

计算模式

- Hive:依赖MapReduce/Tez/Spark执行查询,适合PB级数据处理,延迟较高(分钟级)

- MySQL:直接操作磁盘文件,通过缓冲池优化IO,支持毫秒级实时响应

数据更新机制

- Hive:写时模式(Write-Once-Read-Many),不支持行级更新,通过INSERT OVERWRITE实现数据覆盖

- MySQL:支持完整的DML操作(INSERT/UPDATE/DELETE),通过redo/undo日志保证事务一致性

查询语言特性对比

| 特性 | HiveQL | MySQL SQL |

|---|---|---|

| 事务支持 | 无ACID事务 | 完整事务支持 |

| 索引类型 | 无原生索引(依赖分区) | B+树索引、全文索引 |

| 函数库 | 扩展性有限(UDF支持) | 丰富的内置函数 |

| 连接优化 | 依赖用户指定JOIN策略 | 自动优化查询计划 |

| 窗口函数 | 支持基本窗口函数 | 完整支持SQL标准窗口函数 |

典型应用场景对比

Hive优势场景:

- 日志分析(每天TB级日志处理)

- 用户行为分析(电商/社交平台)

- 数据仓库建设(历史数据存档)

- 机器学习特征工程(批量数据处理)

MySQL优势场景:

- 订单管理系统

- 用户认证系统

- 实时库存管理

- API服务后端存储

性能特征对比

| 指标 | Hive | MySQL |

|---|---|---|

| 单节点吞吐量 | 低(依赖分布式计算) | 高(优化后的InnoDB) |

| 并发处理能力 | 横向扩展(集群规模) | 纵向扩展(CPU/内存) |

| 延迟敏感度 | 不适用实时场景 | 亚毫秒级响应 |

| 复杂查询优化 | 依赖用户调优 | 自动优化器 |

| 存储成本 | 较低(HDFS冗余存储) | 较高(EC2/SSD等) |

集成方案与数据流转

数据导入导出

- Sqoop:实现MySQL与Hive的批量数据传输,支持增量导入

- Flume:实时采集MySQL变更数据到Hive

- 自定义脚本:通过JDBC连接实现异构数据迁移

混合架构实践

| 层级 | 技术选型 | 功能说明 |

|—————|—————————–|————————–|

| 数据采集层| Flume + Kafka | 实时日志收集 |

| 实时处理层| Flink + MySQL | 订单状态实时更新 |

| 批处理层 | Hive + Spark | 用户行为分析 |

| 服务层 | MySQL集群 | 业务系统数据存储 |

关键差异归纳

数据新鲜度

- Hive:适合处理T+1级别的离线数据

- MySQL:可支撑实时数据写入与查询

扩展方式

- Hive:通过增加DN节点实现线性扩展

- MySQL:受单机性能瓶颈限制,需分库分表

开发成本

- Hive:需要掌握Hadoop生态栈知识

- MySQL:标准化SQL开发,学习曲线平缓

选型建议矩阵

| 需求维度 | 优先选择MySQL | 优先选择Hive |

|---|---|---|

| 事务完整性要求 | ||

| 实时数据服务 | ||

| PB级数据分析 | ||

| 复杂JOIN操作 | (小规模)√ | (大规模)√ |

| 硬件成本控制 | (中小规模)√ | (超大规模)√ |

FAQs

Q1:如何实现MySQL到Hive的实时数据同步?

A:推荐使用以下组合方案:

- 利用MySQL的binlog日志捕获变更数据

- 通过Kafka作为消息队列缓冲实时数据

- 使用Flink消费Kafka消息并写入Hive

- 配置Hive的ACID属性支持实时插入

Q2:Hive查询性能优化有哪些关键措施?

A:主要优化策略包括:

- 合理设计分区(按时间/地域等维度)

- 使用ORC/Parquet列式存储格式

- 开启CBO(成本基准优化)

- 调整mapreduce.job.reduces参数

- 创建合适的物