hdfs中存储图片

- 行业动态

- 2025-05-16

- 6

在Hadoop分布式文件系统(HDFS)中存储图片是一种常见的大数据应用场景,尤其适用于需要处理海量图像数据的场景,例如图像识别、计算机视觉、多媒体数据分析等,HDFS的高吞吐量、可扩展性和容错性使其成为存储大规模图片数据的理想选择,以下是关于HDFS中存储图片的详细技术解析和实践建议。

HDFS存储图片的基本原理

HDFS采用块存储(Block Storage)机制,将文件分割为固定大小的块(默认128MB,可配置),并将这些块冗余存储到多个节点上,图片作为二进制文件,通常以原始字节流形式存储,无需复杂的序列化处理,其核心流程如下:

| 步骤 | 说明 |

|---|---|

| 客户端上传 | 图片通过HDFS客户端(如Java API、WebHDFS或命令行)上传至NameNode。 |

| 分块与复制 | NameNode将图片分割为多个Block,默认3个副本(可配置),分发到DataNode。 |

| 元数据管理 | NameNode记录文件路径、Block位置、权限等元数据,DataNode存储实际数据块。 |

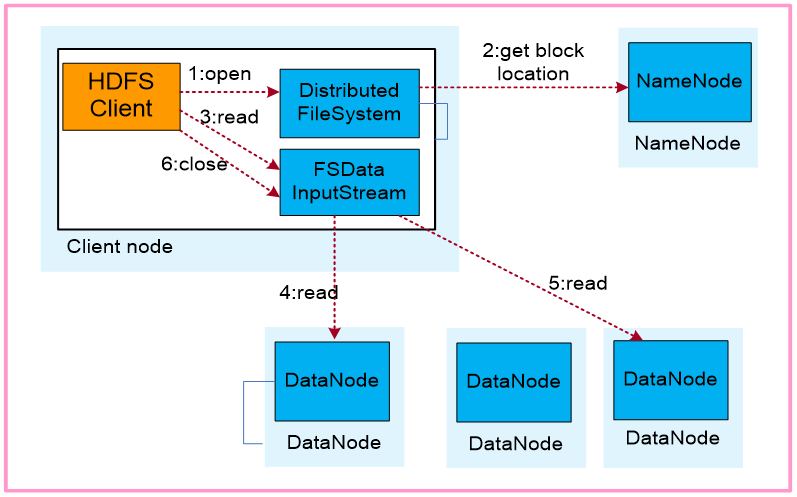

| 读取流程 | 客户端从NameNode获取Block位置,直接从DataNode读取数据,支持并行访问。 |

HDFS存储图片的优势

高吞吐量与低延迟

HDFS专为批量数据处理设计,适合大文件(如高清图片)的顺序读写,单节点带宽可达到GB/s级别。横向扩展能力

通过增加DataNode节点,可线性扩展存储容量和并发能力,轻松应对PB级图片数据。容错性保障

每个Block有多个副本(默认3个),即使部分节点故障,图片仍可通过其他副本恢复。

与大数据生态兼容

可直接与Spark、Flink、TensorFlow On Spark等框架集成,实现图像处理、模型训练等任务。

图片存储的具体实现步骤

上传图片到HDFS

# 使用HDFS命令行工具上传单张图片 hdfs dfs -put /local/path/image.jpg /hdfs/path/ # 上传整个图片目录(递归) hdfs dfs -put -f /local/images/ /hdfs/images/

目录结构设计

建议按业务逻辑分层存储,

/hdfs/images/

├── by_date/

│ ├── 2023-10-01/

│ │ ├── image_001.jpg

│ │ └── ...

├── by_category/

│ ├── nature/

│ ├── portrait/

└── raw/

└── ...权限与配额管理

通过HDFS ACL(访问控制列表)限制用户权限:

# 设置目录所有者和权限 hdfs dfs -chown user:group /hdfs/images/ hdfs dfs -chmod 750 /hdfs/images/ # 限制目录存储配额(示例:10TB) hdfs dfs -setQuota 10737418240 /hdfs/images/

关键注意事项

小文件问题

单张图片通常较小(如1MB),若直接存储会导致以下问题:

- 元数据压力:每个文件对应一条元数据记录,百万级图片可能耗尽NameNode内存。

- IO效率低:大量小文件并发访问会降低吞吐量。

解决方案:

- 合并小文件:使用

Hadoop Archive(HAR)或SequenceFile将多张图片打包为大文件。 - 分层存储:热数据(高频访问)保留原格式,冷数据(低频访问)合并存储。

数据一致性

HDFS的最终一致性模型可能导致以下问题:

- 文件上传后立即读取可能获取不到最新数据(需等待副本同步完成)。

- 解决方案:启用

hdfs.write.packet.delay参数优化写入性能,或通过FileSystem.close()确保写入完成。

图片格式选择

| 格式 | 特点 | 建议场景 |

|---|---|---|

| JPEG | 有损压缩,体积小 | 网页图片、普通图像存储 |

| PNG | 无损压缩,支持透明 | 需要编辑的图片 |

| WebP | 谷歌开源格式,压缩率更高 | 对存储空间敏感的场景 |

| TIFF | 专业级格式,支持多层压缩 | 医疗影像、科学图谱 |

性能优化策略

调整HDFS参数

| 参数 | 作用 | 推荐值 |

|---|---|---|

dfs.blocksize | 单个Block大小 | 64MB(根据图片大小调整) |

dfs.replication | Block副本数 | 2(冷数据)或3(热数据) |

io.file.buffer.size | 客户端写入缓冲区大小 | 1MB(减少RPC次数) |

数据本地化优化

- 就近存储:通过

机架感知(Rack Awareness)将副本分配到不同机架,减少跨机架传输。 - 缓存预热:对高频访问的图片启用HDFS缓存(

cachePool机制)。

压缩与编码

- Block压缩:启用

org.apache.hadoop.io.compress.SnappyCodec减少网络传输量。 - 图片预处理:在上传前对图片进行统一缩放、格式转换,降低存储开销。

典型应用场景

图像分类与训练

将图片存储在HDFS后,通过Spark或MapReduce进行特征提取,输出结果直接写回HDFS。多媒体归档

结合HDFS的WORM(Write Once Read Many)特性,实现图片数据的不可改动归档。实时图像分析

使用Kafka+Flume将摄像头图片流式写入HDFS,再通过Flink进行实时处理。

FAQs(常见问题解答)

Q1:HDFS中存储小图片(如图标)会导致性能问题吗?如何解决?

A:是的,大量小文件会占用过多NameNode内存并降低IO效率,解决方案包括:

- 使用

Hadoop Archive(HAR)将小文件合并为大文件。 - 启用

hdfs.namenode.fs.limit.jnr.dir.max.files参数(需谨慎调整)。 - 将小文件存储到对象存储(如MinIO)或数据库(如MongoDB GridFS)。

Q2:如何提高HDFS中图片的读取速度?

A:可通过以下方法优化:

- 启用Short Circuit Local Reads:允许客户端直接从本地DataNode读取数据,绕过网络传输。

- 使用Erasure Coding:替代传统副本机制,降低存储开销并提升读取并行度(需Hadoop 3.x+)。

- 预加载热点数据:将高频访问的图片加入HDFS缓存池(

cachePool)。