hbase服务器内存

- 行业动态

- 2025-05-16

- 10

HBase服务器内存用于数据缓存和索引加速,核心组件包括MemStore(写缓存)和BlockCache(读缓存),需合理配置堆内存(如HBASE_HEAPSIZE)以平衡性能与资源消耗,优化内存使用可显著

HBase服务器内存管理与优化详解

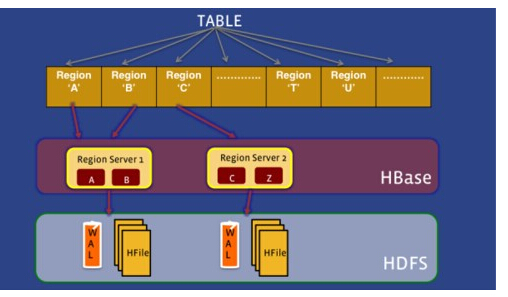

HBase作为分布式NoSQL数据库,其性能与稳定性高度依赖服务器内存的合理配置与管理,内存资源直接影响数据读写效率、RegionServer负载能力以及集群整体吞吐量,本文将从内存分配机制、核心组件内存消耗、参数调优策略及监控方法等方面展开分析。

HBase内存分配架构

| 组件 | 功能描述 | 内存类型 |

|---|---|---|

| Java Heap(堆内存) | JVM进程的内存空间,存放对象实例(如MemStore、BlockCache)、数据结构等 | 受-Xmx参数控制 |

| Off-Heap Memory | 堆外内存,用于存储HFile Block Cache、MapOutput等,避免GC影响 | 受-XX:MaxDirectMemorySize控制 |

| Native Memory | 本地代码(如RocksDB)使用的内存,包括操作系统分配的缓冲区 | 依赖系统配置 |

典型内存分布示例(以16GB物理内存为例):

| 组件 | 推荐占比 | 示例值 | 作用 |

|————————–|————|———–|——————————–|

| Java Heap | 40%-50% | 8GB | 对象存储与垃圾回收主区域 |

| Off-Heap Memory | 20%-30% | 4GB | HFile缓存、RPC序列化 |

| Native Memory (RocksDB) | 10%-20% | 2GB | Block缓存、MemTable |

| OS Kernel Cache | 10%-15% | 2GB | 文件系统缓存(建议预留) |

核心组件内存消耗分析

MemStore(写缓冲区)

- 功能:临时存储写入数据,按时间或大小阈值刷写到HFile。

- 内存参数:

hbase.regionserver.global.memstore.upper.limit(默认40%):全局MemStore上限,触发Flush。hbase.regionserver.global.memstore.lower.limit(默认35%):低于此值停止Flush。

- 调优建议:

- 大批量写入场景可增大上限(如50%),但需防止Heap OOM。

- 高频写入场景建议降低上限,配合

hbase.client.write.buffer优化客户端缓冲。

BlockCache(读缓存)

- 功能:缓存已读取的HFile块,加速重复访问。

- 内存参数:

hbase.regionserver.hfileblockcache.size(默认0.4,即40%堆内存)。

- 调优建议:

- 读密集型业务可提升至50%-60%,但需平衡写内存占用。

- 启用

EVICT_ON_CALL策略(LruCache)优先淘汰冷数据。

MTRR(读检索缓存)

- 功能:存储RowKey到HFile块的映射关系,加速读路径。

- 内存参数:

hbase.regionserver.metablock.cache.size(默认10MB)。

- 调优建议:

大宽表场景可增加至20MB,减少MetaBlock加载频率。

HFile Block Cache(堆外缓存)

- 功能:存储HFile的Data/Bloom/Index块,减少磁盘IO。

- 内存参数:

hbase.regionserver.hfileblockcache.size(默认0.2,即20%堆外内存)。

- 调优建议:

SSD存储介质下可适当降低,HDD介质建议保持高位。

内存监控与诊断工具

| 工具 | 功能描述 |

|---|---|

| JMX Beans | 通过Hadoop:service=HBase,name=RegionServer,sub=MemStore等接口获取实时内存使用数据 |

| HBase UI | http://<regionserver>:16010/master-status查看RegionServer内存分配概况 |

| Ganglia/Graphite | 采集JVM堆内存、GC次数、Off-Heap使用量等指标 |

| JStack/PMap | 分析线程栈与内存映射,诊断内存泄漏问题 |

关键监控指标:

- Heap Use:持续接近

-Xmx可能触发Full GC。 - Off-Heap Use:超过

MaxDirectMemorySize会导致抛异常。 - MemStore Size:接近

upper.limit时需关注Flush频率。 - BlockCache Hit Ratio:低于80%可能需扩容缓存。

内存调优实战策略

Heap Size设置原则

- 公式:

Heap Size = (物理内存 OS保留内存 RocksDB缓存) 0.5 - 示例:32GB物理内存,预留4GB给OS,RocksDB使用6GB → Heap Size = (32-4-6)0.5=11GB。

- 公式:

GC优化

- 启用G1垃圾回收器:

-XX:+UseG1GC。 - 调整G1参数:

-XX:G1HeapRegionSize=16M(减少Young Generation停顿)。 - 避免频繁Full GC:确保

-Xmx与-Xms相等,防止堆收缩。

- 启用G1垃圾回收器:

Off-Heap内存控制

- 限制DirectMemory:

-XX:MaxDirectMemorySize=4g。 - 警惕Netty/RPC堆外内存:调整

hbase.rpc.controllerfactory.class为ConcurrentRequestProcessor。

- 限制DirectMemory:

RocksDB内存优化

- 调整Block Cache:

hbase.regionserver.db.block.cache.size=0.3(30%堆外内存)。 - 启用Bloom Filter:

hbase.regionserver.db.bloom.enabled=true减少无效IO。

- 调整Block Cache:

常见问题与解决方案

Q1:RegionServer频繁因OutOfMemory崩溃怎么办?

- 诊断步骤:

- 检查JMX中Heap/Off-Heap使用率是否接近上限。

- 分析GC日志,确认是否为Old Generation溢出。

- 使用

jmap生成heap dump,排查内存泄漏对象(如大对象数组、未释放的Iterator)。

- 解决方案:

- 增大Heap Size或调整MemStore上限。

- 优化RowKey设计,避免热点Region集中。

- 升级HBase版本(如2.x→3.x)修复已知内存泄漏。

Q2:BlockCache命中率低如何改进?

- 原因分析:

- 缓存容量不足,热数据频繁被淘汰。

- 数据访问模式随机,无法有效缓存。

- 优化措施:

- 提升

hbase.regionserver.hfileblockcache.size至50%。 - 启用异步缓存刷新:

hbase.regionserver.hfileblockcache.evict.on.close=false。 - 对热点表启用二级缓存(需权衡内存开销)。

- 提升

HBase内存管理需平衡写缓冲、读缓存与堆外存储的资源配置,通过监控关键指标、合理设置JVM参数、优化组件缓存策略,可显著提升集群吞吐量与稳定性,实际调优时应结合业务特点(如读写比例、数据规模)进行迭代测试,避免盲目扩大