如何利用存储过程轻松应对百万级数据处理的性能瓶颈?

- 行业动态

- 2025-05-11

- 9

存储过程在百万级数据库中的核心价值与应用策略

在大数据时代,面对百万条甚至更大规模的数据库,如何高效处理数据是开发者与运维团队的核心挑战,存储过程(Stored Procedure)作为数据库管理中的重要工具,凭借其预编译、可复用、高性能的特性,成为优化大规模数据操作的关键技术之一,本文将深入探讨存储过程在百万级数据库中的实际应用场景、优化技巧及注意事项,为技术团队提供可落地的解决方案。

存储过程的定义与优势

存储过程是预先编写并存储在数据库中的一段SQL代码集合,可通过调用名称执行,相较于直接执行动态SQL语句,存储过程具备以下优势:

- 性能高效:存储过程在首次执行时完成编译并缓存,后续调用直接使用编译后的执行计划,减少解析和编译时间。

- 逻辑封装:将复杂业务逻辑(如事务控制、循环处理)封装在数据库中,减少代码冗余。

- 安全性强:通过权限控制,限制用户直接访问表,仅开放存储过程操作接口。

- 降低网络开销:批量操作在数据库内部完成,减少客户端与服务端的交互次数。

对于百万级数据,这些特性可显著提升数据处理效率,一个统计报表的生成若通过多次单条查询实现,可能耗时数分钟;而改用存储过程后,通过批量处理可将时间压缩至秒级。

百万级数据处理的核心优化策略

合理设计索引与查询逻辑

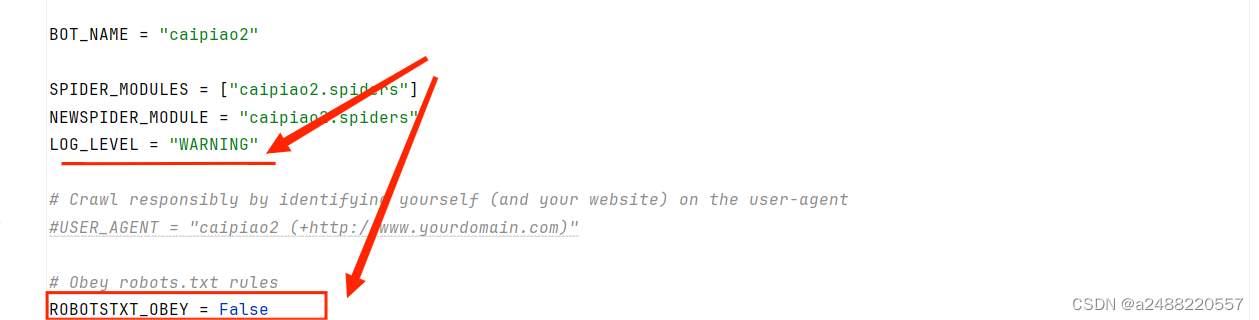

- 避免全表扫描:在存储过程中使用WHERE条件时,需确保字段已建立索引。

CREATE INDEX idx_user_id ON user_table(user_id);

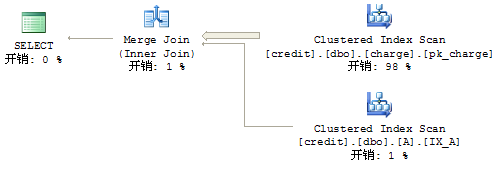

- 优化联合查询:通过

EXPLAIN分析执行计划,避免多表关联时的笛卡尔积问题。

分页查询优化

传统LIMIT offset, count在百万级数据中性能极差,可通过“游标分页”或“基于主键的范围查询”改进。

-- 使用主键范围分页(假设主键为自增ID) SELECT * FROM orders WHERE id > 100000 ORDER BY id LIMIT 1000;

批量操作取代单条处理

循环单条插入或更新会频繁触发事务日志写入,改用批量操作可减少I/O压力。

-- 批量插入示例(MySQL语法) INSERT INTO user_log (user_id, action) VALUES (1, 'login'), (2, 'logout'), ...;

避免隐式类型转换

数据类型不匹配会导致索引失效,VARCHAR字段与数字比较时需显式转换:

-- 错误写法(user_id为VARCHAR类型时) SELECT * FROM users WHERE user_id = 100; -- 正确写法 SELECT * FROM users WHERE user_id = '100';

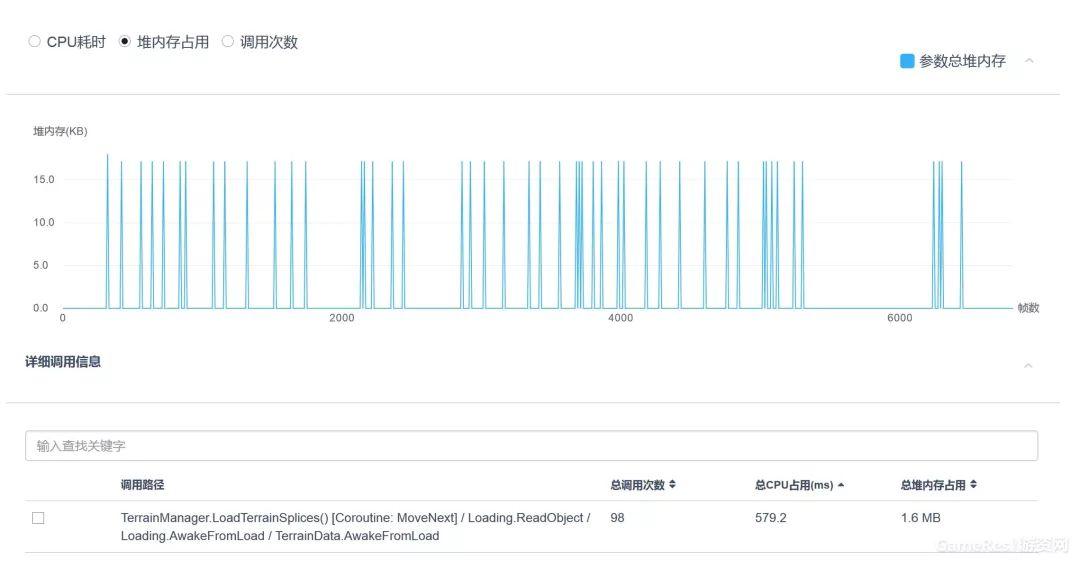

异步处理与任务拆分

对耗时操作(如数据清洗)拆分为多个存储过程,通过任务队列异步执行,避免阻塞主线程。

定期归档历史数据

将非活跃数据迁移至归档表,减少主表体积。

-- 将1年前的数据迁移至归档表 INSERT INTO orders_archive SELECT * FROM orders WHERE create_time < NOW() - INTERVAL 1 YEAR; DELETE FROM orders WHERE create_time < NOW() - INTERVAL 1 YEAR;

注意事项与风险规避

参数化查询防注入

动态拼接SQL时需使用参数化输入,避免SQL注入破绽。-- 错误写法 EXECUTE 'SELECT * FROM users WHERE name = ' + @input_name; -- 正确写法(使用参数) EXECUTE sp_executesql N'SELECT * FROM users WHERE name = @name', N'@name VARCHAR(50)', @name = @input_name;

错误处理机制

使用TRY...CATCH块捕获异常,记录日志并回滚事务:BEGIN TRY BEGIN TRANSACTION; -- 业务逻辑 COMMIT TRANSACTION; END TRY BEGIN CATCH ROLLBACK TRANSACTION; INSERT INTO error_log (message) VALUES (ERROR_MESSAGE()); END CATCH版本控制与测试

- 存储过程代码需纳入版本管理系统(如Git)。

- 上线前进行压力测试,模拟百万级数据场景验证性能。

避免过度依赖存储过程

复杂业务逻辑可部分迁移至应用层,平衡数据库与业务服务器的负载。

典型应用场景

- 数据迁移与清洗:将旧系统数据清洗后导入新表。

- 定时任务:每日统计报表生成、过期数据清理。

- 高并发写入:电商瞬秒活动的库存扣减。

- 复杂计算:金融领域的利息计算或风险分析。

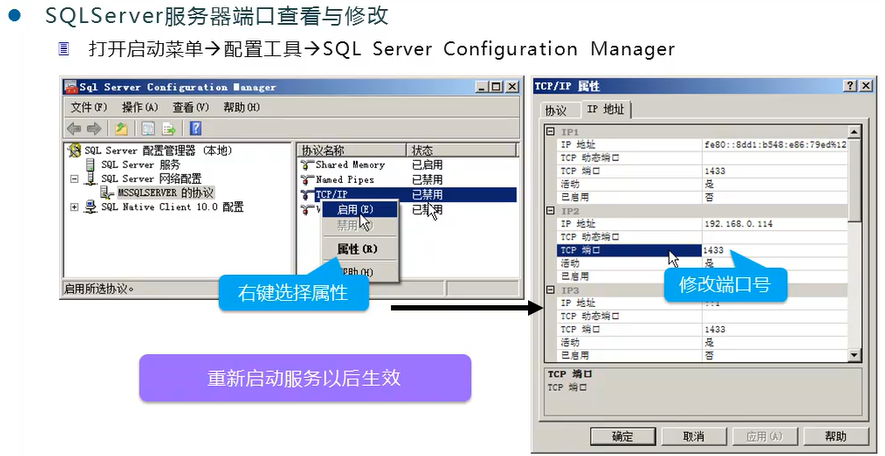

存储过程在百万级数据库中并非“银弹”,其价值取决于合理的设计与优化,技术团队需结合业务需求,权衡性能、安全性与维护成本,对于核心高频操作,存储过程可带来显著性能提升;但对于快速迭代的业务逻辑,需谨慎评估其灵活性限制。

引用说明

- Microsoft Docs. “设计高效的存储过程”. 链接

- Oracle官方文档. “PL/SQL性能调优”. 链接

- AWS Best Practices. “大规模数据库优化”. 链接