上一篇

hive导出mysql

- 行业动态

- 2025-05-14

- 1

通过Sqoop将Hive表数据导出至MySQL需先创建目标表,配置–connect-string/user/password参数并指定字段映射,执行sqoop export –connect … –table … –export-

前置条件与环境准备

在开始Hive数据导出到MySQL之前,需确保以下环境已正确配置:

| 组件 | 版本要求 | 关键配置项 |

|---|---|---|

| Hive | x/3.x | 启用HDFS或本地文件系统存储,配置MetaStore服务 |

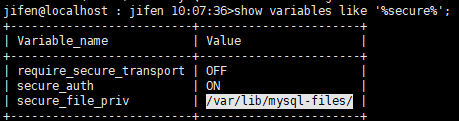

| MySQL | 7+/8.0+ | 开启Binlog日志(建议),调整max_allowed_packet为64M以上 |

| Hadoop生态组件 | 与Hive版本兼容 | 确保HDFS、YARN服务正常运行,Sqoop版本与Hive/MySQL驱动兼容 |

| JDBC驱动 | MySQL Connector/J 8.0+ | 放置于$HIVE_HOME/lib目录,或Sqoop classpath中 |

主流导出方法对比

以下是三种常见导出方式的对比分析:

| 方法 | 适用场景 | 优点 | 缺点 |

|---|---|---|---|

| Sqoop导出 | 大规模数据迁移 | 支持并行导出、增量导入、事务控制 | 需熟悉复杂参数,依赖MapReduce框架 |

| INSERT INTO语句 | 小量实时数据同步 | 语法简单,适合实时查询结果导出 | 仅支持单线程,无并行能力 |

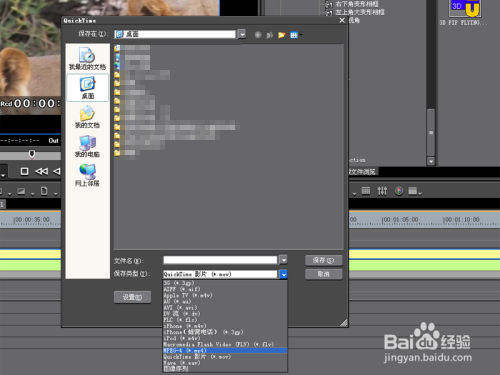

| 中间文件过渡法 | 异构数据源或复杂转换需求 | 灵活性高,可结合ETL工具 | 需手动处理文件加载,流程较繁琐 |

Sqoop导出详细步骤

创建目标MySQL表

CREATE TABLE user_dim (

user_id BIGINT PRIMARY KEY,

username VARCHAR(50) NOT NULL,

age TINYINT,

register_time TIMESTAMP

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4;执行Sqoop导出命令

sqoop export --connect jdbc:mysql://192.168.1.100:3306/test_db --username root --password hadoop --table user_dim --export-dir /user/hive/warehouse/user_dim --input-fields-terminated-by '�01' --num-mappers 4 --verbose

关键参数说明

| 参数 | 作用描述 |

|---|---|

--export-dir | Hive数据存储目录(需为SequenceFile/Parquet等支持格式) |

--input-fields-terminated-by | 字段分隔符(需与Hive表存储格式一致) |

--num-mappers | 并行度设置(通常为节点数2) |

--direct | 启用MySQL原生驱动(需MySQL版本支持) |

直接SQL导出方案

创建MySQL目标表(带分区字段)

CREATE TABLE order_fact_2023 (

order_id BIGINT,

product_id INT,

amount DECIMAL(10,2),

order_date DATE,

region VARCHAR(20),

PRIMARY KEY(order_id, order_date)

) PARTITION BY RANGE(order_date) (

PARTITION p202301 VALUES LESS THAN('2023-02-01'),

PARTITION p202302 VALUES LESS THAN('2023-03-01')

);Hive端执行导出语句

INSERT INTO OUTFILE '/tmp/order_fact_2023.csv' SELECT FROM order_fact_2023 WHERE order_date BETWEEN '2023-01-01' AND '2023-03-31';

加载CSV到MySQL

mysql -uroot -phadoop test_db < load_data.sql

其中load_data.sql内容为:

LOAD DATA INFILE '/tmp/order_fact_2023.csv' INTO TABLE order_fact_2023 FIELDS TERMINATED BY ',' ENCLOSED BY '"' LINES TERMINATED BY ' ' IGNORE 1 LINES;

数据类型映射规则

| Hive数据类型 | MySQL推荐类型 | 注意事项 |

|---|---|---|

| BOOLEAN | TINYINT(1) | 使用0/1表示false/true |

| DOUBLE | DECIMAL(18,4) | 根据精度需求调整DECIMAL位数 |

| STRING | VARCHAR(MAX) | 需明确指定长度,建议不超过65535字符 |

| ARRAY/MAP/STRUCT | JSON(需手动处理) | 建议转换为JSON字符串存储 |

| TIMESTAMP | DATETIME/TIMESTAMP | 注意时区差异,建议统一UTC存储 |

性能优化策略

Sqoop调优参数

| 参数 | 优化效果 |

|---|---|

--split-by | 指定分桶字段(需高基数字段) |

--compress | 启用压缩(如gzip/bzip2) |

--fetch-size | 设置JDBC抓取批次大小(默认1000,可调整至5000) |

MySQL端优化

- 关闭外键约束和索引:

SET FOREIGN_KEY_CHECKS=0; - 调整

innodb_buffer_pool_size为物理内存的60-80% - 使用

LOAD DATA LOCAL INFILE替代INSERT语句 - 预创建索引:

ALTER TABLE ... ADD INDEX(导出后执行)

常见问题与解决方案

字符集乱码问题

- 现象:中文显示为???或乱码

- 解决方案:

- Hive端设置

set mapreduce.map.output.encoding=UTF-8 - MySQL建表时指定

DEFAULT CHARSET=utf8mb4 - Sqoop命令添加

--character-set=utf8参数

- Hive端设置

数据量过大导致OOM

- 现象:Task运行失败,提示内存不足

- 解决方案:

- 调整

--num-mappers为node_count2 - 设置

mapreduce.map.memory.mb为4096(需配合yarn.nodemanager.resource.memory-mb) - 启用数据压缩(

--compress)

- 调整

数据校验方法

| 校验维度 | 操作方法 |

|---|---|

| 记录数比对 | SELECT COUNT() FROM hive_table; vs SELECT COUNT() FROM mysql_table; |

| 抽样校验 | SELECT FROM hive_table LIMIT 10; vs SELECT FROM mysql_table LIMIT 10; |

| 空值检测 | SELECT COUNT() FROM mysql_table WHERE column IS NULL; |

| 主键冲突检查 | SHOW WARNINGS;(当Sqoop报告重复键错误时) |

完整操作流程示例

# Step1: 创建Hive临时表 hive -e "CREATE TABLE IF NOT EXISTS user_temp STORED AS PARQUET AS SELECT FROM user_info;" # Step2: 执行Sqoop导出 sqoop export --connect jdbc:mysql://localhost:3306/test --username root --password root --table user_dim --export-dir /user/hive/user_temp --input-fields-terminated-by 't' --num-mappers 8 --verbose # Step3: 数据校验 mysql -uroot -proot -e "ANALYZE TABLE user_dim;" test_db hive -e "SELECT count() FROM user_temp;"

相关FAQs

Q1: Sqoop导出时出现”Java security exception”如何解决?

A1: 这是由于JDBC驱动未正确加载导致的,解决方法:

- 将MySQL驱动jar包(如

mysql-connector-java-8.0.xx.jar)放入$HIVE_HOME/lib目录 - 或在Sqoop命令中指定

--driver com.mysql.jdbc.Driver并设置--jars参数指向驱动路径 - 检查Hadoop环境变量

HADOOP_CLASSPATH是否包含驱动路径

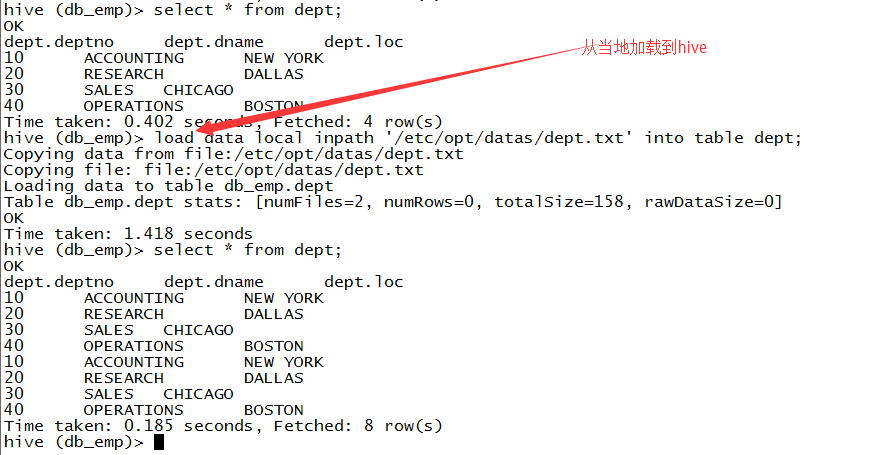

Q2: 导出后MySQL表出现大量重复数据怎么办?

A2: 这是主键冲突或唯一索引冲突的典型症状,可通过以下方式处理:

- 去重导出:在Hive查询中添加

DISTRIBUTE BY分桶并设置ROW_NUMBER()过滤重复数据INSERT OVERWRITE DIVICED BY(user_id) SELECT FROM ( SELECT , ROW_NUMBER() OVER(PARTITION BY user_id ORDER BY update_time DESC) as rn FROM user_info) t WHERE t.rn=1; - Sqoop参数配置:添加

--update-key参数指定主键列,或使用--update-mode allowinsert允许插入新记录 - MySQL端处理:提前清空目标表或改用

REPLACE INTO语句加载数据