上一篇

分布式存储系统会出现哪些问题

- 行业动态

- 2025-05-13

- 11

分布式存储系统易出现数据一致性保障难、节点失效导致服务中断、网络延迟或分区影响性能、负载不均衡降低效率、冗余与恢复

分布式存储系统常见问题分析

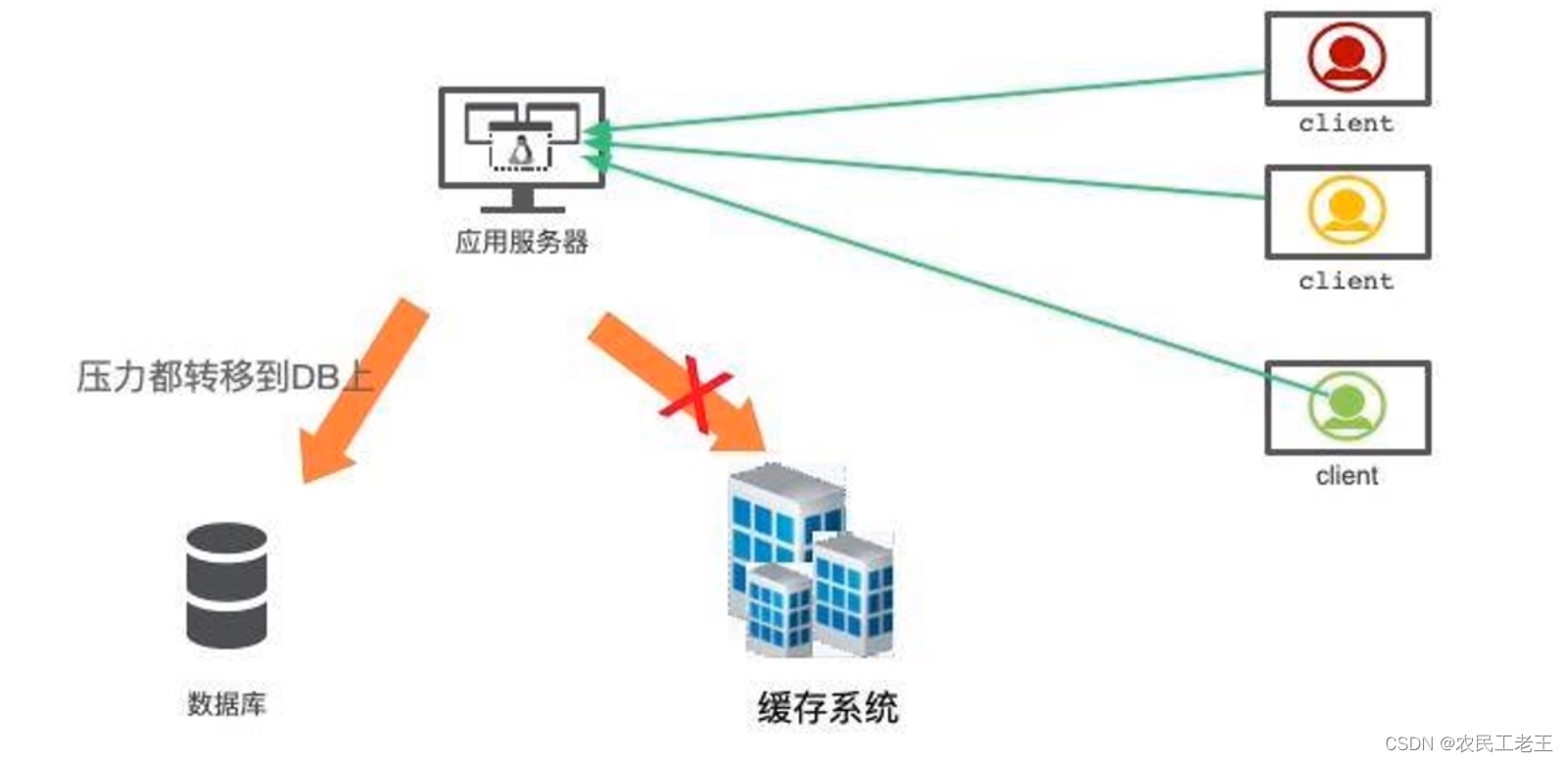

分布式存储系统通过将数据分散存储在多个节点上,实现数据的高可用性、可扩展性和容错能力,由于其复杂的架构设计和运行环境,实际应用中可能面临多种挑战,以下是分布式存储系统常见的核心问题分类及具体表现:

数据一致性问题

分布式系统中,数据副本之间的状态同步是核心难题,主要体现在以下方面:

| 问题类型 | 具体表现 |

|---|---|

| 强一致性与可用性矛盾 | 遵循CAP定理,在网络分区(Partition)时,系统需在一致性(Consistency)和可用性(Availability)之间权衡,Zabbix监控数据写入时,若采用强一致性协议(如Paxos),可能出现短暂不可写;若放宽一致性,则可能产生脏数据。 |

| 分布式事务复杂性 | 跨节点的数据操作需依赖两阶段提交(2PC)或三阶段提交(3PC)协议,但这类协议会显著增加延迟,电商订单处理若涉及多存储节点,可能因事务超时而失败。 |

| 数据版本冲突 | 不同客户端并发修改同一数据时,可能因版本控制不当导致覆盖或丢失,文档协作编辑中,若未采用乐观锁或冲突检测机制,会出现内容覆盖问题。 |

可用性与容错性挑战

分布式存储需应对节点故障、网络异常等问题,但实际设计中可能存在以下隐患:

| 问题类型 | 具体表现 |

|---|---|

| 单点故障风险 | 元数据管理节点(如HDFS的NameNode)若未采用主备或联邦架构,可能成为系统瓶颈,NameNode宕机会导致全集群不可写。 |

| 脑裂问题(Split-Brain) | 网络分区导致节点间失联时,不同分区可能同时选举出主节点,造成数据双向写入冲突,Redis Cluster若未开启合理的心跳检测,可能触发脑裂。 |

| 数据恢复延迟 | 节点故障后,需从其他副本重新复制数据,若存储海量小文件(如Ceph对象存储),恢复时间可能长达数小时。 |

网络与通信问题

分布式存储依赖网络传输数据,网络质量直接影响系统性能:

| 问题类型 | 具体表现 |

|---|---|

| 高延迟与带宽瓶颈 | 跨地域部署时,网络延迟可能导致读写性能下降,AWS S3跨国复制可能因带宽不足导致延迟激增。 |

| 心跳与RPC开销 | 节点间频繁的心跳检测(如Etcd的Leader选举)和RPC调用会消耗大量网络资源,在千节点规模集群中,可能占用10%以上的带宽。 |

| 协议兼容性 | 不同存储系统可能采用差异化的通信协议(如gRPC、Thrift),混合部署时需额外适配层。 |

数据冗余与存储效率

为保证可靠性,分布式存储通常采用数据冗余策略,但可能引发额外问题:

| 问题类型 | 具体表现 |

|---|---|

| 存储空间浪费 | 3副本策略(如HDFS)会消耗3倍原始存储空间,若存储10TB数据,实际占用30TB,成本显著增加。 |

| 读写放大效应 | 写入数据需同步到所有副本,读取时可能需访问多个副本投票(如DynamoDB的Quorum Read),导致IO放大。 |

| 副本一致性滞后 | 异步复制(如MinIO)可能在主副本写入后,从副本尚未完成同步时发生故障,导致数据丢失。 |

负载均衡与扩展性

动态扩缩容和数据分布不均可能引发性能瓶颈:

| 问题类型 | 具体表现 |

|---|---|

| 数据倾斜 | 哈希算法设计不当可能导致部分节点存储过多热点数据,TikTok用户画像数据可能集中存储于少数节点,造成负载过高。 |

| 元数据瓶颈 | 元数据服务(如Ceph Monitor)在扩展时可能因锁竞争导致性能下降,百万级文件目录的元数据操作可能延迟至秒级。 |

| 异构硬件适配 | 新增节点的硬件配置(如磁盘类型、网络带宽)与现有集群差异较大时,可能影响数据分片策略。 |

安全与权限管理

分布式存储的开放性带来安全隐患:

| 问题类型 | 具体表现 |

|---|---|

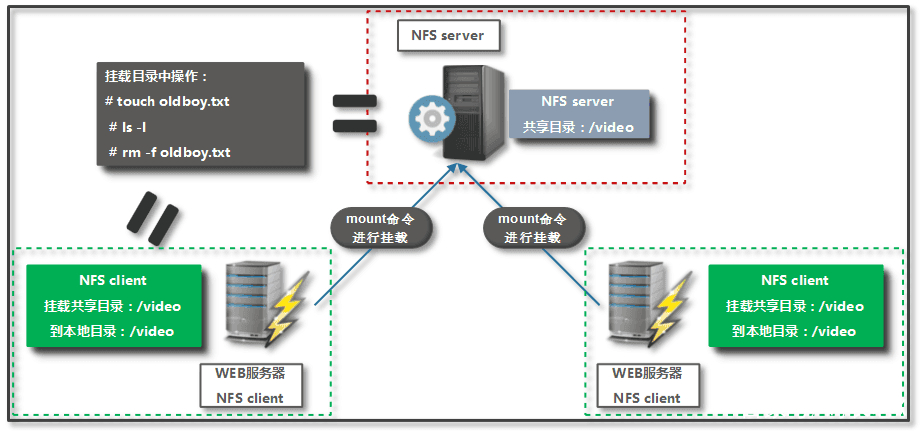

| 数据泄露风险 | 未加密的存储系统(如NFS)可能被内部人员或攻击者窃取数据,RDS实例若未启用KMS加密,可能泄露敏感信息。 |

| 权限模型复杂性 | 细粒度权限控制(如Ceph的CRUSH Map)难以管理,可能导致权限误配,错误配置的S3 Bucket可能暴露企业数据。 |

| 审计与合规挑战 | 跨区域数据存储需满足不同司法管辖区的合规要求(如GDPR),日志收集和审计可能因节点分散而困难。 |

运维与成本问题

分布式系统的复杂性对运维提出高要求:

| 问题类型 | 具体表现 |

|---|---|

| 监控与排障难度 | 数千节点的集群中,定位故障根源(如网络丢包、磁盘慢响应)需高效监控工具,Prometheus采集的指标可能高达数万项。 |

| 硬件成本高昂 | 高端存储设备(如SSD)、专用网络设备(如RDMA交换机)显著增加初期投入,PB级Ceph集群硬件成本可达千万级别。 |

| 运维人力依赖 | 复杂系统(如GlusterFS)的部署、扩容、故障恢复需要资深工程师,人力成本占比高。 |

FAQs

Q1:CAP定理如何影响分布式存储系统的设计?

A1:CAP定理指出,分布式系统无法同时满足一致性(Consistency)、可用性(Availability)和分区容错性(Partition Tolerance),实际设计中需根据业务需求权衡:

- 强一致性优先:如银行交易系统,选择牺牲部分可用性(如等待网络恢复)。

- 高可用性优先:如社交媒体图片存储,允许短暂数据不一致,但需保证服务持续可用。

- 分区容错性必备:所有分布式系统均需应对网络分区,因此必须在C和A之间取舍。

Q2:如何缓解分布式存储中的数据倾斜问题?

A2:数据倾斜常见于哈希分片不均匀或业务访问热点集中,缓解方法包括:

- 改进哈希算法:采用一致性哈希(如Ceph的CRUSH算法)或虚拟节点技术,减少分片分布不均。

- 动态负载均衡:实时监控节点负载,通过数据迁移(如SeaweedFS的Volume平衡)或请求路由调整实现均衡。

- 冷热数据分层:将高频访问的热数据分配至高性能节点,冷数据存储于低成本节点(如阿里云OSS