上一篇

hadoop导入数据

- 行业动态

- 2025-05-12

- 6

Hadoop导入数据可通过HDFS命令行(put)、Sqoop工具(关系库导入)、Flume实时采集(日志流)及Java/Python API接口实现,支持批量/实时多源

Hadoop数据导入详解

Hadoop作为分布式大数据处理框架,其核心组件HDFS(Hadoop Distributed File System)为数据存储提供了高可靠性和可扩展性,在实际业务中,如何将不同来源的数据高效导入Hadoop集群,是数据处理流程的关键第一步,以下从工具选择、操作步骤、优化策略等方面展开详细说明。

Hadoop数据导入的核心工具与场景

| 工具/方法 | 适用数据源 | 典型命令/操作 | 适用场景 |

|---|---|---|---|

| HDFS命令行工具 | 本地文件、日志、压缩包 | hadoop fs -put-copyFromLocal | 小规模文件批量上传或脚本自动化 |

| Sqoop | 关系型数据库(MySQL、Oracle等) | sqoop import --connect--table | 结构化数据迁移(如ETL离线任务) |

| Flume | 实时日志流(Kafka、TCP、文件) | 配置Source、Channel、Sink | 实时数据采集(如日志收集、设备数据流) |

| S3兼容工具(如DistCp) | 云存储(AWS S3、阿里云OSS) | hadoop distcp -source-dest | 跨存储系统迁移(如云存储与HDFS互导) |

| 自定义API/SDK | 任意数据源(HTTP、RPC接口等) | Java/Python API写入HDFS | 需要深度集成的第三方系统数据同步 |

主流数据导入方法详解

HDFS命令行工具导入

- 操作步骤:

- 将本地文件上传至HDFS:

hadoop fs -put /local/path/file.txt /hdfs/path/

- 批量上传目录:

hadoop fs -copyFromLocal /local/dir /hdfs/dir

- 将本地文件上传至HDFS:

- 优化建议:

- 大文件分块上传:启用HDFS的

dfs.client.block.write.locations参数,分散写入压力。 - 并发上传:使用

-f参数强制覆盖时配合parallel-upload工具(如Hadoop自带的distcp)。

- 大文件分块上传:启用HDFS的

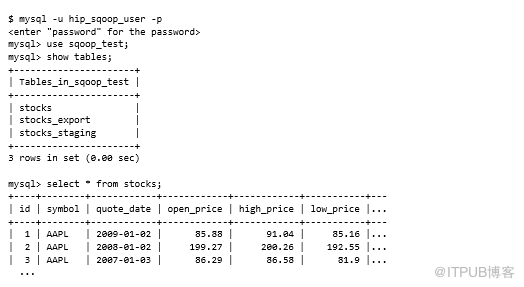

Sqoop导入关系型数据库

- 典型流程:

- 全量导入表数据:

sqoop import --connect jdbc:mysql://host:port/dbname --username user --password pass --table table_name --target-dir /hdfs/path/

- 增量导入(基于时间戳):

sqoop import --append --check-column last_update_time --last-value "2023-01-01"

- 全量导入表数据:

- 注意事项:

- 字段类型映射:需确保数据库字段与HDFS文件格式(如Parquet、Avro)兼容。

- 并行度调整:通过

--num-mappers参数控制并发任务数,提升导入速度。

Flume实时数据采集

配置示例(采集Kafka日志并写入HDFS):

# flume-conf.properties agent.sources = kafka-source agent.sinks = hdfs-sink agent.channels = memory-channel agent.sources.kafka-source.type = org.apache.flume.source.kafka.KafkaSource agent.sources.kafka-source.kafka.bootstrap.servers = kafka-broker:9092 agent.sources.kafka-source.kafka.topics = log-topic agent.sinks.hdfs-sink.type = hdfs agent.sinks.hdfs-sink.hdfs.path = hdfs:///flume/logs/%Y-%m-%d/%H-%M/ agent.sinks.hdfs-sink.hdfs.fileType = DataStream agent.sinks.hdfs-sink.hdfs.writeFormat = Text agent.sinks.hdfs-sink.hdfs.batchSize = 1000 agent.channels.memory-channel.type = memory agent.channels.memory-channel.capacity = 10000 agent.channels.memory-channel.transactionCapacity = 1000

优势:支持多源实时聚合,适合流式数据处理场景。

DistCp跨存储迁移

- 命令示例(从S3迁移数据到HDFS):

hadoop distcp -source s3a://bucket/path/ -dest /hdfs/path/

- 关键点:需提前配置S3访问权限(如AWS凭证),并启用

-skipCrccheck跳过校验以加速传输。

数据导入优化策略

数据分区与分桶:

- 根据业务字段(如日期、用户ID)对数据进行分区存储,减少查询时扫描范围。

- 示例:按天分区存储日志文件,路径格式为

/data/logs/2023-10-01/。

压缩与编码优化:

- 使用Snappy、Gzip等压缩算法减少存储空间和网络传输带宽。

- 开启文件纠删码(Erasure Coding)替代副本存储,提升存储效率。

并行度与资源调优:

- Sqoop/Flume任务的

mapreduce.job.reduces设置为0(仅Map阶段)。 - HDFS客户端

dfs.replication默认值根据集群规模调整(如3副本)。

- Sqoop/Flume任务的

数据校验与监控:

- 使用

Checksum验证文件完整性:hadoop fs -checksum /file/path/。 - 通过Hadoop UI或Prometheus监控导入任务的吞吐量、延迟等指标。

- 使用

常见问题与解决方案(FAQs)

Q1:导入数据后发现文件格式与业务需求不符(如CSV转Parquet失败)怎么办?

A1:需在导入后增加数据转换步骤。

- 使用

hadoop jar运行自定义MapReduce程序,将CSV解析为结构化数据。 - 通过Spark读取原始数据并保存为Parquet格式:

from pyspark.sql import SparkSession spark = SparkSession.builder.appName("csv_to_parquet").getOrCreate() df = spark.read.csv("/hdfs/input/", header=True) df.write.parquet("/hdfs/output/")

Q2:大规模数据导入时HDFS NameNode内存溢出如何解决?

A2:优化方案包括:

- 分批导入:将大文件拆分为多个小文件(如50GB以内),避免单次操作生成过多元数据。

- 调整JVM参数:修改

dfs.namenode.heap.size(如从1G提升至4G),重启NameNode生效。 - 启用HA模式:通过Active/Standby双NameNode分担压力,提升集群