上一篇

分布式存储和查询

- 行业动态

- 2025-05-14

- 1

分布式存储通过数据分片、冗余备份及一致性哈希保障可靠性,查询依托分布式索引与并行计算提升效率

分布式存储与查询的核心原理及实践

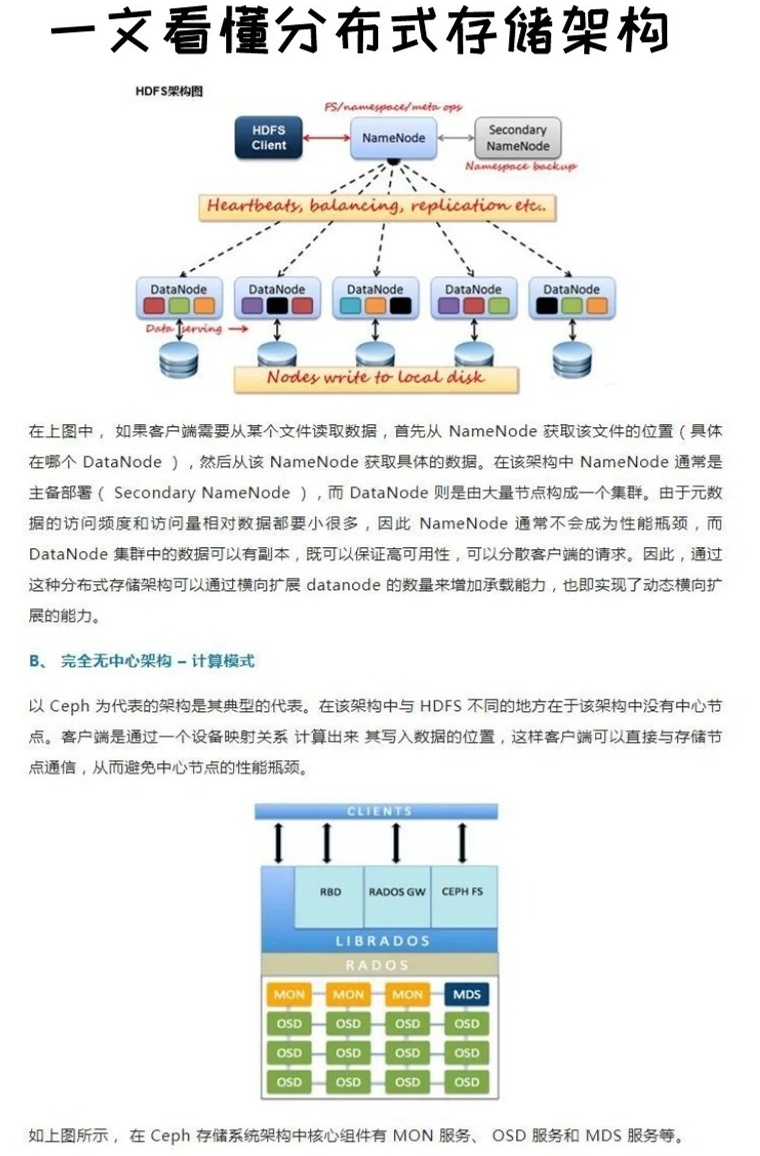

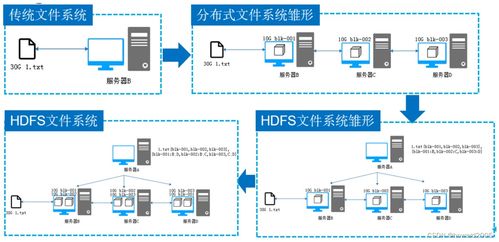

分布式存储的基础架构

分布式存储通过将数据分散存储在多个节点上,实现容量扩展与高可用性,其核心设计目标包括数据分片(Sharding)、冗余备份、负载均衡及故障恢复。

数据分片策略

| 分片方式 | 描述 | 适用场景 |

|———-|——|———-|

| 哈希分片 | 基于Key的哈希值分配数据 | 键值存储(如Redis Cluster)|

| 范围分片 | 按数据范围划分(如时间、ID区间) | 时序数据库、日志系统 |

| 目录分片 | 通过目录服务管理分片元数据 | 大数据平台(如HDFS) |

数据冗余机制

- 副本复制:每个分片存储多份副本(如3副本),提升容错性(如HDFS、Ceph)。

- 纠删码:通过编码算法减少冗余存储(如RAID、Azure Storage)。

- 一致性模型:强一致性(如Quorum NRW=2) vs 最终一致性(如DynamoDB)。

分布式查询的挑战与优化

分布式查询需解决数据定位、网络延迟、结果合并等问题,典型流程包括:

- 路由解析:通过元数据服务(如Hive Metastore)确定数据分片位置。

- 并行执行:在多个节点同时执行查询子任务(如Presto的Stage执行)。

- 结果聚合:汇总各节点结果并排序(如Elasticsearch的Reduce阶段)。

优化策略

- 数据本地化:优先在数据所在节点执行计算(Hadoop YARN)。

- 索引加速:构建二级索引(如Cassandra的Materialized Views)。

- 缓存机制:热点数据预加载至内存(如Memcached+Redis组合)。

典型分布式存储与查询系统对比

| 系统 | 存储模型 | 查询引擎 | 一致性 | 适用场景 |

|---|---|---|---|---|

| HDFS | 文件分块 | MapReduce | 强一致 | 离线批处理 |

| Ceph | 对象存储 | RADOS GW | 可配置 | 云存储底座 |

| Cassandra | 列族 | CQL | 最终一致 | 高写入吞吐 |

| Elasticsearch | 倒排索引 | DS-LTR | 近实时 | 全文检索 |

核心问题与解决方案

数据倾斜问题

- 现象:部分节点负载过高,导致查询延迟。

- 解法:动态分片调整(如MongoDB Auto-Sharding)、哈希取模优化。

多节点一致性保障

- Paxos/Raft协议:用于元数据一致性(如etcd、Consul)。

- 读写分离策略:主节点写+从节点读(如TiDB的MVCC)。

实际应用案例

- 互联网日志分析:Kafka(分布式日志) + Flink(流式查询)实现实时统计。

- 云存储服务:MinIO(兼容S3) + Presto(交互式分析)支持PB级数据。

- 元宇宙数据管理:IPFS(内容寻址存储) + GraphQL(联邦查询)实现去中心化访问。

未来趋势

- 存算一体化:计算任务直接下沉至存储节点(如AWS Nitro)。

- AI驱动优化:自动分片调整(如Spark Adaptive Query Execution)。

- 多模数据融合:支持结构化、半结构化、非结构化混合存储(如Google Bigtable)。

FAQs

Q1:如何选择分布式存储系统?

A:需评估以下维度:

- 数据类型:结构化选HBase,非结构化选对象存储。

- 访问模式:高频写入选Cassandra,复杂查询选Greenplum。

- 成本敏感度:开源方案(Ceph) vs 商业服务(AWS S3)。

Q2:分布式查询如何保证低延迟?

A:关键措施包括:

- 数据预热:提前缓存热点数据至内存层。

- 智能路由:基于查询频率动态调整分片策略。

- 向量化执行:批量处理数据(如ClickHouse的Column