上一篇

分布式存储节点间容灾

- 行业动态

- 2025-05-13

- 10

分布式存储节点间容灾通过多副本冗余、自动故障切换、一致性协议(如Raft)及快速恢复机制,确保单点故障时数据不丢失且服务持续可用

分布式存储节点间容灾机制详解

核心概念与目标

分布式存储系统通过将数据分散存储在多个节点上,实现高性能与高可用,节点间容灾的核心目标是:

- 数据持久性:单点故障不会导致数据丢失

- 服务连续性:故障时自动切换,保障业务无感知

- 扩展性:支持动态扩缩容而不影响容灾能力

- 性能平衡:容灾机制不应显著降低读写性能

| 关键指标 | 描述 |

|---|---|

| MTTR(平均修复时间) | 故障检测到服务恢复的时间,理想状态<30秒 |

| RPO(数据恢复点) | 故障时允许丢失的数据量,通常要求<1秒 |

| RTO(恢复时间) | 业务中断的最大容忍时间,一般要求接近零中断 |

核心技术原理

数据冗余策略

| 策略类型 | 实现方式 | 优缺点分析 |

|---|---|---|

| 副本复制 | 同步/异步复制3个以上副本 | 简单可靠,但存储成本高(通常300%原始空间) |

| 纠删编码 | 将数据分割为N块+M校验块 | 存储效率提升(如12块+4校验块可容忍4节点故障),但计算复杂度高 |

| 混合模式 | 热数据用副本+冷数据用纠删码 | 兼顾性能与空间效率,需智能数据分层机制 |

一致性协议

- 强一致性:采用Paxos/Raft协议,保证所有副本状态一致(如etcd/ZooKeeper)

- 最终一致性:允许短暂数据差异,通过版本合并机制解决冲突(如DynamoDB)

- Quorum机制:多数派确认原则(如Ceph的CRUSH算法)

故障检测机制

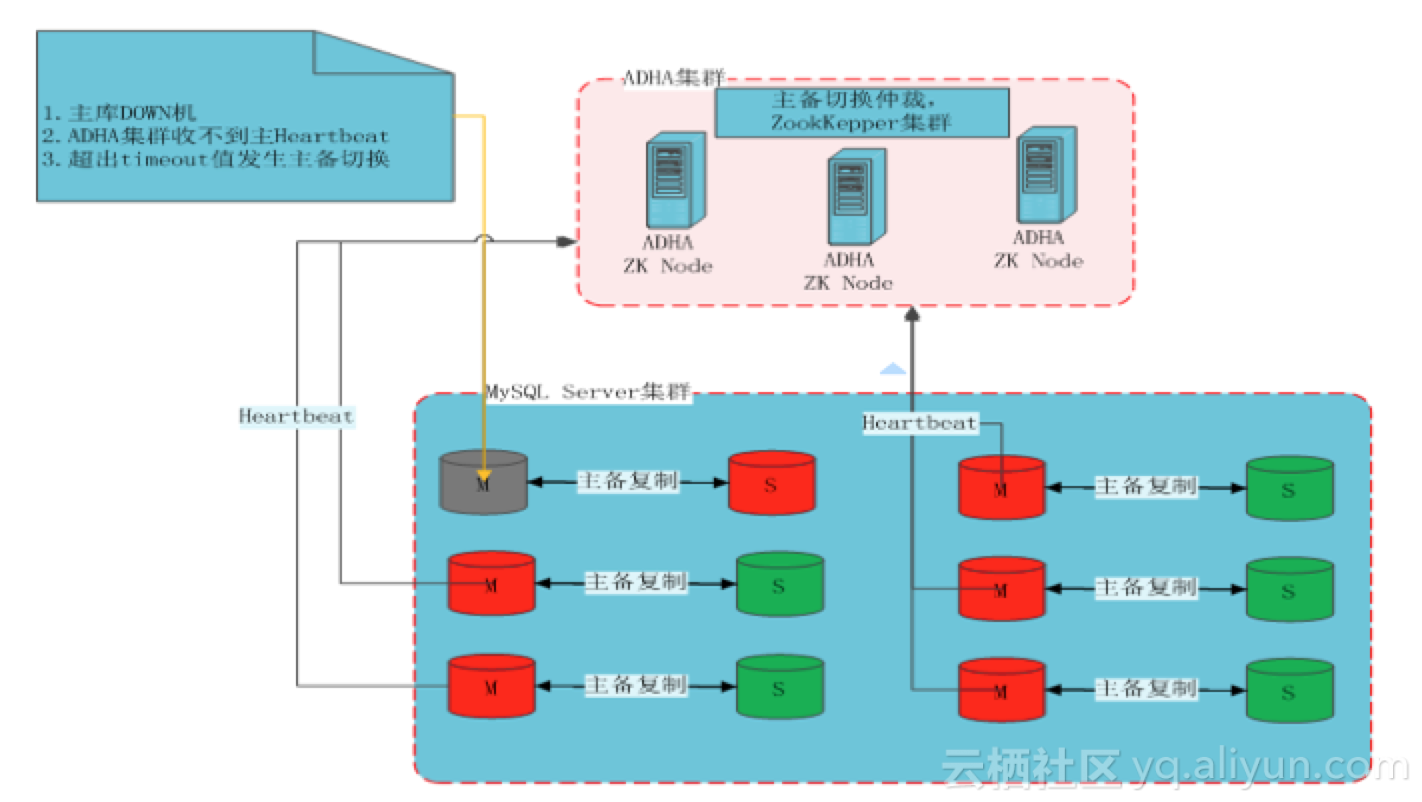

- 心跳检测:节点定期发送健康状态(如每5秒一次)

- 数据校验:后台持续扫描校验数据完整性(如SCSI TAPE的CRC校验)

- 仲裁机制:通过独立节点判断故障合法性(防止脑裂问题)

关键技术实现

数据分片与副本分配

# 典型分片策略示例(伪代码)

def allocate_replicas(data_id, node_list):

# 根据CRUSH算法计算哈希值

hash_val = consistent_hash(data_id)

# 选取顺时针最近的3个节点作为主副本

primary = node_list[hash_val % len(node_list)]

replica1 = node_list[(hash_val+1) % len(node_list)]

replica2 = node_list[(hash_val+2) % len(node_log)]

return [primary, replica1, replica2]故障转移流程

- 故障检测:超过3个心跳周期未响应则标记异常

- 领导选举:基于Raft协议选举新主节点(通常耗时<500ms)

- 数据重建:优先使用最高版本副本进行数据同步

- 服务切换:DNS或负载均衡器更新路由配置

脑裂问题解决方案

- 仲裁节点机制:部署独立Quorum节点判断合法主节点

- 租约机制:主节点定期更新存活租约(如200ms续租周期)

- 版本向量:记录每个副本的操作序列,冲突时按版本合并

典型场景对比

| 场景类型 | 推荐方案 | 关键参数设置 |

|---|---|---|

| 同城双活 | 3副本+异步复制 | 复制延迟<50ms,RPO≈1秒 |

| 跨城容灾 | 5副本+纠删码 | 网络带宽≥10Gbps,开启应用层数据压缩 |

| 云原生环境 | StatefulSet+CSI插件 | 使用PersistentVolumeClaim配置多AZ存储类 |

| 边缘计算 | 2副本+本地缓存 | 缓存过期时间<30分钟,同步周期可调 |

性能优化策略

分级存储:

- 热数据:3副本+SSD存储

- 温数据:纠删码+HDD存储

- 冷数据:EC+对象存储

智能负载:

- 读请求优先访问最近节点(GPS坐标哈希)

- 写请求采用链式复制减少带宽峰值

流量整形:

- 非高峰时段执行数据重建(如凌晨0-4点)

- 限制单节点重建速度(建议≤80%带宽)

实战案例分析

Case1:Ceph集群容灾实践

- 架构:12个OSD节点+4个Mon节点+PGN=128

- 策略:CRUSH地图配置跨机柜分布,副本数=3

- 效果:单节点故障恢复时间<8秒,每年数据丢失率为0

Case2:GlusterFS异地容灾

- 配置:2个数据中心,延时100ms

- 优化:启用AFR(Automatic File Replication)+ write-behind日志

- 问题:跨网段复制导致写性能下降30%,通过增量同步机制解决

未来演进方向

- AI驱动容灾:基于机器学习预测节点故障(准确率>95%)

- Serverless化:函数级数据处理单元自动伸缩

- 量子存储:利用量子纠缠特性实现瞬时数据同步

- 3D-XPoint内存:存算一体架构降低延迟至微秒级

FAQs

Q1:如何选择合适的容灾策略?

A1:需综合考虑三个维度:

- 数据重要性:核心业务建议强3副本,日志类数据可用纠删码

- 网络条件:跨城场景建议异步复制,同机房优先同步复制

- 硬件成本:存储密度要求高时采用EC,性能优先选副本机制

Q2:如何验证容灾系统的有效性?

A2:应实施以下测试:

- 混沌工程:随机断网/宕机/磁盘损坏测试(每月至少1次)

- 压力测试:模拟并发故障(如同时故障2个节点)

- 数据完整性校验:使用SHA-256校验码扫描全量数据

- 切换演练:定期进行主备节点角色互换操作