hive插数据库

- 行业动态

- 2025-05-12

- 7

Hive插入数据库需先创建 数据库和表,通过INSERT或LOAD导入数据,支持从本地、HDFS或用Sqoop从外部数据库导入

Hive数据插入详解:方法、场景与实践指南

Hive数据插入基础

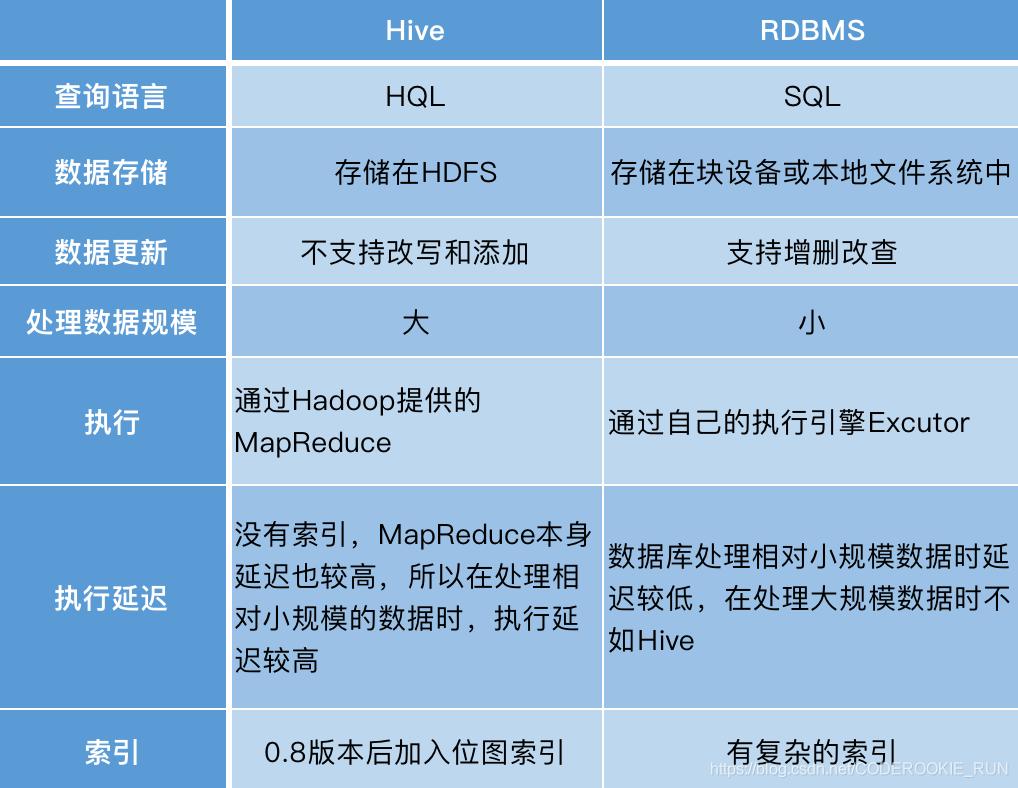

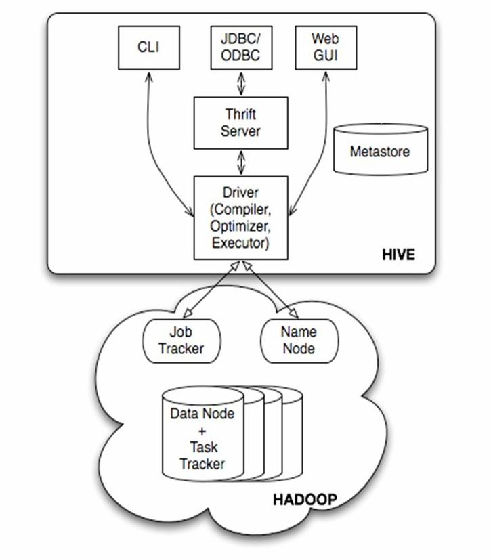

Hive作为基于Hadoop的数据仓库工具,其核心功能之一是实现大规模数据的存储与分析,数据插入操作是Hive数据流程的起点,直接影响后续查询性能与数据管理效率,本文将从基础语法、进阶技巧到实战场景,全面解析Hive数据插入的关键技术。

核心插入方法与语法

| 插入方式 | 适用场景 | 语法特征 | 数据覆盖行为 |

|---|---|---|---|

LOAD DATA | 本地/HDFS文件导入 | 无FROM子句,需指定路径 | 覆盖(默认)/追加 |

INSERT INTO | 查询结果插入 | 需SELECT子句,支持多表关联 | 追加(默认) |

INSERT OVERWRITE | 覆盖目标表数据 | 强制覆盖,删除原有数据 | 完全覆盖 |

CREATE TABLE AS | 新建表并插入数据 | 需完整建表语句 | 新表初始化 |

IMPORT TABLE | 跨数据库/集群导入(需配置) | 依赖元数据同步机制 | 完整复制 |

基础语法示例:

-从本地文件系统加载数据(需确保hive.exec.scratchdir配置正确) LOAD DATA LOCAL INPATH '/home/user/data.csv' INTO TABLE raw_data; -从HDFS路径加载数据(覆盖模式) LOAD DATA INPATH '/user/hive/warehouse/input' INTO TABLE processed_data OVERWRITE; -插入查询结果(追加模式) INSERT INTO TABLE sales_archive SELECT FROM daily_sales WHERE transaction_date < '2023-01-01';

分区表插入策略

分区表是Hive优化查询的核心特性,插入时需特别注意分区处理:

静态分区插入

需显式指定分区值,适用于已知分区场景:

INSERT INTO TABLE user_logs PARTITION(country='US', date='2023-10-01') SELECT FROM staging_logs WHERE user_id IS NOT NULL;

动态分区插入

自动根据数据内容创建分区,需开启相关配置:SET hive.exec.dynamic.partition=true; SET hive.exec.dynamic.partition.mode=nonstrict; -允许部分分区失败 INSERT INTO TABLE sensor_data PARTITION(device_id, record_time) SELECT FROM raw_sensor;

动态分区关键配置:

| 参数 | 作用 | 默认值 |

|——————————|———————————–|————–|

| hive.exec.dynamic.partition | 启用动态分区 | false |

| hive.exec.dynamic.partition.mode | 严格模式(all/nonstrict/strict) | strict |

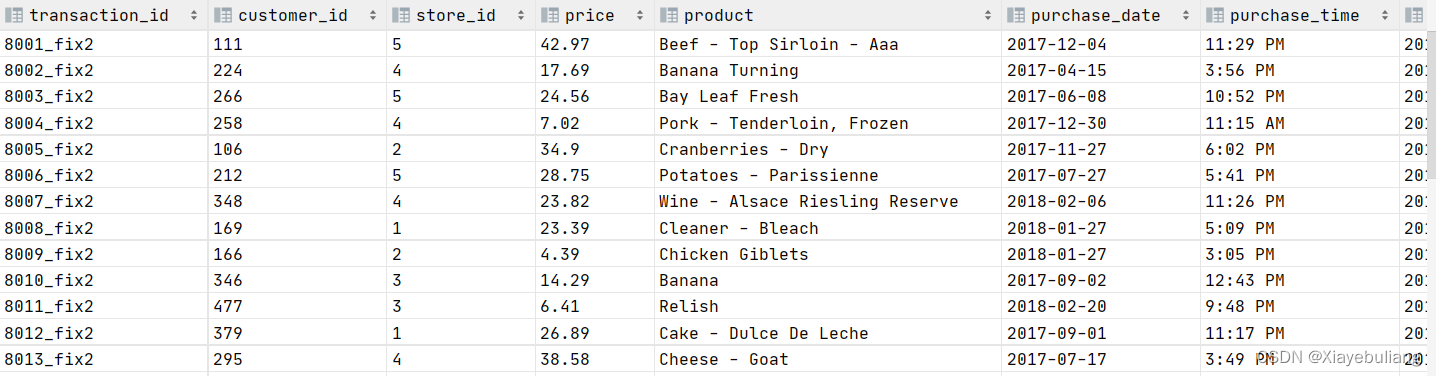

外部数据源导入

Hive支持多种异构数据源导入,常见场景及实现:

| 数据源类型 | 工具/语法 | 注意事项 |

|---|---|---|

| 关系型数据库(如MySQL) | INSERT INTO + JDBC连接 | 需配置hive.jdbc.connection参数,建议使用Sqoop for大规模导入 |

| HDFS文件 | LOAD DATA INPATH | 确保文件格式与表结构匹配(如分隔符、字段顺序) |

| 本地文件系统 | LOAD DATA LOCAL INPATH | 需保证Hive服务器有文件访问权限,推荐先上传至HDFS |

| Kafka流数据 | Hive Kafka Storage Handler | 需集成Kafka客户端,配置kafka.bootstrap.servers等参数 |

Sqoop导入示例:

sqoop import --connect jdbc:mysql://dbserver:3306/orders_db --username admin --password secret --table customer_info --hive-import --hive-table customer_hive --m 4 --target-dir /user/hive/external/customer;

高级插入技巧

多表联合插入

通过INSERT结合UNION ALL实现多源数据合并:INSERT INTO TABLE unified_logs SELECT FROM app_logs UNION ALL SELECT FROM server_logs UNION ALL SELECT FROM security_logs;

事务性插入(ACID表)

需启用Hive事务支持(hive.txn.manager=org.apache.hadoop.hive.ql.lockmgr.DbTxnManager):INSERT INTO TABLE transactional_data VALUES (1, 'data1'); ROLLBACK; -回滚未提交的变更

自定义序列化格式

使用ROW FORMAT指定复杂数据结构:CREATE TABLE json_data ( user_id BIGINT, event_time TIMESTAMP, properties MAP<STRING, STRING> ) ROW FORMAT SERDE 'org.apache.hive.hcatalog.data.JsonSerDe';

常见问题与解决方案

Q1:插入数据时提示”Permission denied”

A1:原因可能是HDFS目录权限不足,解决方案:

- 检查目标表所在HDFS路径的所有者和权限(

hdfs dfs -ls /path) - 使用

HDFS dfs -chmod调整权限或联系管理员赋予写入权限 - 确认当前用户具有Hive表的

INSERT权限(GRANT INSERT ON TABLE ...)

Q2:动态分区插入失败,报错”Partition not found”

A2:可能原因及处理步骤:

- 检查是否启用动态分区(

SET hive.exec.dynamic.partition=true) - 确认

hive.exec.dynamic.partition.mode设置为nonstrict(允许部分分区失败) - 验证源数据中分区字段是否存在空值或非规值

- 手动创建缺失的分区目录(临时解决方案):

hdfs dfs -mkdir -p /warehouse/tablespace/sensor_data/device_id=123/record_time=2023-10-01;

性能优化建议

| 优化方向 | 具体措施 |

|---|---|

| 文件大小控制 | 设置mapreduce.job.split.metainfo.maxsize防止小文件过多 |

| 并发插入 | 调整hive.exec.parallel参数启用并行执行 |

| 压缩存储 | 使用ORC格式配合ZLIB压缩减少存储空间 |

| 索引加速 | 对高频查询字段建立COMPACT或BLOOM索引 |