上一篇

hive不用数据库

- 行业动态

- 2025-05-12

- 5

Hive基于HDFS存储数据,采用文件系统管理,通过元数据定义表结构,无需传统数据库引擎

Hive不依赖传统数据库的核心机制与实践应用

Hive的架构与数据存储原理

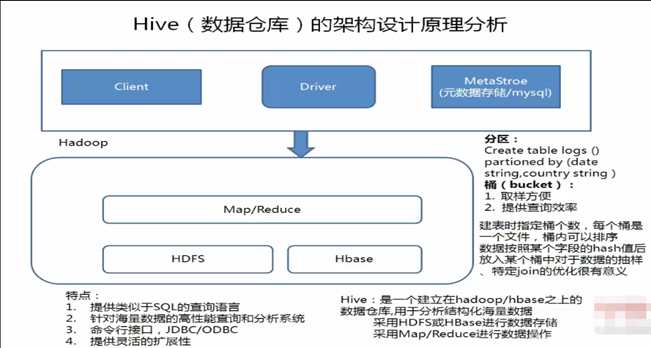

Hive是一种基于Hadoop的数据仓库工具,其核心设计目标是通过类SQL语言(HiveQL)实现对大规模数据的分布式处理,与传统数据库不同,Hive不依赖独立的数据库系统存储数据,而是直接利用Hadoop生态系统中的HDFS(Hadoop Distributed File System)作为底层存储引擎,以下是Hive的关键架构特点:

| 组件 | 功能描述 |

|---|---|

| Metastore | 存储Hive的元数据(表结构、分区信息、列属性等),通常依赖内嵌式数据库(如Derby)或外部RDBMS(如MySQL)。 |

| HDFS | 实际存储表数据的文件系统,数据以文件形式分块存储,默认按分区组织。 |

| Execution Engine | 负责解析HiveQL并转换为MapReduce、Tez或Spark作业,直接操作HDFS中的数据。 |

关键点:

- 数据与元数据分离:Hive的元数据存储在独立数据库(如MySQL),但业务数据直接存储在HDFS,无需通过数据库引擎管理。

- 外部表机制:通过

EXTERNAL关键字定义外部表,Hive仅管理元数据,数据文件可存放在HDFS或其他兼容文件系统中,实现数据与元数据解耦。

Hive与传统数据库的核心差异

| 对比维度 | 传统数据库(如MySQL) | Hive(不依赖数据库) |

|---|---|---|

| 数据存储 | 数据与元数据集中存储在数据库文件中 | 数据存储在HDFS,元数据存储在Metastore(可独立部署) |

| 扩展性 | 垂直扩展(单机性能瓶颈明显) | 水平扩展(依赖HDFS的分布式存储与计算) |

| 数据模型 | 结构化表,强一致性约束 | 支持结构化/半结构化数据(如JSON、AVRO),无事务约束 |

| 查询延迟 | 低延迟(毫秒级) | 高延迟(分钟级,适合批处理) |

| 更新机制 | 支持ACID事务 | 仅支持追加(Insert)和覆盖(Overwrite),无行级更新 |

典型场景:

- 数据湖构建:Hive可直接读取HDFS中的原始日志、JSON等非结构化数据,无需预先加载到数据库。

- 离线分析:通过分区(Partition)和桶(Bucket)优化大规模数据查询,例如电商用户行为分析、日志聚合。

Hive不依赖数据库的实践操作

创建外部表管理HDFS数据

CREATE EXTERNAL TABLE user_logs ( user_id STRING, action STRING, timestamp TIMESTAMP ) PARTITIONED BY (date STRING) ROW FORMAT DELIMITED FIELDS TERMINATED BY ',' LOCATION '/data/user_logs/'; -直接指向HDFS路径

- 说明:

EXTERNAL标识表数据由外部管理,删除表时不会移除HDFS中的数据。

- 说明:

动态分区与数据加载

-开启动态分区支持 SET hive.exec.dynamic.partition=true; SET hive.exec.dynamic.partition.mode=nonstrict; -从HDFS目录加载数据并自动分区 LOAD DATA INPATH '/raw_logs/' INTO TABLE user_logs PARTITION (date) ;

- 优势:数据直接从HDFS加载,无需ETL工具预处理。

通过视图关联多数据源

CREATE VIEW combined_data AS SELECT a., b.metrics FROM external_table_a a JOIN external_table_b b ON a.id = b.id;

- 说明:Hive支持跨外部表关联查询,实现多数据源联合分析。

Hive的局限性及替代方案

局限性:

- 无ACID支持:默认情况下不支持事务,需启用

transactional表并配置复杂参数。 - 实时性差:适合离线分析,实时查询需结合Impala、Spark等引擎。

- 小文件问题:大量小文件可能导致MapReduce任务效率低下,需通过合并(Combine)优化。

- 无ACID支持:默认情况下不支持事务,需启用

替代方案:

- Iceberg/Hudi:开源数据湖框架,提供ACID事务与时间旅行功能,可替代Hive管理大规模数据。

- Presto/Trino:高性能查询引擎,支持直接查询HDFS中的Hive表,适合即席分析。

FAQs

问题1:Hive完全不依赖任何数据库吗?

答:Hive的业务数据不依赖数据库,直接存储在HDFS中,但元数据存储仍需依赖数据库(如MySQL或内嵌式Derby),若需完全脱离数据库,可使用Hive的sqlite3作为轻量级Metastore,但生产环境建议配置独立数据库。

问题2:如何在Hive中实现类似数据库的“事务”功能?

答:Hive默认不支持事务,但可通过以下方式实现:

- 启用

ACID特性(需配置transactional表并设置hive.support.concurrency=true)。 - 使用

INSERT OVERWRITE代替UPDATE,通过覆盖表实现数据更新。 - 结合Kafka+Spark Streaming实现近实时数据处理,绕过