上一篇

分布式数据如何存储

- 行业动态

- 2025-05-11

- 4

分布式数据存储通过分片将 数据分散到多节点,结合副本机制提升可靠性,采用一致性哈希均衡负载,利用冗余容错应对节点故障,最终保障

分布式数据存储技术详解

在数字化时代,数据量呈指数级增长,传统集中式存储已无法满足大规模数据处理需求,分布式数据存储通过将数据分散存储在多个节点上,结合网络协作实现高效、可靠的数据管理,以下是分布式存储的核心原理、技术分类及实践方案。

分布式存储的核心目标

- 扩展性:支持PB/EB级数据存储,动态扩展节点容量。

- 高可用性:通过冗余机制避免单点故障,保障服务连续性。

- 性能优化:并行化读写操作,提升吞吐量和响应速度。

- 成本控制:利用普通硬件集群替代专用存储设备。

分布式存储架构分类

| 存储类型 | 典型特征 | 代表系统 |

|---|---|---|

| 对象存储 | 扁平化结构,无目录层级,适合海量非结构化数据 | Amazon S3、Ceph、MinIO |

| 块存储 | 提供原始存储空间,类似SAN,支持低延迟访问 | OpenEBS、Sheepdog |

| 文件存储 | 支持POSIX接口,兼容传统文件系统 | GlusterFS、MooseFS |

| 数据库分片 | 按数据特征拆分表,支持事务与查询优化 | Cassandra、CockroachDB |

关键技术实现

数据分片(Sharding)策略

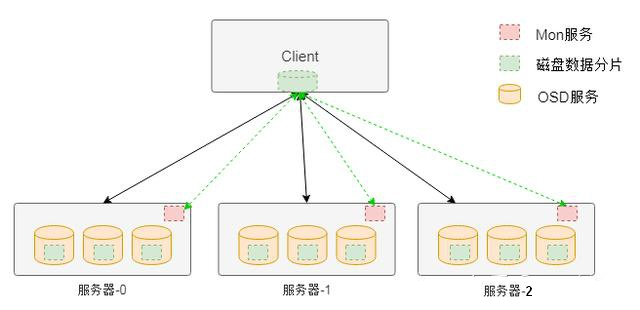

- 哈希分片:通过一致性哈希算法(如CRUSH)均匀分布数据,避免热点。

- 范围分片:按时间或ID区间划分,适合时序数据(如日志)。

- 目录分片:基于文件路径前缀分配,保留目录结构(如HDFS)。

副本与一致性模型

- 副本机制:每份数据保存多份副本(如3副本),通过心跳检测实现故障转移。

- CAP定理权衡:

- 强一致性(如Raft协议):适用于金融交易,牺牲部分分区容忍。

- 最终一致性(如DynamoDB):允许短暂数据差异,适合社交媒体。

元数据管理

- 集中式元数据:单一Master节点管理(如HDFS NameNode),存在单点瓶颈。

- 分布式元数据:采用Quorum NRW(如Ceph),通过多数派决策提升可用性。

容灾与恢复机制

数据冗余策略

- 副本冗余:简单易实现,但存储成本高(如3倍空间开销)。

- 纠删码(Erasure Coding):将数据编码为多个块,容忍部分丢失(如HDFS EC模式)。

故障检测与自愈

- 心跳机制:定期检测节点状态,触发副本重建。

- 数据校验:通过MD5/SHA哈希值验证数据完整性。

性能优化方案

| 优化方向 | 技术手段 | 效果 |

|---|---|---|

| 缓存加速 | 部署Redis/Memcached缓存热数据 | 降低90%以上读延迟 |

| 负载均衡 | 一致性哈希+虚拟节点 | 避免扩容时数据迁移风暴 |

| 压缩编码 | Zstandard/Snappy压缩 | 减少50%-70%带宽占用 |

| 索引优化 | 倒排索引+BloomFilter | 提升查询效率 |

典型应用场景与选型建议

- 互联网业务(图片/视频):对象存储(MinIO/Ceph)+ CDN加速。

- 大数据分析:HDFS/Ceph + Spark/Flink计算框架。

- 实时交易系统:NewSQL数据库(如TiDB)+ SSD高性能存储。

- 混合云环境:容器化存储(Rook/Portworx)+ 动态扩缩容。

FAQs

Q1:分布式存储与传统NAS/SAN存储有什么区别?

A1:分布式存储通过软件定义实现横向扩展,成本更低;传统SAN/NAS依赖专用硬件,扩展性差且价格昂贵,Ceph集群可由普通服务器组成,而传统存储阵列需采购高端设备。

Q2:如何根据业务需求选择分布式存储类型?

A2:优先分析数据特征:

- 非结构化数据(图片/日志)→ 对象存储(S3/Ceph)。

- 结构化事务数据(订单/支付)→ 分布式数据库(CockroachDB/TiDB)。

- 共享文件需求(开发环境)→ 文件存储(GlusterFS)。

- 冷热数据混合场景→ 结合缓存(Redis)与分层存储(Hot/Warm/Cold