hive中数据存储的位置

- 行业动态

- 2025-05-11

- 11

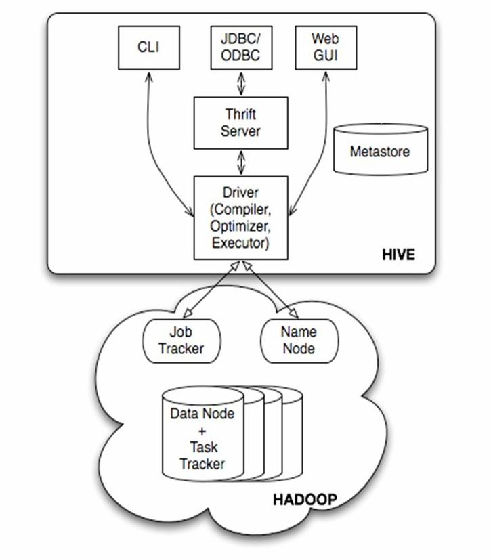

在Hive中,数据存储的位置与Hive的架构设计、表类型、存储格式以及元数据管理密切相关,Hive作为基于Hadoop的数据仓库工具,其核心数据存储依托于HDFS(Hadoop Distributed File System),但具体存储路径、文件组织形式和管理方式需要结合Hive的元数据和用户操作来综合分析,以下是关于Hive数据存储位置的详细解析:

Hive数据存储的核心位置:HDFS

Hive的所有数据均存储在HDFS中,其本质是通过抽象SQL语法将HDFS上的数据文件映射为表,并通过元数据管理数据的结构和位置,HDFS的分布式存储特性为Hive提供了高可靠性和可扩展性。

关键路径说明

| Hive对象 | 对应的HDFS路径 | 说明 |

|---|---|---|

| 数据库(Database) | /user/hive/warehouse/<database_name>.db | 每个数据库对应一个HDFS子目录,所有表数据默认存储在此目录下。 |

| 表(Table) | /user/hive/warehouse/<database_name>.db/<table_name> | 表的数据存储在数据库目录下的子目录中。 |

| 分区(Partition) | /user/hive/warehouse/<database_name>.db/<table_name>/<partition_column=value>/ | 分区表的每个分区对应一个HDFS子目录,数据按分区值分类存储。 |

| 桶(Bucket) | /user/hive/warehouse/<database_name>.db/<table_name>/<bucket_number>/ | 桶表的每个桶对应一个文件目录,数据根据哈希值分配到不同桶中。 |

数据存储格式与文件组织

Hive支持多种数据存储格式(如TextFile、SequenceFile、ORC、Parquet等),不同格式的文件在HDFS中的存储方式有所不同:

| 存储格式 | 文件组织形式 | 特点 |

|---|---|---|

| TextFile | 每行一条记录,无索引和压缩,文件后缀为.txt | 简单易读,但查询性能差,占用HDFS存储空间大。 |

| SequenceFile | 二进制序列化文件,可拆分压缩,文件后缀为.seq | 支持压缩,适合大规模数据存储,但可读性差。 |

| ORC/Parquet | 列式存储,支持压缩和投影(只读取需要的列),文件后缀为.orc或.parquet | 高效查询,节省存储空间,适合复杂分析和OLAP场景。 |

示例:表数据的文件分布

假设创建一个分区表employee,包含分区year=2023和department=IT,存储格式为ORC,则HDFS路径可能如下:

/user/hive/warehouse/default.db/employee/year=2023/department=IT/

├── 000000_0.orc

├── 000000_0.orc.index

└── _SUCCESS.orc:实际数据文件。.orc.index:索引文件,记录每条记录的偏移量。_SUCCESS:标志文件,表示分区加载成功。

表类型与数据存储位置

Hive支持内部表(Managed Table)和外部表(External Table),两者的数据存储位置管理方式不同:

| 表类型 | 数据存储位置 | 删除表时的行为 |

|---|---|---|

| 内部表(Managed) | 数据存储在Hive指定的仓库目录(如/user/hive/warehouse)内。 | 删除表时,数据和元数据一并删除。 |

| 外部表(External) | 数据存储在用户指定的HDFS路径(如/data/external_table),Hive仅管理元数据。 | 删除表时,仅删除元数据,数据保留。 |

外部表的典型用途

当数据已经存在于HDFS中,且不希望Hive管理生命周期时,可创建外部表。

CREATE EXTERNAL TABLE log_data ( ip STRING, url STRING, timeSTAmp TIMESTAMP ) STORED AS PARQUET LOCATION '/data/logs/';

此时数据存储在/data/logs/目录下,Hive仅记录元数据。

元数据存储位置

Hive的元数据(包括数据库、表结构、分区信息等)存储在关系型数据库中,默认使用内嵌的Apache Derby,但生产环境通常替换为MySQL、PostgreSQL等,元数据库的存储位置与Hive数据存储位置无关,需通过配置参数指定:

- 默认元数据库:

/var/folders/.../metastore_db(Derby)。 - 自定义元数据库:通过

hive.metastore.uris配置,<property> <name>hive.metastore.uris</name> <value>thrift://localhost:9083</value> </property>

数据导入与存储路径映射

Hive通过以下操作将数据写入HDFS:

LOAD数据:将本地文件或HDFS文件移动到表对应的目录。

LOAD DATA INPATH '/local/data.csv' INTO TABLE user_data;

数据会被移动到

/user/hive/warehouse/<database>.db/user_data/。INSERT INTO:将查询结果写入表,自动创建分区目录。

INSERT INTO TABLE sales PARTITION (year=2023, month=06) SELECT FROM source;

数据会存储在

/user/hive/warehouse/<database>.db/sales/year=2023/month=06/。动态分区插入:根据数据自动创建分区目录。

SET hive.exec.dynamic.partition=true; INSERT INTO TABLE logs PARTITION (date) SELECT FROM raw_logs;

数据按

date字段值自动生成分区目录。

特殊场景:临时表与中间数据

- 临时表(Temporary Table):数据存储在HDFS的临时目录(如

/tmp/hive/),生命周期仅限于会话或作业执行期间。 - 中间数据(如JOIN操作):Hive会将中间结果写入

/tmp/hive-<username>/目录,作业完成后自动清理。

数据存储位置的管理与优化

常见问题与解决方案

| 问题 | 原因分析 | 解决方案 |

|---|---|---|

| 数据未出现在预期HDFS路径 | 外部表路径错误;2. 分区未正确加载 | 检查LOCATION参数或重新加载分区(MSCK REPAIR TABLE)。 |

| 查询性能差(小文件过多) | 数据倾斜或未合理分区 | 使用ORC/Parquet格式、开启合并(hive.merge.mapfiles=true)、增加分区。 |

| HDFS存储空间不足 | 数据冗余或未压缩 | 启用压缩(ORC支持Snappy压缩)、删除过期分区。 |

优化建议

- 分区策略:按业务维度(如时间、地域)分区,减少全表扫描。

- 文件格式:优先使用

ORC或Parquet,支持列式存储和压缩。 - 合并小文件:通过

hive.merge.size.per.task参数合并小文件,减少NameNode压力。

FAQs

问题1:如何查看Hive表的数据存储路径?

解答:

- 使用

DESCRIBE FORMATTED <table_name>命令,查看Location字段。 - 直接访问HDFS目录,

hdfs dfs -ls /user/hive/warehouse/default.db/employee/

问题2:删除外部表后,数据是否会被删除?

解答:

- 外部表的元数据会被删除,但数据仍保留在用户指定的HDFS路径中。

- 如果需要删除数据,需手动执行

hdfs dfs -rm -r <path>。