分布式存储系统优化

- 行业动态

- 2025-05-13

- 1

分布式存储系统优化核心策略与实践

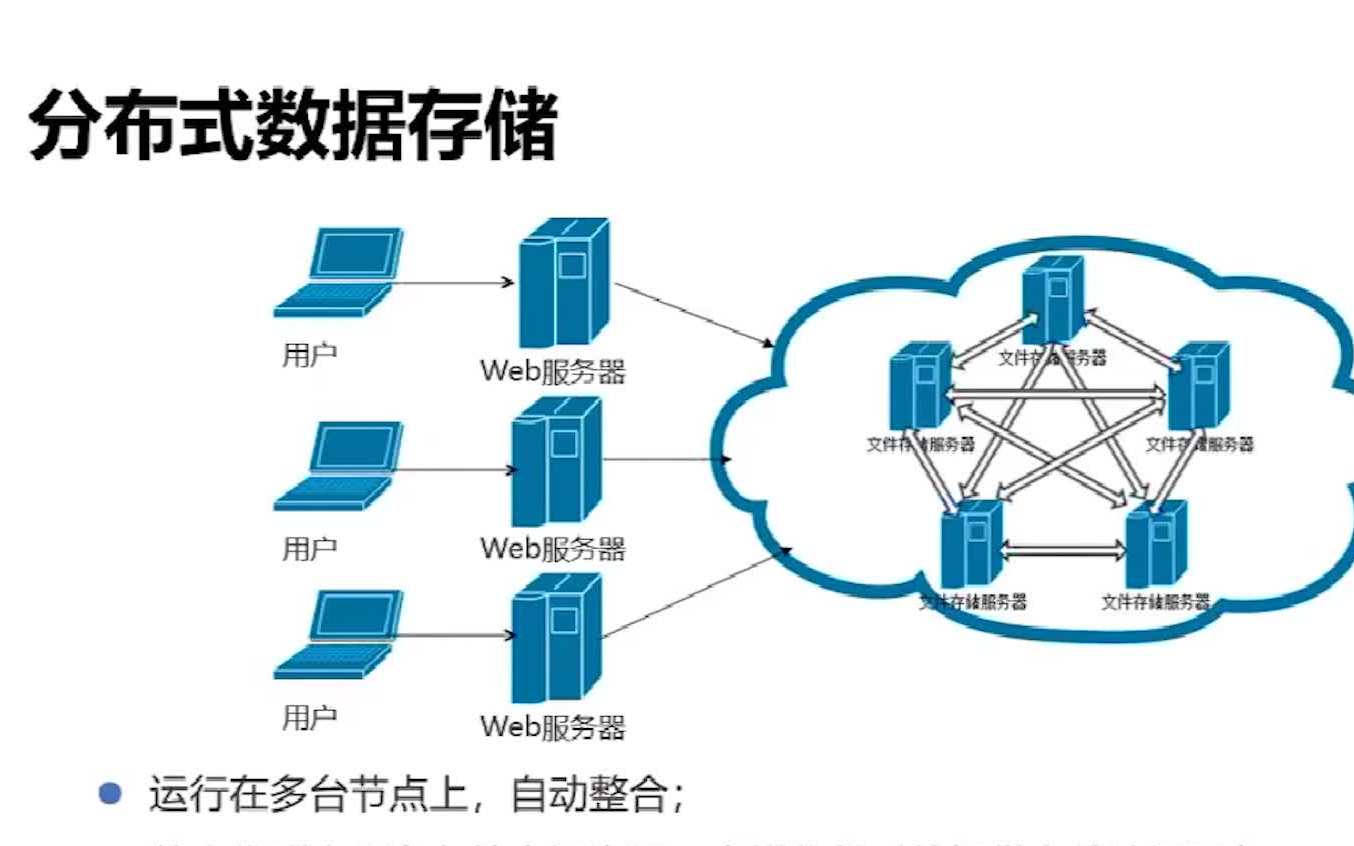

分布式存储系统作为现代云计算、大数据和人工智能基础设施的核心组件,其性能、可靠性和扩展性直接影响上层应用的运行效率,本文将从架构设计、数据分布策略、元数据管理、网络优化、故障恢复机制、性能监控等维度,系统阐述分布式存储系统的优化方法,并结合典型场景提供实践建议。

架构设计优化

| 优化方向 | 传统方案 | 优化方案 | 适用场景 |

|---|---|---|---|

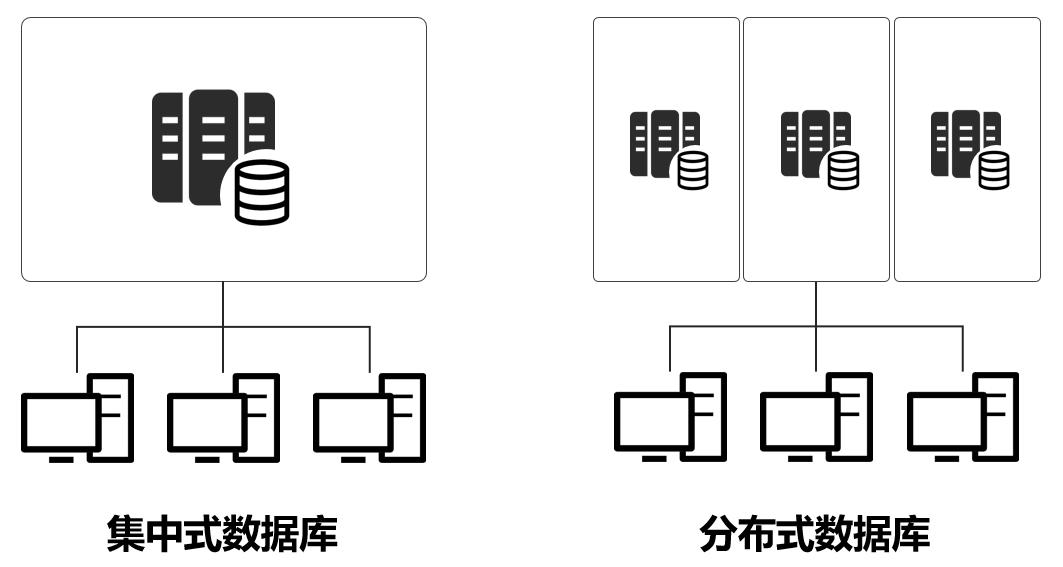

| 存储节点扩展性 | 垂直扩展(单节点扩容) | 水平扩展(多节点分布式集群) | 海量数据存储(PB级+) |

| 元数据管理 | 中心化元数据服务器 | 分布式元数据服务(如Raft协议) | 高并发读写场景 |

| 数据冗余策略 | 固定副本数(3副本) | 动态副本+纠删码混合 | 成本敏感型业务 |

| 网络通信 | 同步阻塞式RPC | 异步流式通信(如gRPC) | 低延迟要求场景 |

关键点说明:

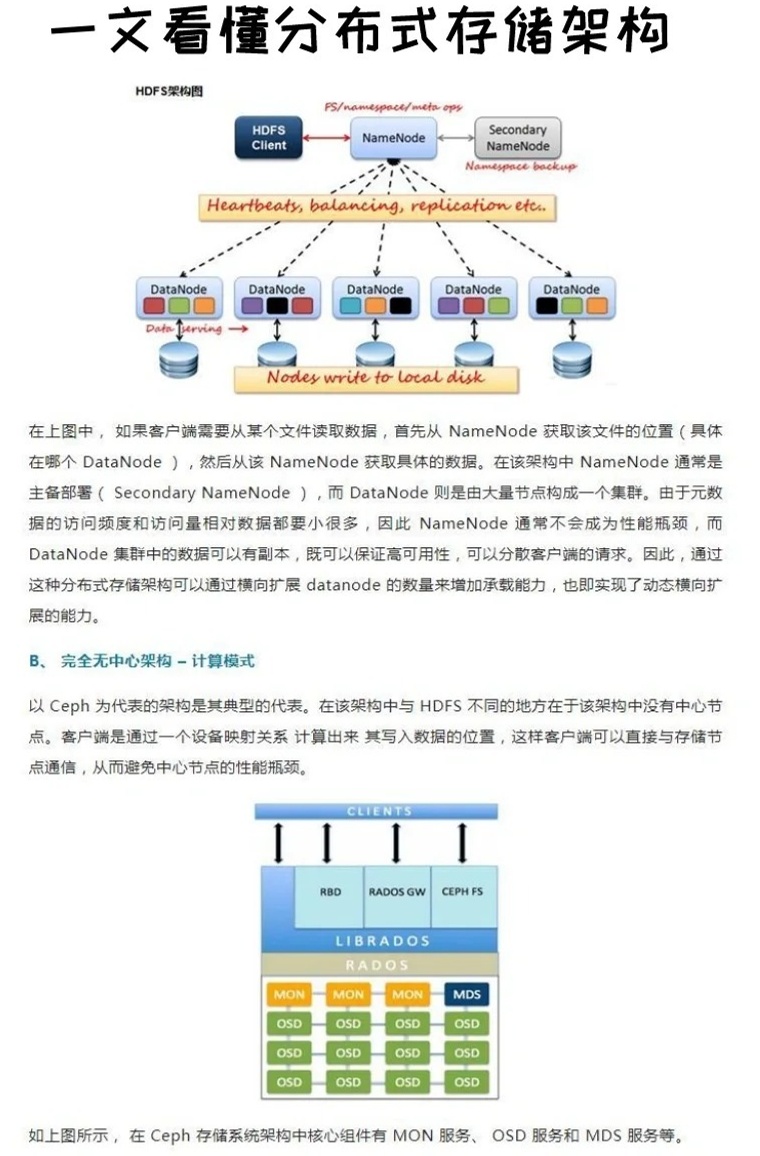

- 无共享架构:通过去中心化设计避免单点瓶颈,例如Ceph的CRUSH算法实现数据均匀分布。

- 计算存储分离:将热数据与温冷数据分层存储(如SSD+HDD组合),提升资源利用率。

- 容器化部署:使用Kubernetes管理存储节点,支持弹性扩缩容和故障自愈。

数据分布与负载均衡

数据分布算法直接决定存储系统的负载均衡性和扩展性,常见策略对比如下:

| 算法类型 | 实现原理 | 优点 | 缺点 | 典型应用 |

|---|---|---|---|---|

| 哈希取模 | 按节点数量取模分配数据 | 实现简单 | 节点增减导致数据重构 | 早期分布式文件系统 |

| 一致性哈希 | 环形哈希空间映射 | 减少数据迁移 | 仍存在负载不均 | Redis Cluster、Cassandra |

| 虚拟节点 | 每个物理节点对应多个逻辑节点 | 优化负载均衡 | 增加映射复杂度 | Ceph、GlusterFS |

| 表亲关系 | 数据块与节点亲缘性绑定 | 降低网络开销 | 依赖预设规则 | 阿里云OSS |

优化实践:

- 引入动态负载感知机制,实时监测节点IOPS、带宽利用率,触发数据迁移(如TiDB的Region调度)。

- 采用混合粒度分区:对小文件采用合并存储(如HDFS的Block抽象),大文件拆分为粗粒度分片。

- 实现数据亲和性调度,将高频访问数据优先分配至低延迟节点(如同城双活架构)。

元数据管理优化

元数据服务的性能瓶颈常成为分布式存储系统的天花板,优化需从以下维度入手:

| 优化措施 | 技术实现 | 收益 | 风险 |

|---|---|---|---|

| 分布式元数据引擎 | 基于Raft/Paxos协议实现多副本同步 | 提升可用性 | 增加协议开销 |

| 缓存分层 | 本地内存缓存+二级索引(如LSM树) | 降低读延迟 | 内存消耗大 |

| 批量处理 | 合并元数据操作(如CoW写时复制) | 减少锁竞争 | 增加延迟峰值 |

| 轻量化协议 | 使用Protobuf替代JSON序列化 | 降低解析开销 | 兼容性要求高 |

案例分析:

Ceph的Monitor集群通过Paxos协议保证元数据一致性,但集群规模受限(7个Monitor),为突破此限制,可引入:

- 元数据分片:按目录层级或时间范围划分元数据分区

- 客户端缓存:在应用侧缓存目录结构(如Amazon S3的客户端SDK缓存)

- 异步同步:允许临时一致性差异(最终一致性模型)

网络传输优化

存储节点间的网络通信效率直接影响系统吞吐量,优化手段包括:

协议层优化

- 使用QUIC协议替代TCP,减少连接建立耗时(Google Spanner实测可降低30%延迟)

- 启用RDMA(远程直接内存访问),绕过内核协议栈(适用于高性能计算场景)

- 定制应用层协议,例如Facebook的BlobStore协议支持批量操作合并

数据压缩与编码

| 压缩算法 | 适用场景 | 性能损耗 | 压缩率 |

|———-|———-|———-|——–|

| LZ4 | 实时日志流 | 10%-15% | 2:1 |

| Zstd | 通用数据压缩 | 20%-30% | 3:1 |

| Snappy | 小文件快速压缩 | 5%-10% | 1.5:1 |跨数据中心优化

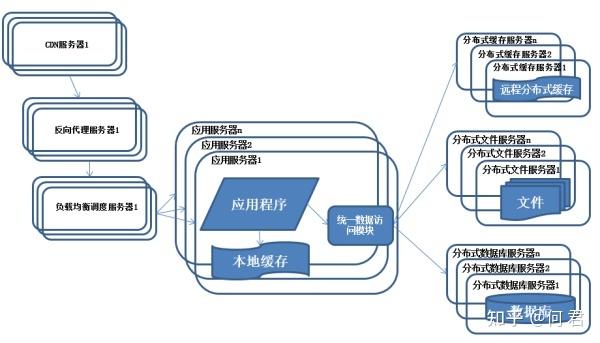

- 部署边缘缓存节点,就近服务热点数据(如CDN加速)

- 采用带宽预约机制,错峰传输非实时数据(阿里云对象存储OSS的智能调度)

- 使用Erasure Coding替代副本传输,减少跨域带宽消耗(微软Azure Blob Storage)

故障恢复与容灾设计

分布式存储系统的可靠性优化需兼顾数据持久性和服务连续性:

| 故障类型 | 传统方案 | 优化方案 | RTO/RPO目标 |

|---|---|---|---|

| 节点故障 | 固定3副本 | 动态副本+EC纠删码 | RTO<60s, RPO=0 |

| 网络分区 | 多数派投票 | Quorum Read优化 | 维持读写可用性 |

| 数据损坏 | 定期全盘校验 | 实时校验和+背景修复 | 秒级检测,分钟级修复 |

| 机房灾难 | 异地冷备 | 多活架构+异步复制 | RPO<1min, RTO<5min |

关键技术:

- 自愈机制:通过Bitrot校验(如Google Wubble)自动修复静默数据错误

- 仲裁机制:引入Quorum EPAX(扩展多数决协议)处理网络分区

- 混沌工程:模拟节点宕机、磁盘坏道、网络抖动等故障进行韧性测试

性能监控与调优工具

构建可视化监控体系是持续优化的基础:

核心监控指标

- 存储层:IOPS、吞吐量、延迟、磁盘利用率

- 网络层:带宽使用率、P99/P95延迟、重传率

- 元数据层:QPS、锁等待时间、缓存命中率

智能调优工具

| 工具类型 | 功能示例 | 适用场景 |

|———-|———-|———-|

| 自动参数调优 | 基于强化学习的副本数动态调整 | 云存储服务 |

| 热点检测 | DHT指纹识别高频访问Key | 短视频平台 |

| 容量预测 | 时间序列分析预估存储需求 | 日志归档系统 |开源方案推荐

- Prometheus+Grafana:实时指标采集与可视化

- Elassandra:集成Elasticsearch与Cassandra的监控方案

- Dragonfly:字节跳动开源的高性能传输框架

FAQs

Q1:如何选择合适的数据分布策略?

A:需综合考虑数据规模、访问模式和硬件成本:

- 小规模集群(<50节点)可选用一致性哈希+虚拟节点

- 写密集型场景优先保证分区均匀性(如CRUSH算法)

- 读密集型场景可引入数据亲和性调度(如表亲关系)

- 成本敏感型业务采用EC纠删码替代副本(如AWS S3 Glacier)

Q2:如何平衡存储系统一致性与性能?

A:根据业务容忍度分层设计:

- 强一致性需求(如金融交易):采用Raft协议+多数派写入,牺牲部分性能

- 最终一致性场景(如图片存储):使用版本向量+异步复制,提升吞吐量

- 混合策略:对元数据保证强一致,对用户数据采用Quorum NWR(Write Quorum/Read Qu