上一篇

hadoop的mysql数据库吗

- 行业动态

- 2025-05-13

- 9

Hadoop自身不依赖MySQL,但生态组件如Hive可用MySQL存元数据,Sqoop可集成MySQL

Hadoop与MySQL数据库的关联与实践解析

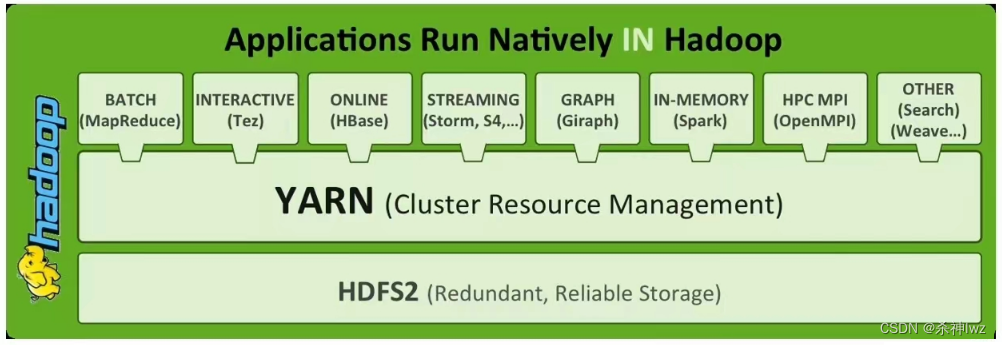

在大数据技术生态中,Hadoop与MySQL常被共同提及,但两者的定位和功能存在显著差异,本文将从技术架构、数据交互、应用场景等角度,系统解析Hadoop与MySQL的关系,并探讨实际集成方案。

核心概念对比

| 特性 | Hadoop | MySQL |

|---|---|---|

| 架构类型 | 分布式计算框架(HDFS+YARN+MapReduce) | 集中式关系型数据库 |

| 数据模型 | 非结构化/半结构化数据 | 结构化二维表 |

| 扩展方式 | 横向扩展(添加节点) | 纵向扩展(硬件升级) |

| 事务支持 | 最终一致性(非ACID) | 强ACID事务 |

| 典型场景 | 批处理、实时流处理、数据仓库 | OLTP在线交易、小规模数据分析 |

Hadoop生态中的MySQL应用场景

虽然Hadoop本身不直接依赖MySQL,但在其生态系统中存在多种集成场景:

Hive元数据存储

- Hive默认使用内嵌式Derby数据库存储元数据,生产环境中可配置MySQL作为元数据库

- 优势:提升元数据管理性能,支持多客户端并发访问

- 配置示例:

CREATE DATABASE hive_meta; GRANT ALL ON hive_meta. TO 'hiveuser'@'%';

Sqoop数据同步

Apache Sqoop是专门用于MySQL与Hadoop(HDFS/Hive/HBase)的数据桥梁

典型工作流:

# 全量导入 sqoop import --connect jdbc:mysql://db-server/testdb --table users --target-dir /user/hive/warehouse/users # 增量导出 sqoop export --connect jdbc:mysql://db-server/testdb --table sales_log --export-dir /stage/sales_delta

HBase配置存储

- HBase可使用MySQL存储namespace/table等配置信息

- 需启用

hbase-site.xml中的hbase.zookeeper.quorum配置项

数据交互实践方案

| 场景 | 工具/技术 | 实现要点 |

|---|---|---|

| MySQL→HDFS批量导入 | Sqoop/Flume | 配置JDBC连接,处理NULL值转换,设置并行度(–num-mappers) |

| HDFS→MySQL实时同步 | Kafka+SinkConnector | 通过CDC工具捕获MySQL变更日志,Kafka传输后写入目标库 |

| 分析型查询加速 | Hive+MySQL UDF | 创建自定义函数调用MySQL存储过程,实现复杂业务逻辑 |

| 混合存储架构 | Impala+Kudu | 热数据存MySQL,温冷数据存HDFS,通过Impala统一查询 |

典型案例:电商用户行为分析

- 实时路径:MySQL存储近期订单(热数据),Kafka收集浏览行为

- 批处理路径:每日用Sqoop将MySQL订单数据导入Hive,执行用户画像计算

- 查询层:通过Hive SQL联合查询HDFS历史数据与MySQL实时数据

关键差异与选型建议

| 维度 | Hadoop | MySQL |

|---|---|---|

| 数据规模 | PB级分布式存储 | GB级集中存储 |

| 延迟要求 | 分钟级批处理 | 毫秒级实时响应 |

| 更新频率 | 批量追加/覆盖 | 高频DML操作 |

| 成本模型 | 廉价PC服务器集群 | 专用硬件+授权费用 |

选型策略:

- 在线交易系统 → MySQL(ACID事务保障)

- 历史日志分析 → Hadoop(高吞吐+低成本)

- 混合架构 → MySQL+Kafka+Hadoop(热冷数据分层)

常见问题与解决方案

Q1:Sqoop导入大表时内存溢出

A:调整--split-by字段为索引列,设置--num-mappers为集群可用节点数,启用--compress压缩传输

Q2:Hive元数据存储MySQL的性能瓶颈

A:创建索引优化查询,配置hive.metastore.warehouse.dir指向SSD存储,启用连接池(maximum-pool-size=50)

FAQs

Q:Hadoop能否完全替代MySQL?

A:不能,Hadoop擅长非结构化数据处理和离线分析,而MySQL在OLTP场景具有不可替代的事务一致性和低延迟优势,建议采用混合架构,通过数据分层实现优势互补。

Q:如何保障MySQL与Hadoop的数据一致性?

A:1) 使用Sqoop增量导入配合MySQL binlog;2) 采用双写策略(应用程序同时写入MySQL和Kafka);3) 定期执行数据校验脚本比对