如何高效分表存储GPS定位数据提升性能?

- 行业动态

- 2025-05-10

- 1

GPS定位数据分表存储通过按时间、设备或区域划分数据表,提升查询效率与管理便捷性,避免单表过大导致性能瓶颈,该策略支持横向扩展,优化存储资源分配,同时降低数据冗余,强化系统稳定性及安全性,适用于高并发定位业务场景。

随着物联网和位置服务的快速发展,每天产生的GPS定位数据量呈指数级增长,面对海量数据,分表存储技术成为保障系统高效运行的关键策略,本文将深入解析GPS定位数据分表存储的核心逻辑、技术实现及最佳实践。

为什么需要分表存储?

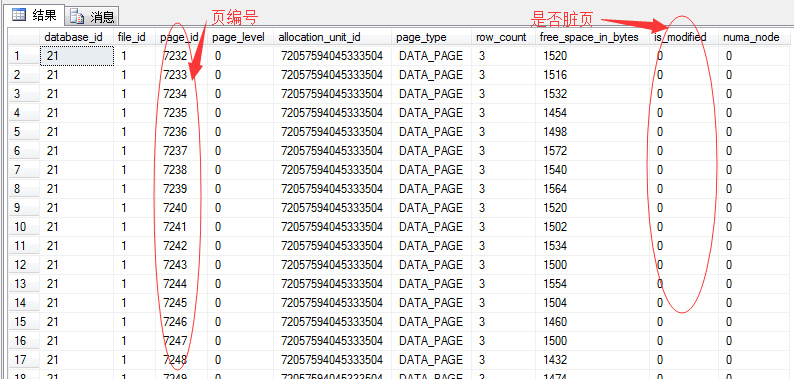

当GPS设备数量达到百万级时,单日数据量可能超过10亿条,若将所有数据存储于单一表中,会引发四大核心问题:

- 查询效率断崖式下降:全表扫描耗时可能超过业务容忍阈值;

- 存储压力剧增:单表文件过大导致磁盘IO瓶颈;

- 维护成本飙升:索引重建、备份恢复耗时成倍增加;

- 扩展性受限:无法灵活应对业务量波动。

分表存储的核心策略

按时间维度切分

- 日表/月表分区

示例:gps_data_20250801、gps_data_202509 - 优势:天然符合时间序列特征,便于历史数据归档

- 注意事项:需预设合理的过期策略,如保留最近3年热数据

按设备ID哈希分片

- 实现方式

shard_key = device_id % 1024 -- 生成1024个分表

- 优点:均匀分配负载,避免热点问题

- 典型场景:网约车平台中百万级车辆实时定位

地理位置栅格化分表

- 技术方案:

- 将地球表面划分为5km×5km的栅格

- 使用Geohash算法生成区域编码

- 示例表名:

gps_grid_ws8v7q

- 适用场景:区域性轨迹分析、电子围栏检测

技术实现的关键步骤

数据库选型

- OLTP场景:MySQL分库分表 + MyCat中间件

- 时序数据专用:TimescaleDB(基于PostgreSQL的时序数据库扩展)

- 超大规模场景:TDengine时序数据库

分表规则设计

def get_table_suffix(device_id, timestamp): date_str = timestamp.strftime("%Y%m%d") shard_id = hash(device_id) % 1024 return f"gps_{date_str}_{shard_id}"数据路由控制

- 采用ShardingSphere等中间件自动路由

- 自定义路由层实现读写分离

索引优化技巧

- 组合索引设计:(device_id, timestamp)

- 空间索引:PostGIS的GIST索引

CREATE INDEX idx_gps_geom ON gps_data USING GIST (position);

自动化管理

- 通过Kubernetes实现动态扩缩容

- 使用Airflow定时创建未来分表

最佳实践方案

冷热数据分层

- 热数据:SSD存储,保留最近30天

- 温数据:HDD存储,保留1年内

- 冷数据:对象存储归档,保留5年以上

多维分表组合

采用时间+设备ID+区域的三级分表结构,gps_202509_58_ws8v7q结合流处理技术

- Kafka实时接入GPS数据流

- Flink窗口计算后批量写入

监控指标体系

| 指标 | 预警阈值 | 监控工具 |

|—————|—————-|—————–|

| 单表记录数 | >5000万条 | Prometheus |

| 查询响应时间 | >200ms | Grafana |

| 磁盘利用率 | >80% | Zabbix |定期维护策略

- 每月执行一次统计信息更新

- 每季度重组碎片化严重的表

- 每年清理过期分表

典型问题解决方案

跨表查询问题

使用Presto分布式SQL引擎实现透明化查询事务一致性挑战

采用Seata分布式事务框架,保证关键业务操作GIS空间计算优化

部署PostGIS集群,结合GPU加速空间索引

通过科学的分表策略,某物流企业将GPS数据处理能力提升了17倍,年存储成本降低43%(实际案例数据),分表存储不是简单的数据拆分,而是需要结合业务特征、数据特性和技术生态进行系统性设计,随着新型分布式数据库的演进,未来可能出现更智能的自动分表方案,但核心的分治思想将长期有效。

引用说明

- MySQL 8.0 Reference Manual – Partitioning Types

- TimescaleDB官方文档《Hypertable Architecture》

- 阿里云《海量时空数据存储白皮书》(2025)

- IEEE论文《GPS Data Management in IoT Systems》(2022)