分布式存储系统中的data

- 行业动态

- 2025-05-14

- 5

分布式存储系统中,数据通过分片、复制实现扩展与容错,采用一致性哈希均衡负载,依赖CAP定理权衡一致性、可用性与分区容错,冗余机制保障数据可靠,需应对网络

分布式存储系统中的数据管理与优化

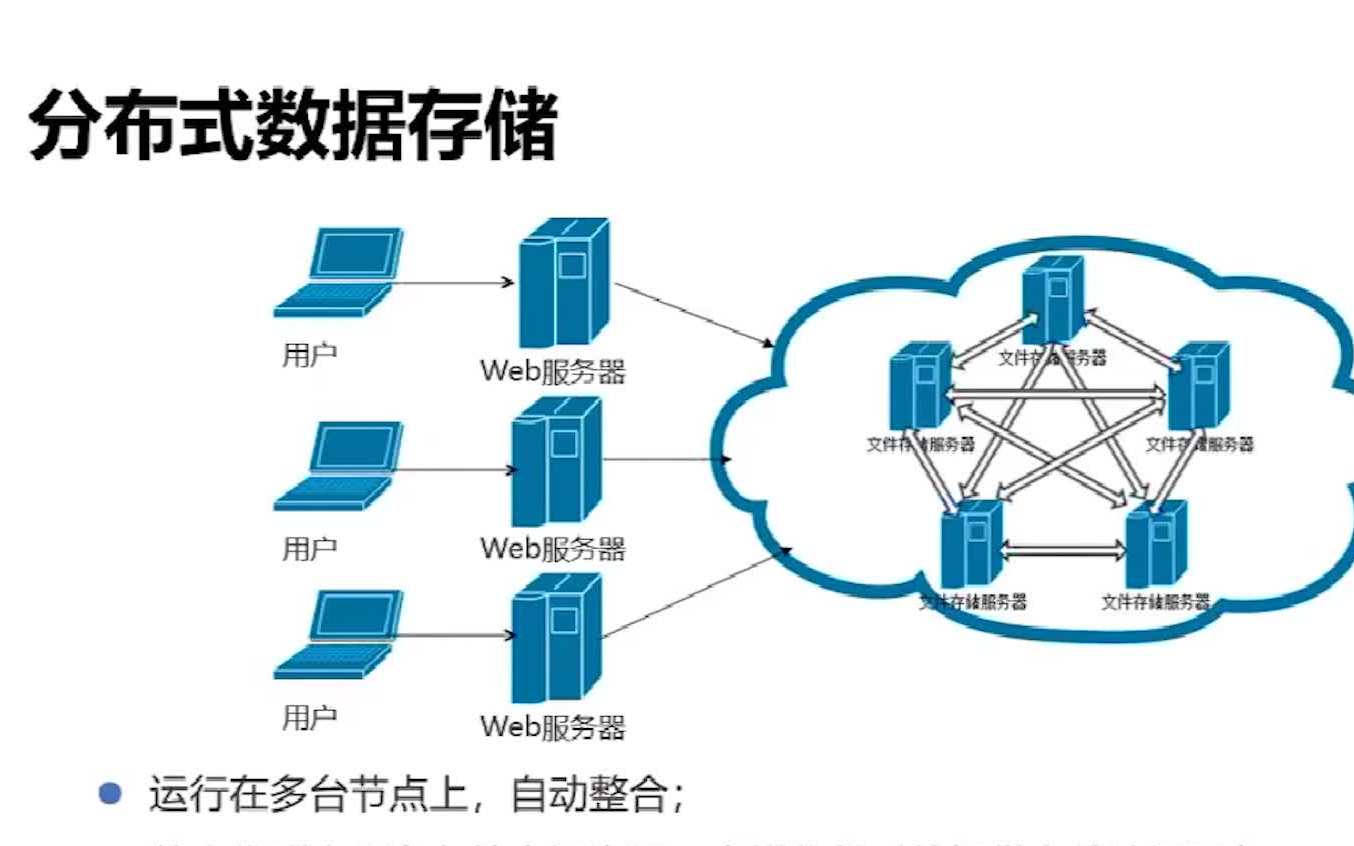

分布式存储系统通过将数据分散存储在多个节点上,实现高可用性、可扩展性和高性能,数据作为系统的核心对象,其管理策略直接影响系统的可靠性、效率和成本,以下从数据生命周期、存储模型、一致性保障、容错机制、编码优化及访问性能等角度,详细分析分布式存储系统中的数据管理逻辑。

数据生命周期管理

在分布式存储系统中,数据从生成到消亡的全生命周期通常包括以下阶段:

| 阶段 | 核心操作 | 目标 |

|---|---|---|

| 数据写入 | 分片(Sharding)、编码(Encoding)、副本分配(Replication) | 保证数据冗余与持久化 |

| 数据存储 | 物理块存储、元数据管理、冷热数据分层 | 优化存储资源利用率 |

| 数据访问 | 路由定位、缓存加速、负载均衡 | 提升读写性能 |

| 数据维护 | 副本同步、数据修复、均衡迁移 | 确保系统一致性与稳定性 |

| 数据删除 | 惰性清除(Lazy Deletion)、存储回收 | 减少资源浪费 |

数据写入与分片策略

- 哈希分片(Hash Sharding):通过哈希函数将数据均匀分布到不同节点,适用于无明确顺序的随机访问场景(如对象存储)。

- 范围分片(Range Sharding):按数据键的范围划分分片,适合范围查询(如时间序列数据库)。

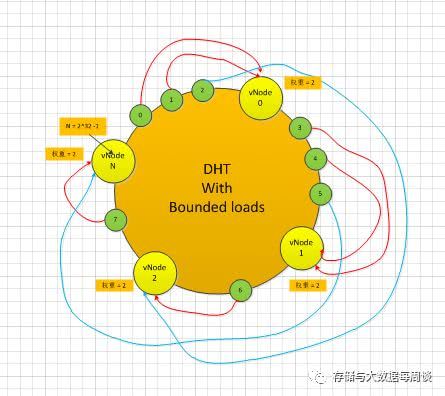

- 一致性哈希(Consistent Hashing):解决节点动态增减导致的分片失衡问题,常用于P2P网络(如BitTorrent)。

数据编码与冗余

- 副本机制(Replication):通过多份副本(如3副本)保证数据可用性,但存储成本较高(例如HDFS默认3副本)。

- 纠删码(Erasure Coding):将数据分割为多个块并生成校验块,存储效率比副本更高(如CEPH的CRUSH算法支持EC)。

- 混合策略:热数据用副本(低延迟),冷数据用纠删码(低成本),例如Amazon S3的存储层级设计。

存储模型与数据分布

分布式存储系统的架构设计直接影响数据分布方式,常见模型包括:

| 模型类型 | 特点 | 适用场景 |

|---|---|---|

| 集中式元数据 | 单一元数据节点管理全局元数据(如文件路径、权限),数据节点负责存储 | 小规模集群(如传统NAS) |

| 去中心化元数据 | 元数据分散存储,通过共识协议(如Raft)保证一致性 | 大规模集群(如Ceph、GlusterFS) |

| 对象存储 | 数据以扁平化对象形式存储,元数据与数据分离(如Amazon S3) | 海量非结构化数据 |

| 日志存储 | 数据按时间顺序追加写入,支持高吞吐(如Kafka、Elasticsearch) | 实时数据分析 |

数据分布示例:Ceph的CRUSH算法

Ceph通过CRUSH(Controlled Replication Under Scalable Hashing)算法实现数据分布,支持:

- 权重分配:根据节点性能动态调整数据分布比例。

- 故障域隔离:避免副本落在同一机架或数据中心。

- 动态扩容:新增节点时仅需迁移少量数据。

数据一致性与容错机制

分布式系统中,数据一致性与可用性需权衡(CAP定理),常见策略包括:

强一致性 vs. 最终一致性

- 强一致性:所有副本数据实时同步(如ZooKeeper的Zab协议),适用于金融交易等场景。

- 最终一致性:允许短暂不一致,通过异步复制提升性能(如DynamoDB的Quorum机制)。

容错与数据修复

- 副本失效检测:通过心跳机制(如HDFS的DataNode心跳)或CRUSH地图感知节点故障。

- 自动修复:触发新副本创建或纠删码恢复(如RAID 6的双校验块重建)。

脑裂问题处理

当网络分区导致节点出现“双主”冲突时,需依赖仲裁机制(如ETCD的多数派选举)或版本向量(Vector Clocks)解决冲突。

数据编码与存储优化

为降低存储成本并提升可靠性,数据编码技术至关重要:

| 编码方式 | 原理 | 优缺点 |

|---|---|---|

| Reed-Solomon | 将数据分为k块,生成n-k校验块 | 存储效率高,但计算复杂度高(如HDFS的EC模式) |

| LDPC(低密度奇偶校验码) | 基于稀疏图的校验码 | 适合大规模分布式存储(如Windows Azure) |

| 重复数据删除(Deduplication) | 消除冗余数据块 | 节省空间,但增加元数据管理开销 |

冷热数据分层示例

- 热数据:高频访问的数据(如电商订单),存储于SSD或内存,采用副本机制。

- 冷数据:低频访问的数据(如备份日志),存储于HDD或蓝光存储,采用纠删码。

数据访问性能优化

缓存加速

- 客户端缓存:本地暂存常用数据(如Redis的Client-Side Caching)。

- 边缘缓存:在CDN节点或代理服务器缓存热门数据(如Cloudflare的Edge Cache)。

索引优化

- 倒排索引:加速文本搜索(如Elasticsearch的Lucene索引)。

- Bloom过滤器:快速判断数据是否存在(如Cassandra的SSTable索引)。

负载均衡策略

- 请求路由:通过DNS轮询或一致性哈希分散请求压力。

- 动态调度:根据节点负载实时调整数据流向(如Kubernetes的HPA自动扩缩容)。

典型分布式存储系统对比

| 系统 | 数据模型 | 一致性级别 | 容错机制 | 适用场景 |

|---|---|---|---|---|

| HDFS | 文件系统 | 强一致性(写入) | 3副本 + 心跳检测 | 大数据分析(Hadoop生态) |

| Ceph | 对象/块存储 | 最终一致性 | CRUSH + EC | 云存储基础设施 |

| Cassandra | 列式数据库 | 可调一致性 | Quorum + Gossip协议 | 高并发写入(社交应用) |

| DynamoDB | 键值存储 | 最终一致性 | VNode + Anti-entropy | 互联网服务(AWS) |

FAQs

Q1:分布式存储系统如何平衡数据一致性与可用性?

A1:根据业务需求选择策略:

- 强一致性:使用Paxos/Raft协议(如ZooKeeper),牺牲部分可用性。

- 最终一致性:采用Quorum机制(如DynamoDB),允许短暂延迟但提升吞吐量。

- 混合策略:关键操作强一致(如支付),非关键操作最终一致(如日志)。

Q2:纠删码(Erasure Coding)为什么比副本机制更节省存储?

A2:副本机制需存储N份完整数据(如3副本存储300%数据),而纠删码将数据分为k块并生成n-k校验块,总存储量为(k+m)/k倍(例如k=4, m=2时存储量为150%),纠删码支持并行修复(仅需部分块即可恢复),