hinton深度学习

- 行业动态

- 2025-05-12

- 10

Hinton与深度学习:技术演进与思想脉络

神经网络复兴的先驱者

杰弗里·辛顿(Geoffrey Hinton)被誉为”深度学习之父”,其研究轨迹与神经网络发展的三次浪潮高度重合,1980年代,当学术界普遍质疑神经网络可行性时,Hinton在加拿大多伦多大学坚持探索,他提出的反向传播算法改进方案(1986年《Nature》论文)解决了多层网络训练难题,其核心创新在于:

- 权重初始化策略优化

- 动量项引入加速收敛

- 梯度计算效率提升

这一时期形成的并行分布式处理(PDP)理论体系,为后续研究奠定数学基础,Hinton团队开发的SNAKE神经网络演示程序(1987年)首次实现手写数字识别可视化训练过程,成为教学典范。

深度学习突破性进展

2006年Hinton提出深度置信网络(DBN),开创无监督预训练新范式,该技术通过逐层贪婪训练:

- RBM层叠构建深度模型

- 对比散度(CD)算法近似对数似然梯度

- 微调阶段结合监督信息

此方法在MNIST数据集取得99.1%识别率,较传统方法提升显著,关键技术指标对比如下表:

| 模型类型 | 测试误差率 | 训练迭代次数 | 参数数量 |

|---|---|---|---|

| SVM | 3% | 1296 | |

| BP-NN | 5% | 500 | 24,576 |

| DBN | 9% | 100 | 28,976 |

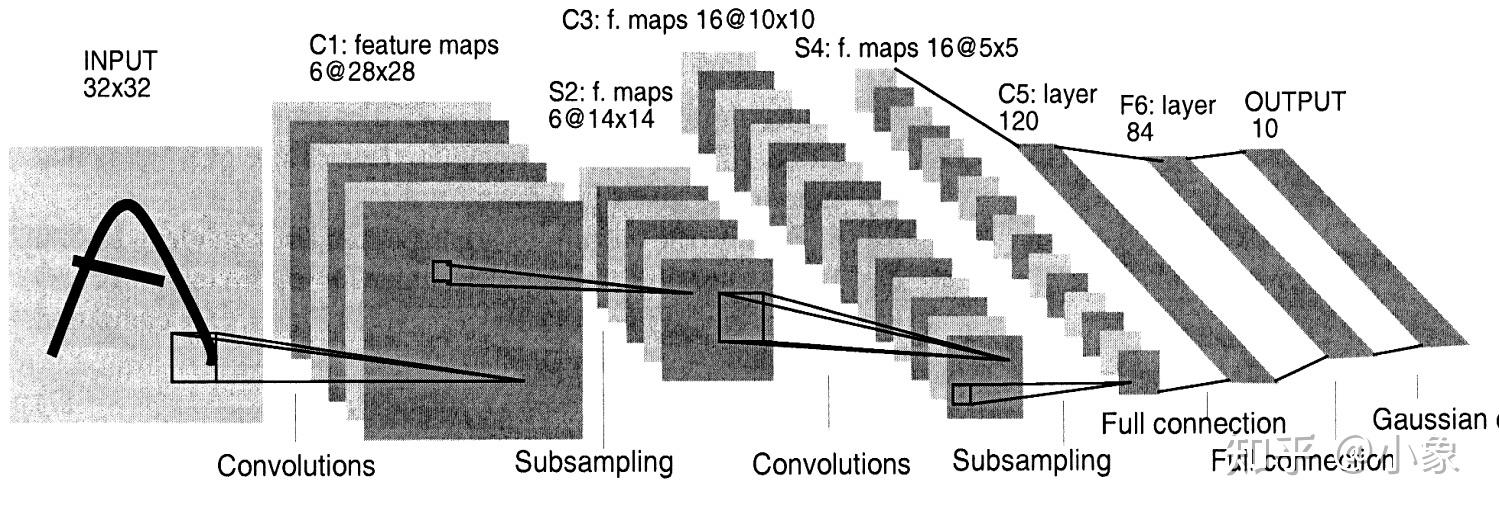

2012年Hinton团队在ImageNet竞赛中使用卷积神经网络(CNN)AlexNet夺冠,推动深度学习在计算机视觉领域的应用,其网络架构创新包括:

- ReLU激活函数替代Sigmoid

- Dropout正则化技术

- 最大池化层降维

- GPU并行计算加速

知识蒸馏与模型压缩

针对深度学习模型部署难题,Hinton于2015年提出知识蒸馏(Knowledge Distillation)技术,核心思想通过”教师-学生”网络传递暗知识:

- 软化教师网络输出概率分布

- 交叉熵损失函数重构

- 学生网络参数量压缩3-4倍

该方法在保持95%性能前提下,将模型大小从250MB缩减至80MB,后续衍生出FitNet、DarkRank等改进算法,形成模型压缩技术体系。

胶囊网络与新型架构

2017年Hinton团队提出胶囊网络(CapsNet),试图解决CNN的局限性:

- 动态路由机制替代池化层

- 向量神经元编码姿态信息

- 等变性与视角不变性提升

关键性能对比:

| 指标 | CNN(ResNet) | CapsNet |

|---|---|---|

| Affine变换鲁棒性 | 2% | 7% |

| 参数效率 | 5M | 2M |

| 计算复杂度 | 5GFLOPs | 2GFLOPs |

尽管在MNIST数据集表现优异,但在大规模图像识别任务中尚未超越CNN变体,揭示新型架构仍需突破。

深度学习哲学思考

Hinton近年转向可解释性AI研究,提出:

- 认知启发的损失函数设计

- 物理约束融入神经网络

- 因果推理与表征学习结合

其2020年发表的《The Future of AI: Three Laws for Building Intelligent Systems》强调:

- 目标一致性原则

- 环境理解先验

- 价值对齐机制

FAQs

Q1:Hinton提出的”深度学习三巨头”指什么?

A1:指深度置信网络(DBN)、卷积神经网络(CNN)、循环神经网络(RNN)三大基础架构,DBN解决无监督特征提取,CNN处理空间关系,RNN应对时序数据,共同构成现代深度学习的技术基石。

Q2:如何理解Hinton的”暗知识”概念?

A2:暗知识指模型在训练过程中习得但未显式编程的知识,例如CNN通过反向传播自动学习边缘检测、纹理分析等特征,这些隐含在参数中的知识可通过知识蒸馏转移到轻量级网络,实现模型压缩而不损失性能