上一篇

hadoop按位存储

- 行业动态

- 2025-05-11

- 9

Hadoop采用分布式文件系统(HDFS)实现按块存储,默认块大小128MB,数据分块后冗余存储于多节点,通过副本机制保障高可用性与容错,支撑PB

Hadoop按位存储机制解析与优化策略

Hadoop作为分布式大数据处理框架,其存储系统(HDFS)的设计核心目标是平衡存储效率、可靠性和扩展性,按位存储并非Hadoop的原生概念,但通过数据压缩、编码优化、存储格式选择等技术,Hadoop可以实现接近“按位存储”的高效空间利用率,以下从原理、实现机制、优化策略及应用场景展开分析。

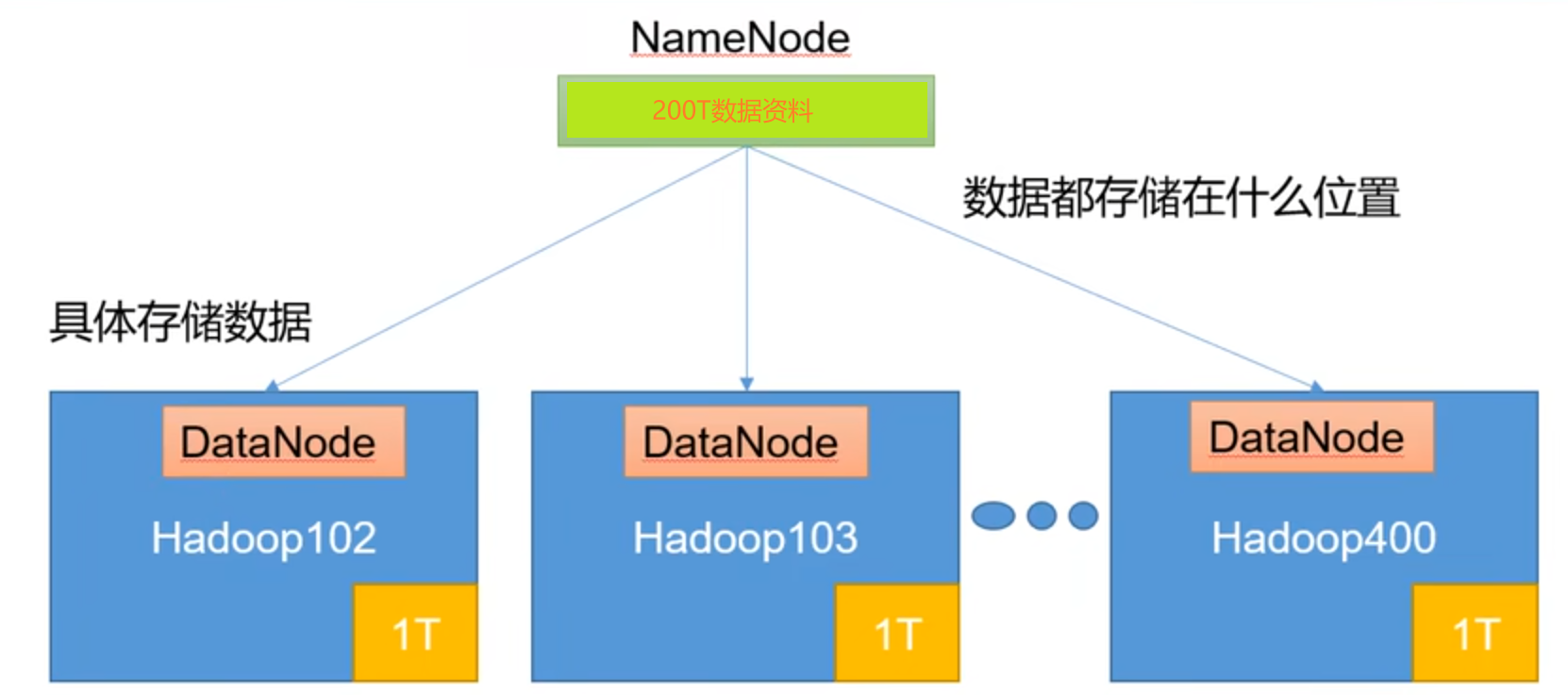

Hadoop存储架构与按位存储的关系

Hadoop的存储核心是HDFS(Hadoop Distributed File System),其数据以块(Block)为单位进行分布式存储,默认块大小为128MB(可配置),每个块会被复制到多个节点(默认3副本)以保证容错性,按位存储的优化目标在于:

- 减少原始数据体积:通过压缩、编码等技术降低数据占用的物理存储空间。

- 提升存储密度:优化数据块的排列和索引方式,减少元数据开销。

- 平衡可靠性与空间效率:在保证数据冗余的前提下,通过算法优化存储开销。

| 优化维度 | 具体技术 | 作用 |

|---|---|---|

| 数据压缩 | Snappy、Gzip、LZO、BZ2等 | 减少原始数据体积 |

| 存储格式 | SequenceFile、Avro、Parquet、ORC | 结构化数据紧凑存储 |

| 编码优化 | 位图索引、Run-Length Encoding(RLE) | 压缩重复数据 |

| 副本策略 | Erasure Coding、副本数调整 | 降低冗余存储开销 |

按位存储的实现机制

数据压缩

- 原理:通过算法将数据转换为更小的表示形式,Snappy(Hadoop默认压缩算法)采用LZ77算法,对文本数据压缩率可达50%-70%。

- 配置方式:在MapReduce作业中通过

mapreduce.map.output.compress和mapreduce.map.output.compress.codec启用压缩。 - 示例:

<property> <name>mapreduce.map.output.compress</name> <value>true</value> </property> <property> <name>mapreduce.map.output.compress.codec</name> <value>org.apache.hadoop.io.compress.SnappyCodec</value> </property>

列式存储格式

- Parquet/ORC:针对分析型场景设计的列式存储格式,支持嵌套数据结构、压缩和向量化读取。

- 优势:

- 仅读取需要的列,减少IO消耗。

- 支持高效压缩(如Parquet的Page级别压缩)。

- 对比:传统行式存储(如TextFile)会浪费大量空间存储空值或重复值。

Erasure Coding替代副本

- 原理:将数据分为数据块和校验块,通过纠删码算法恢复数据,相比3副本存储节省50%空间。

- 配置:HDFS支持

erasureCodePolicy策略,需调整dfs.ec.policy参数。 - 适用场景:冷数据存储或对可靠性要求稍低的场景。

位图索引与RLE编码

- 位图索引:用于快速过滤数据,例如记录某列中“1”和“0”的分布,节省索引存储空间。

- RLE编码:对连续重复值(如日志中的时间戳)进行压缩,例如

[1,1,1,2,2]压缩为3个1, 2个2。

存储优化策略与实践

| 优化方向 | 具体措施 |

|---|---|

| 压缩算法选择 | 文本数据用Snappy/LZO,高压缩比需求用BZ2或ZSTD(需权衡CPU开销)。 |

| 小文件合并 | 使用Hadoop Archives(HAR)或CombineFileInputFormat合并小文件为大Block。 |

| 存储格式优化 | 结构化数据优先使用Parquet/ORC,非结构化数据用SequenceFile(二进制格式)。 |

| 副本策略调整 | 冷热数据分离:热数据保留3副本,冷数据启用Erasure Coding。 |

应用场景与案例

日志处理

- 日志数据具有高重复性和时间连续性,通过Snappy压缩+Parquet列式存储,可将原始日志体积减少80%。

- 示例流程:

# 使用Parquet存储压缩后的日志 hadoop jar parquet-avro-cli.jar parquet-avro-cli.Main --input /logs/raw --output /logs/parquet --compression snappy

机器学习训练数据

- 特征矩阵采用Avro二进制格式存储,配合Gzip压缩,相比CSV减少90%存储空间。

- 优势:加快模型训练时的IO速度。

常见问题与解答(FAQs)

Q1:如何判断是否应该启用数据压缩?

- A:若数据具有高冗余性(如日志、文本),压缩收益显著;若数据已高度压缩(如图片、视频),开启压缩可能增加CPU负载且收益低,建议通过

hadoop fs -cat抽样测试压缩比。

Q2:Erasure Coding与传统副本机制如何选择?

- A:

- 副本机制:适合高可靠性要求场景(如核心业务数据),但存储开销高(3倍空间)。

- Erasure Coding:适合冷数据或对容错性要求较低的场景,存储开销降低至1.5倍,但恢复速度较慢。

- 实践建议:混合使用,例如热数据用副本,冷数据用纠删码