上一篇

分布式存储系统中的会话管理

- 行业动态

- 2025-05-14

- 5

分布式存储会话管理需状态同步与故障恢复,采用集中存储或哈希分布,结合心跳检测保

分布式存储系统中的会话管理

核心概念与背景

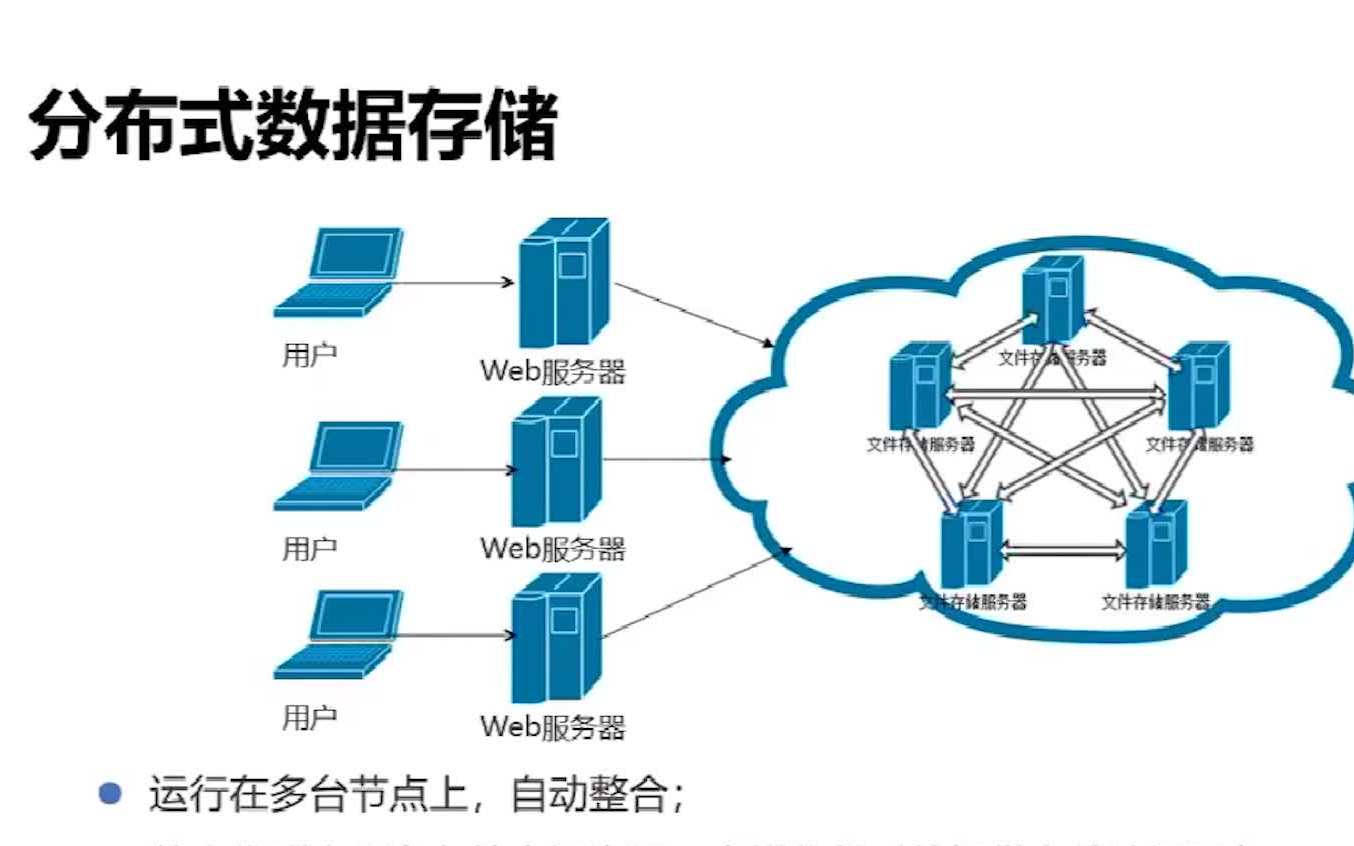

在分布式存储系统中,会话管理是指对用户或客户端与系统交互过程中产生的临时状态信息进行存储、同步和维护的机制,与传统单机系统不同,分布式环境需要解决数据分片、节点故障、网络延迟等问题,同时保证会话的连续性和一致性,典型的应用场景包括电商购物车、在线文档编辑、游戏存档等需要跨多个存储节点维护用户状态的业务。

核心挑战

| 挑战类型 | 具体问题 |

|---|---|

| 数据一致性 | 会话数据可能分布在多个节点,需保证更新操作的原子性和最终一致性 |

| 节点故障 | 主节点宕机时需快速切换,避免会话丢失 |

| 网络分区 | 弱网络环境下需处理节点间通信中断导致的会话状态不同步 |

| 性能瓶颈 | 高频会话读写可能引发单点性能问题(如锁竞争、带宽限制) |

| 扩展性 | 水平扩展时需动态分配会话数据,避免重新哈希导致的服务中断 |

主流解决方案

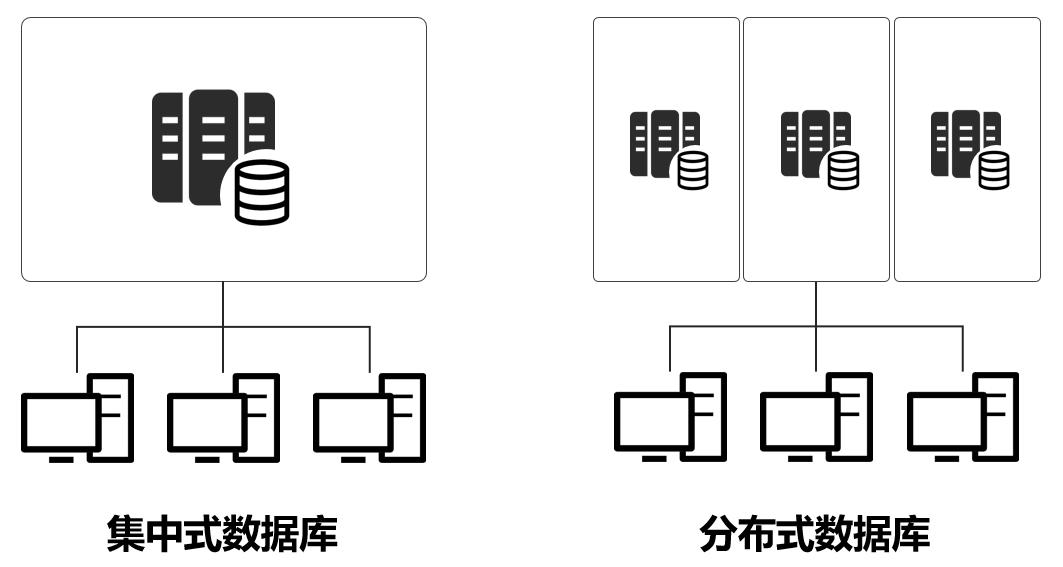

集中式会话存储

- 实现方式:将会话数据统一存储在Redis、Memcached等集中式缓存中,所有节点通过远程调用访问。

- 优点:架构简单,易于维护数据一致性。

- 缺点:存在单点故障风险,性能受网络延迟影响(如Redis集群的主从复制延迟)。

分布式缓存架构

- 实现方式:采用Consul/Etcd实现服务发现,结合一致性哈希算法将会话数据分散到多个缓存节点。

- 关键技术:

- 数据分片:基于用户ID或Session ID进行哈希映射

- 故障转移:通过Raft协议实现主备节点自动切换

- 数据同步:异步复制+定期校验(如CRDT冲突解决)

- 典型案例:Netflix Dynomite(基于Redis的分布式缓存架构)

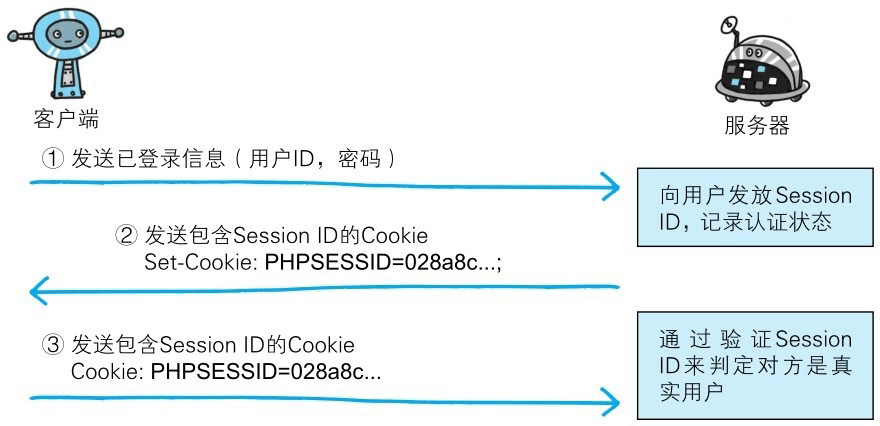

Token-Based会话管理

- 实现原理:

- 客户端首次请求时生成唯一Token(如JWT)

- Token携带会话状态签名,后端节点可独立验证

- 关键数据通过分布式日志(如Kafka)持久化

- 优势:无状态设计,天然支持水平扩展,但需平衡Token大小与安全性。

- 实现原理:

混合型架构

- 组合模式:本地缓存+分布式存储(如Guava Cache + MongoDB)

- 适用场景:读多写少的低频会话场景,通过本地缓存加速访问,异步同步到持久化存储。

关键技术对比

| 方案 | 数据一致性 | 故障恢复时间 | 扩展成本 | 适用场景 |

|---|---|---|---|---|

| 集中式缓存 | 强 | 高(依赖主节点) | 低 | 小规模、低延迟要求场景 |

| 分布式缓存 | 最终一致 | 中(秒级) | 中 | 中大型、高可用性需求 |

| Token机制 | 事件驱动 | 低(无状态) | 高 | 超大规模、全球化部署 |

| 混合架构 | 弱一致 | 中 | 中 | 成本敏感型业务 |

典型场景实践

电商购物车会话管理:

- 需求:跨数据中心容灾、百万级并发会话

- 设计方案:

- 采用Redis Cluster作为主存储,配置主从复制+哨兵监控

- 会话数据按用户ID哈希分片,设置5分钟自动过期

- 热点数据(如促销商品)使用本地LRU缓存加速

- 异步同步关键操作日志到Kafka,用于审计和补偿

- 性能指标:

- 平均响应时间:<10ms(99%分位)

- 故障恢复:<30秒自动切换

- 存储成本:约$0.03/GB/月(含SSD和网络费用)

未来演进趋势

- Serverless会话管理:结合FaaS框架实现按需计费,如AWS Lambda + DynamoDB Streams

- AI预测优化:利用机器学习预测会话生命周期,动态调整资源分配

- 量子安全存储:基于区块链技术的分布式会话签名验证

- 边缘计算融合:在CDN节点就近处理会话数据,减少中心化存储压力

FAQs

Q1:分布式会话管理中如何处理节点时间不同步导致的会话过期问题?

A1:通常采用以下三种策略:

- 逻辑时钟:使用Lamport Clock或Google TrueTime同步节点时间

- 滑动窗口:设置过期缓冲期(如5分钟宽限),允许会话在过期后短暂恢复

- 心跳续约:客户端定期发送心跳包(如WebSocket Ping),自动延长会话有效期

Q2:跨AZ(可用区)部署时如何保证会话数据一致性?

A2:推荐组合方案:

- 强一致性场景:使用跨AZ的Paxos协议(如etcd/ZooKeeper)保证元数据一致

- 最终一致性场景:采用DynamoDB风格的读写修复机制,通过版本向量(Version Vector)解决冲突

- 混合策略:核心会话状态(如登录态)强一致,非关键数据(如