如何高效利用GPU云服务器加速计算任务?

- 行业动态

- 2025-05-08

- 3224

什么是GPU云服务器?

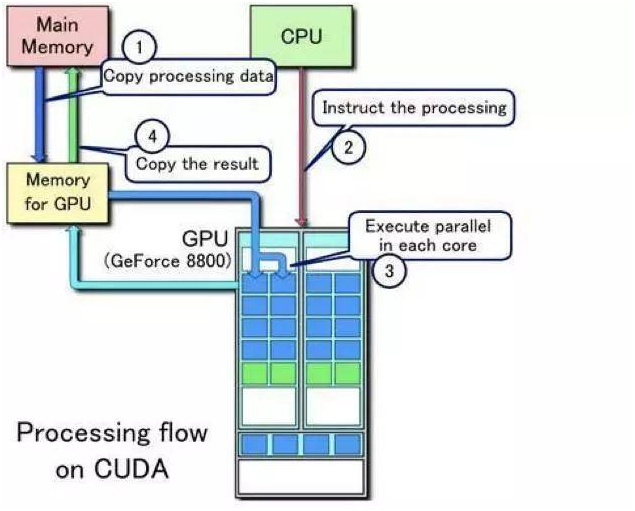

GPU云服务器是基于云计算平台提供的、搭载图形处理器(GPU)的虚拟服务器,与传统CPU服务器不同,GPU凭借强大的并行计算能力,能够高效处理图像渲染、深度学习、科学计算等高负载任务,用户无需购买实体硬件,通过云服务商按需租用即可快速部署。

为什么需要GPU云服务器?

- 高性能计算:GPU擅长处理海量数据并行运算,例如AI模型训练、3D渲染等任务,效率比CPU高数十倍。

- 弹性扩展:根据业务需求随时调整GPU配置,避免硬件闲置或性能不足。

- 成本优化:按使用时长付费,无需承担硬件采购和维护成本。

- 快速部署:主流云平台提供预装框架(如TensorFlow、PyTorch)的镜像,开箱即用。

GPU云服务器的核心使用步骤

选择适合的云服务商与配置

- 主流服务商:阿里云、酷盾、AWS、华为云等均提供GPU实例,支持按小时或包年包月计费。

- GPU型号选择:

- NVIDIA A100/V100:适合深度学习、大规模训练。

- NVIDIA T4:性价比高,适用于推理和轻量级计算。

- AMD Instinct系列:适合特定科学计算场景。

- 配套资源:根据任务需求选择CPU核数、内存、存储(SSD/高效云盘)。

创建GPU实例

- 登录云平台控制台,选择“GPU服务器”产品线。

- 按需选择地域、操作系统(推荐Ubuntu/CentOS)、网络配置(公网IP、安全组)。

- 确认配置后,系统自动分配实例,启动时间通常为1-3分钟。

环境配置与驱动安装

- 安装GPU驱动:

# 以Ubuntu系统为例,安装NVIDIA驱动 sudo apt update sudo apt install nvidia-driver-535 reboot

- 验证驱动状态:

nvidia-smi # 查看GPU状态与显存占用

- 安装CUDA/cuDNN:

根据框架需求选择版本(如CUDA 11.8 + cuDNN 8.9)。

部署应用与任务运行

- 深度学习训练:

- 使用预装框架镜像,或通过

conda/pip安装所需库。 - 上传数据集至云盘,启动训练脚本:

python train.py --batch_size 64 --gpu_id 0

- 使用预装框架镜像,或通过

- 渲染任务:

- 安装Blender/Maya插件,通过命令行调用GPU渲染:

blender -b scene.blend -o output/ -E CYCLES -t 0

- 安装Blender/Maya插件,通过命令行调用GPU渲染:

- 科学计算:

使用OpenACC或CUDA加速的数值模拟工具(如ANSYS、MATLAB)。

监控与优化

- 通过云平台控制台查看GPU利用率、显存占用、网络流量等指标。

- 使用

htop或nvidia-smi实时监控资源消耗。 - 优化代码:减少数据I/O瓶颈,启用混合精度训练,调整批量大小(batch size)。

典型应用场景

| 场景 | 推荐配置 | 案例 |

|——————|———————————-|———————————–|

| 深度学习训练 | 多卡A100 + 高内存 | 训练LLM(大语言模型) |

| 实时推理 | T4 + 低延迟网络 | 部署图像识别API |

| 3D渲染 | RTX 6000 + 大显存 | 影视特效制作 |

| 基因测序分析 | AMD Instinct MI250X + 高速存储 | 生物信息学数据处理 |

选择GPU云服务器的注意事项

- 明确需求:根据任务类型(训练/推理/渲染)选择GPU型号,避免性能浪费。

- 网络与存储:高吞吐任务需搭配SSD云盘及高速内网带宽。

- 安全防护:

- 限制SSH端口访问IP范围。

- 定期备份数据至对象存储(如OSS、COS)。

- 成本控制:

- 竞价实例(Spot Instance)可降低50%-90%成本,适合非实时任务。

- 长期任务建议包年包月。

主流云平台GPU服务对比

| 服务商 | 优势 | 计费模式 |

|————|———————————–|—————————|

| 阿里云 | 国内节点覆盖广,支持裸金属服务器 | 按量/包年包月/竞价实例 |

| AWS | 全球节点,EC2实例类型丰富 | 按秒计费 + Savings Plan |

| 酷盾 | 性价比高,兼容NVIDIA/AMD显卡 | 按量/预留实例 |

常见问题解答

Q1:GPU云服务器和自建GPU工作站哪个更划算?

- 短期项目:云服务器成本更低(无需硬件投入)。

- 长期高负载:自建工作站可能更经济,但需考虑运维成本。

Q2:如何避免GPU资源闲置?

- 使用弹性伸缩组(Auto Scaling)按负载自动启停实例。

- 通过监控告警设置闲置阈值(如GPU利用率<5%时释放资源)。

Q3:是否支持多卡并行?

- 是,需在代码中启用多卡协同(如PyTorch的

DataParallel),并选择支持NVLink的GPU型号。

引用说明

- NVIDIA CUDA安装指南:https://docs.nvidia.com/cuda/

- AWS GPU实例文档:https://aws.amazon.com/ec2/instance-types/

- Gartner 2025云服务报告:https://www.gartner.com/

通过以上步骤与建议,即使是零基础用户也能快速上手GPU云服务器,高效完成计算密集型任务。