上一篇

hive和mysql的语法区别

- 行业动态

- 2025-05-07

- 2889

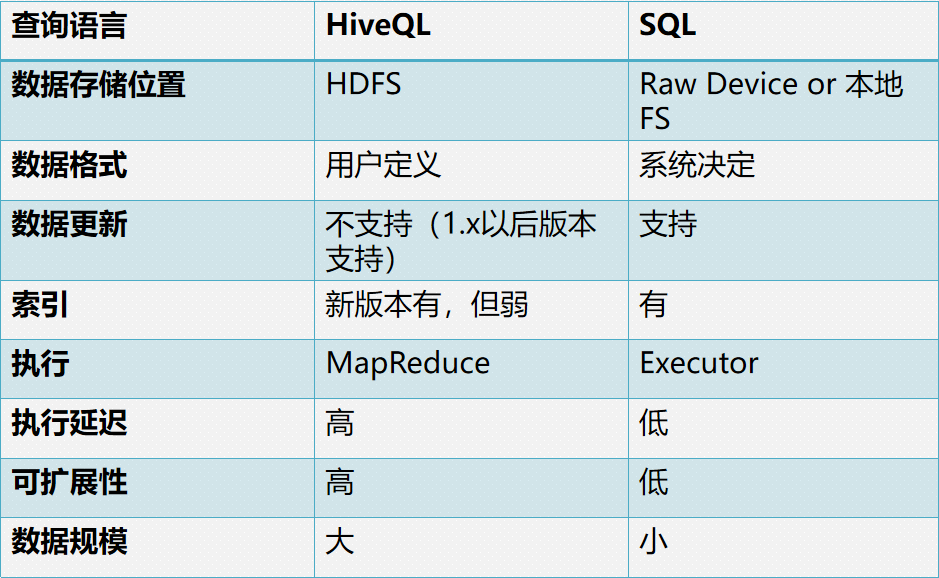

Hive与MySQL语法核心差异:Hive基于HDFS,支持分区/桶/文件格式定义,SELECT需显式指定表及字段,函数侧重大数据处理;MySQL为关系型数据库,语法兼容ANSI SQL,支持事务/索引/存储引擎,适用于OLTP场景

Hive与MySQL语法核心差异解析

Hive和MySQL虽然都使用SQL作为查询语言,但由于定位和底层架构的不同,两者在语法细节上存在显著差异,以下从数据定义、数据操作、函数支持、配置管理等多个维度进行对比分析。

数据定义语言(DDL)差异

| 特性 | Hive | MySQL |

|---|---|---|

| 存储格式 | STORED AS指定存储格式(TEXTFILE/ORC/PARQUET等) | 默认存储引擎(InnoDB/MyISAM)自动管理 |

| 分区表 | PARTITIONED BY定义静态分区,动态分区需开启hive.exec.dynamic.partition | 无原生分区概念,需通过手动分表实现 |

| 外部表 | EXTERNAL TABLE保留数据所有权,删除表不删数据 | 无外部表概念,DROP TABLE会删除数据 |

| 桶表 | CLUSTERED BY哈希分桶,配合DISTRIBUTE BY使用 | 无原生分桶机制,需应用层实现 |

| 临时表 | CREATE TEMPORARY TABLE仅会话可见 | CREATE TEMPORARY TABLE仅会话可见 |

| 注释语法 | / comment /或// comment | / comment /或# comment |

示例对比:

-Hive创建分区表 CREATE TABLE sales ( id BIGINT, name STRING, price DOUBLE ) PARTITIONED BY (dt STRING) STORED AS ORC; -MySQL创建普通表 CREATE TABLE users ( id INT PRIMARY KEY, name VARCHAR(50), age TINYINT ) ENGINE=InnoDB;

数据操作语言(DML)差异

| 特性 | Hive | MySQL |

|---|---|---|

| 插入数据 | INSERT INTO支持从本地文件/HDFS路径加载 | INSERT INTO仅支持VALUES或SELECT |

| 覆盖插入 | INSERT OVERWRITE会覆盖目标表数据 | 无OVERWRITE关键字,需先DELETE再INSERT |

| 动态分区插入 | PARTITION (dt)在INSERT时指定分区 | 无原生分区支持 |

| 批量导入 | LOAD DATA INPATH '/path' INTO TABLE | LOAD DATA INFILE需指定客户端文件路径 |

| 事务支持 | 默认无ACID事务,需开启hive.txn.manager | 完整事务支持(BEGIN/COMMIT/ROLLBACK) |

| 快照功能 | 无快照机制,依赖HDFS快照 | SET SESSION TRANSACTION ISOLATION LEVEL支持行级锁 |

示例对比:

-Hive从HDFS加载数据并分区 INSERT OVERWRITE TABLE sales_part PARTITION(dt='2023-10-01') SELECT FROM staging_data WHERE dt='2023-10-01'; -MySQL常规插入 INSERT INTO users (id,name,age) VALUES (1,'Alice',25);

函数与表达式差异

| 类别 | Hive | MySQL |

|---|---|---|

| JSON处理 | get_json_object(string,'$.key') | JSON_EXTRACT(json,'$.key') |

| 正则表达式 | regexp_replace支持Perl语法 | REGEXP_REPLACE使用MySQL特有语法 |

| 窗口函数 | 支持NTILE()等高级窗口函数 | 7+版本开始支持基础窗口函数 |

| 类型转换 | CAST(date_str AS DATE)严格模式 | STR_TO_DATE('2023-10-01','%Y-%m-%d') |

| 条件判断 | IF函数返回TRUE/FALSE值 | IF(condition,true_val,false_val)返回数值型 |

| 数组操作 | size(array_col)获取数组长度 | 无原生数组类型,需用JSON模拟 |

典型差异示例:

-Hive日期处理 SELECT current_date(), current_timestamp(); -返回DATE/TIMESTAMP类型 -MySQL日期处理 SELECT CURDATE(), NOW(); -返回DATE/DATETIME类型

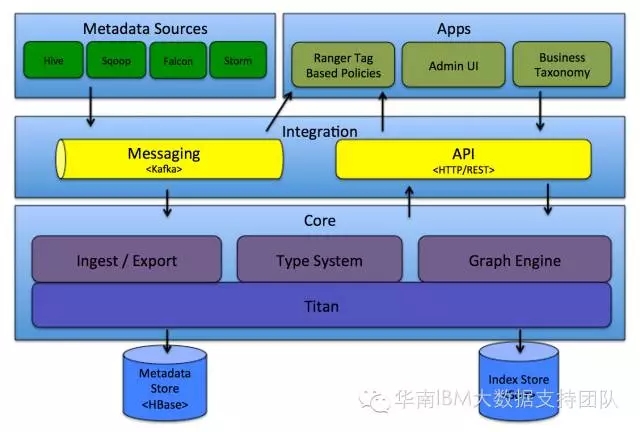

系统配置与元数据管理

| 特性 | Hive | MySQL |

|---|---|---|

| 全局配置 | SET hive.exec.parallel=true;会话级配置 | SET @@global.max_connections=100;全局配置需重启生效 |

| 元数据存储 | Derby/PostgreSQL/MySQL(通过javax.jdo.option.ConnectionURL配置) | 自包含元数据,无需外部存储 |

| 执行计划查看 | EXPLAIN EXTENDED显示MapReduce阶段详情 | EXPLAIN显示执行树和索引使用情况 |

| 资源管理 | SET mapreduce.job.queuename=etl;指定YARN队列 | 无原生资源队列管理,依赖操作系统调度 |

特殊语法场景对比

动态列处理

- Hive:

CREATE TABLE schema_less (key STRING, value STRING) STORED AS PARQUET+ALTER TABLE ADD COLUMNS - MySQL:需预先定义所有列,ALTER TABLE仅支持添加固定位置列

- Hive:

复杂类型支持

- Hive:

ARRAY<DOUBLE>、MAP<STRING,INT>、STRUCT<name:STRING> - MySQL:仅支持

JSON类型存储半结构化数据

- Hive:

性能调优语法

- Hive:

MAPJOIN提示、SKIP HEADER文件导入选项 - MySQL:

FORCE INDEX强制索引、SQL_NO_CACHE禁用缓存

- Hive:

FAQs

Q1:如何在Hive中实现类似MySQL的自增主键?

A1:Hive本身不支持AUTO_INCREMENT,但可通过以下方式模拟:

- 使用序列生成函数:

SELECT monotonize_increment() as id FROM ... - 结合UUID:

INSERT INTO table SELECT uuid(), other_cols FROM ... - 在数据加载前通过外部脚本生成序号(推荐方式)

Q2:Hive的UPDATE操作为何受限?如何变通?

A2:Hive的UPDATE/DELETE操作受以下限制:

- 仅支持单分区表的UPDATE

- 需要开启事务支持(

SET hive.support.concurrency=true)

变通方案:

- 使用

INSERT OVERWRITE重建表数据 - 采用MERGE语法(Hive 2.x+):

MERGE INTO target_table USING source_table ON target.id = source.id WHEN MATCHED THEN UPDATE SET target.value