上一篇

hive访问mysql数据库

- 行业动态

- 2025-05-06

- 3279

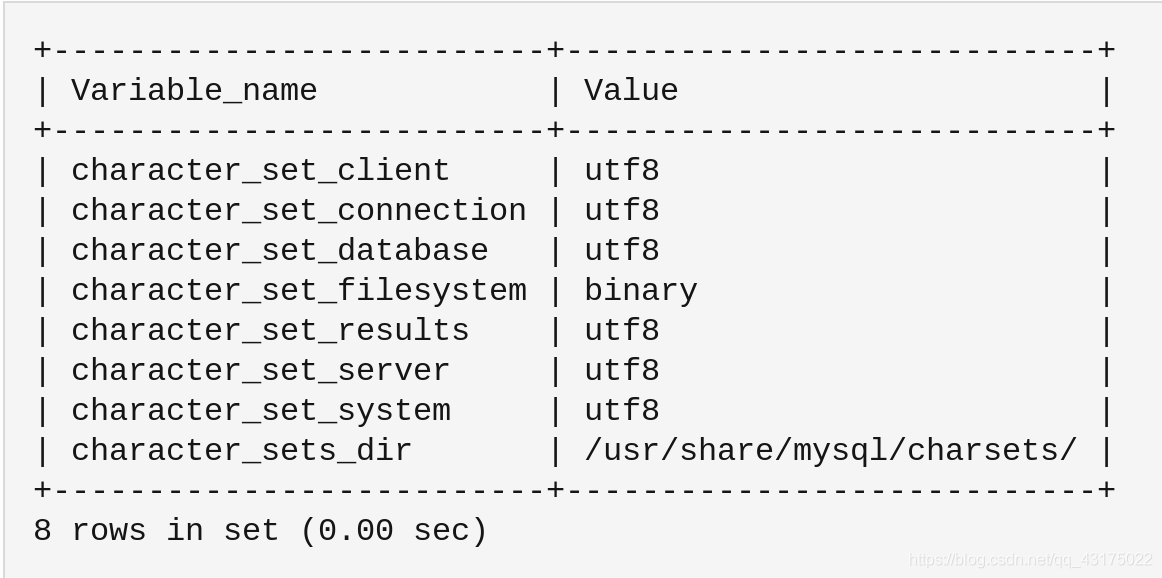

Hive访问MySQL需在hive-site.xml配置JDBC连接:设置javax.jdbc.url、user、password及driverClassName为com.mysql.jdbc.Driver,并将mysql-connector-java.jar放入Hive lib目录,注意字符集编码统一为UTF

Hive访问MySQL数据库的实现原理与操作指南

Hive与MySQL的集成背景

在大数据处理场景中,Hive作为基于Hadoop的数据仓库工具,常用于处理海量结构化数据,而MySQL作为关系型数据库,通常承担事务性数据存储角色,两者的数据互通需求常见于以下场景:

- 数据同步:将业务系统的MySQL数据同步至Hive进行离线分析

- 混合计算:在Hive中直接关联MySQL表进行联合查询

- 数据迁移:将历史数据从MySQL迁移至Hive分布式存储

核心实现方式对比

| 实现方式 | 适用场景 | 性能表现 | 配置复杂度 | 数据实时性 |

|---|---|---|---|---|

| Sqoop导入 | 批量数据迁移 | 高 | 低 | 离线 |

| JDBC连接器 | 实时查询 | 中 | 中 | 实时 |

| 自定义UDF | 复杂转换逻辑 | 低 | 高 | 实时 |

| 外部表映射 | 临时查询 | 高 | 低 | 实时 |

实施前准备

环境要求

- Hive版本:2.x/3.x(需支持JDBC扩展)

- MySQL版本:5.7+(推荐8.0)

- 网络连通:Hive服务器需能访问MySQL端口(默认3306)

驱动部署

- 下载MySQL JDBC驱动(如mysql-connector-java-8.0.xx.jar)

- 上传至Hive的lib目录:

/usr/local/hive/lib/ - 重启Hive服务使驱动生效

权限配置

-MySQL端创建专用用户 CREATE USER hive_user@'%' IDENTIFIED BY 'password'; GRANT SELECT ON database_name. TO hive_user;

具体实现方案

Sqoop数据导入

适用场景:批量迁移全量数据

sqoop import --connect jdbc:mysql://mysql-server:3306/database_name --username hive_user --password password --table source_table --hive-import --hive-table target_table --m 4 --split-by id

参数说明:

--hive-overwrite:是否覆盖目标表--direct:启用MySQL原生方式导入(需MySQL 5.7+)--query:执行自定义SQL代替全表扫描

外部表映射

适用场景:实时关联查询

CREATE EXTERNAL TABLE mysql_table STORED BY 'org.apache.hadoop.hive.jdbc.JdbcEscapingStorageHandler' LOCATION 'hdfs:///user/hive/external/' TBLPROPERTIES ( "jdbc.url" = "jdbc:mysql://mysql-server:3306/database_name", "jdbc.user" = "hive_user", "jdbc.password" = "password", "jdbc.driver" = "com.mysql.cj.jdbc.Driver" ) AS SELECT FROM source_table;

自定义函数访问

适用场景:复杂数据转换

// 注册UDF示例

public class MySqlQueryUDF extends UDF {

public String evaluate(String query) {

// JDBC连接逻辑

return result;

}

}

// Hive调用示例

ADD JAR myudf.jar;

CREATE TEMPORARY FUNCTION my_query AS 'com.example.MySqlQueryUDF';

SELECT my_query('SELECT count() FROM user_table');性能优化策略

- 分区表设计:按时间字段分区减少扫描范围

- 并行配置:调整

mapreduce.job.reduces参数 - 索引优化:在MySQL端建立合适的索引

- 缓存机制:启用Hive缓存元数据功能

常见问题诊断

| 错误现象 | 可能原因 | 解决方案 |

|---|---|---|

| 连接超时 | 网络不通/驱动缺失 | 检查防火墙,确认驱动正确部署 |

| 表结构不匹配 | 数据类型差异 | 使用CAST转换或修改表结构 |

| 内存溢出 | 单任务处理数据量过大 | 增加split数量或启用并行 |

| 字符集乱码 | 编码不一致 | 统一设置UTF-8编码 |

安全增强措施

- 加密传输:配置SSL连接

jdbc:mysql://...?useSSL=true - 动态脱敏:在Hive端过滤敏感字段

- 审计日志:开启MySQL的general_log记录访问

- 资源隔离:通过Hadoop YARN限制查询资源

FAQs

Q1:Hive连接MySQL时出现”No suitable driver”错误怎么办?

A1:需确保三点:①MySQL JDBC驱动已放入Hive的lib目录;②Hive配置文件包含hive.execution.engine=tez(根据实际引擎调整);③驱动类名正确,应为com.mysql.cj.jdbc.Driver(MySQL 8.x)或com.mysql.jdbc.Driver(旧版本)。

Q2:如何监控Hive访问MySQL的性能?

A2:可通过以下方式监控:

- MySQL端开启慢查询日志,定位耗时语句

- Hive作业页面查看MapReduce任务执行情况

- 使用

EXPLAIN分析查询计划 - 部署Prometheus监控JVM