上一篇

hive数据库连接

- 行业动态

- 2025-05-09

- 2153

Hive数据库连接需JDBC驱动,URL格式为jdbc:hive2://host:port/db,配置主机、端口、数据库及认证方式,支持Beeline

Hive数据库连接是大数据开发中的核心操作之一,其连接方式、配置参数及兼容性直接影响数据处理效率,本文将从基础概念、连接方式、配置要点到常见问题进行全面解析,帮助开发者掌握Hive数据库的高效连接方法。

Hive数据库连接基础

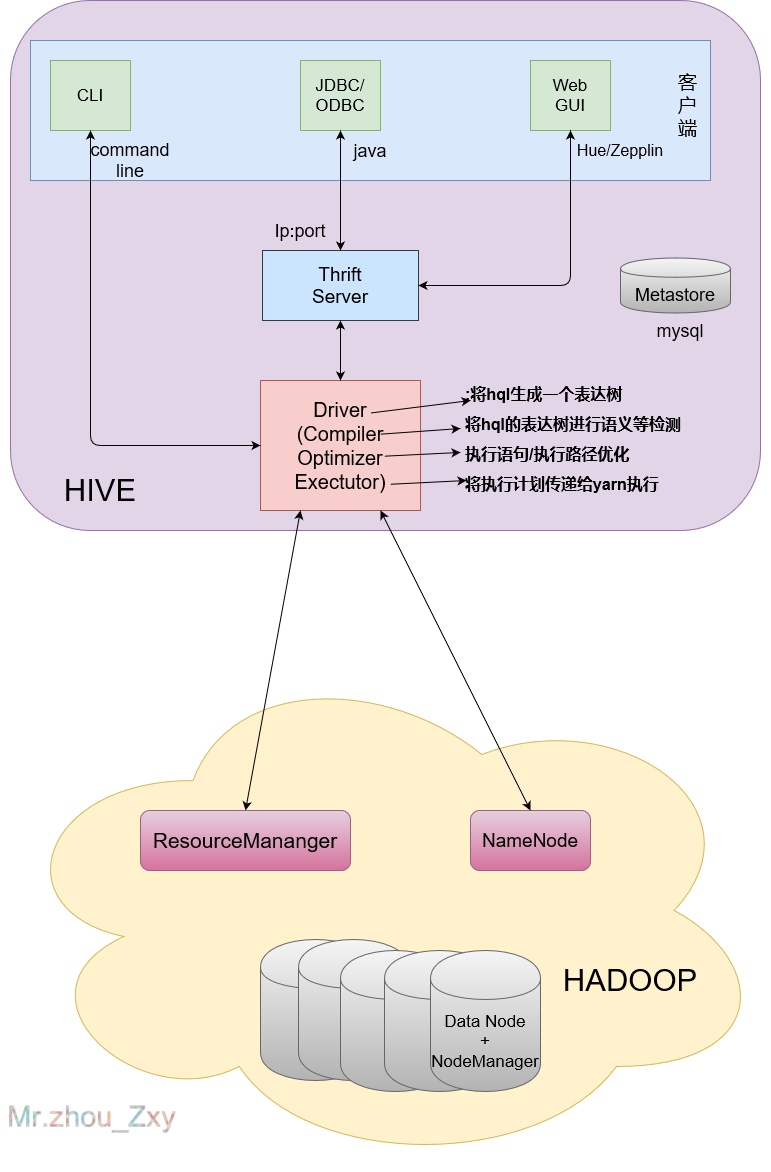

Hive是基于Hadoop的数据仓库工具,通过SQL-like语法实现对大规模数据的查询,其连接本质是通过Thrift服务暴露的JDBC接口与客户端通信,连接过程涉及以下核心组件:

- Metastore:存储元数据的MySQL/PostgreSQL数据库

- HiveServer2:提供Thrift服务的守护进程

- Driver:各语言对应的JDBC/ODBC驱动

- Security:Kerberos认证或SASL加密机制

主流连接方式对比

| 连接方式 | 适用场景 | 优点 | 缺点 |

|---|---|---|---|

| Beeline | 命令行快速验证 | 轻量级,无需额外配置 | 无脚本保存功能 |

| JDBC | Java应用集成 | 性能最优,支持事务 | 需手动管理连接池 |

| ODBC | Windows生态工具(如Tableau) | 跨平台兼容性好 | 配置复杂,性能略低 |

| PyHive | Python数据分析 | 语法简洁,与Pandas无缝衔接 | 版本兼容性问题突出 |

| REST API | 跨语言HTTP调用 | 防火墙穿透性好 | 功能受限,性能损耗明显 |

详细连接配置指南

Beeline连接配置

beeline -u "jdbc:hive2://<hostname>:<port>/<database>" -n <username> --password=<password> --hiveconf hive.server2.thrift.resultset.default.fetch.size=1000

关键参数说明:

hive.exec.compress.output:开启结果压缩(建议LZO)hive.resultset.use.unique.column.names:处理重复列名hive.auto.convert.sortmerge.join:优化JOIN操作

JDBC连接示例(Java)

import java.sql.Connection;

import java.sql.DriverManager;

import java.util.Properties;

public class HiveConnector {

public static void main(String[] args) throws Exception {

String url = "jdbc:hive2://node1:10000,node2:10000/default";

Properties props = new Properties();

props.setProperty("user", "hive_user");

props.setProperty("password", "secret");

props.setProperty("hive.server2.transport.mode", "http"); // HTTP模式

props.setProperty("hive.resultset.use.unique.column.names", "true");

try (Connection conn = DriverManager.getConnection(url, props)) {

// 执行查询逻辑

}

}

}驱动依赖:需将hive-jdbc-<version>.jar加入classpath,版本需与HiveServer2匹配。

Python连接实践(PyHive)

from pyhive import hive import pandas as pd conn = hive.Connection(host='hive-server', port=10000, username='admin', database='default') cursor = conn.cursor() # 执行查询并转换为DataFrame query = "SELECT FROM user_logs WHERE event_time > '2023-01-01'" df = pd.read_sql(query, conn) print(df.head())

性能优化技巧:

- 设置

hive.vectorized.execution.enabled=true启用向量化执行 - 使用

hive.fetch.task.max.rows=100000调整单次抓取行数 - 开启

hive.exec.parallel=true允许并行执行

安全认证配置

Kerberos认证配置

// Java示例

System.setProperty("java.security.krb5.conf", "/etc/krb5.conf");

Properties props = new Properties();

props.setProperty("hive.server2.authentication", "KERBEROS");

props.setProperty("hive.kerberos.principal", "hive/_HOST@REALM.COM");票据获取命令:

kinit -kt /etc/krb5.keytab hive_principal

SSL加密配置

<!-hive-site.xml --> <property> <name>hive.server2.transport.mode</name> <value>https</value> </property> <property> <name>hive.server2.ssl.enabled</name> <value>true</value> </property> <property> <name>hive.server2.ssl.keystore.path</name> <value>/etc/hive/keystore.jks</value> </property>

常见问题与解决方案

问题1:连接超时如何处理?

解决方案:

- 检查HiveServer2状态:

jps | grep HiveServer2 - 调整

hive.server2.thrift.resultset.default.fetch.size为合理值(建议1000-5000) - 配置网络超时参数:

hive.connection.timeout.interval=60000 # 60秒 hive.connection.timeout.idle=3600000 # 60分钟空闲超时

- 检查防火墙规则:确保10000/10001端口开放

问题2:驱动版本不兼容导致报错

解决方案:

- 核对驱动版本与HiveServer2版本对应关系:

| Hive版本 | 兼容JDBC驱动版本 |

|———-|————————|

| 2.x | hive-jdbc-2.x.x.jar |

| 3.x | hive-jdbc-3.x.x.jar | - 使用Maven依赖管理:

<dependency> <groupId>org.apache.hive</groupId> <artifactId>hive-jdbc</artifactId> <version>3.1.2</version> <!-根据实际Hive版本选择 --> </dependency> - 验证驱动类加载顺序,避免多版本冲突

性能优化建议

| 优化方向 | 具体措施 |

|---|---|

| 网络传输 | 启用压缩(hive.server2.thrift.use.sasl=true + hive.server2.thrift.sasl.qop=auth) |

| 并发控制 | 设置hive.server2.thrift.max.worker.threads=500 |

| SQL执行 | 开启CBO优化(hive.compute.query.using.stats=true) |

| 资源隔离 | 配置hive.server2.tez.default.queues=high_priority,low_priority |

| 连接池管理 | 使用HikariCP连接池,设置最大连接数为hive.server2.max.sessions=200 |

FAQs

Q1:如何解决”FAILED: SemanticException [Error 10144]”错误?

A1:该错误通常由元数据不一致引起,解决方法:

- 执行

MSCK REPAIR TABLE table_name修复元数据 - 检查HDFS文件与Metastore记录的一致性

- 重启HiveServer2服务后重试

Q2:Python连接时出现”No module named ‘thrift'”怎么办?

A2:需要安装Thrift依赖库:

pip install thriftpy2 # Thrift Python库 pip install pyhive # Hive连接库

注意Python版本需与Thrift库兼容(推荐Python 3.6+