上一篇

GPU计算服务器性能差异如何影响你的选择?

- 行业动态

- 2025-05-08

- 6

GPU计算服务器配备高性能显卡,擅长并行计算,适合AI训练、科学仿真等密集型任务,具备高浮点运算能力;普通服务器侧重通用计算,依赖CPU处理串行任务,适用于日常数据处理、网络服务等场景,两者架构与核心性能差异显著。

GPU计算服务器区别在哪?

在人工智能、大数据分析和科学计算等领域,GPU计算服务器已成为核心基础设施,但对于普通用户而言,不同GPU服务器的差异可能并不直观,本文将从硬件架构、应用场景、性能表现、成本投入等角度,详细解析GPU服务器之间的核心区别,并提供选型建议。

硬件架构:GPU型号与设计理念

GPU服务器的核心差异首先体现在GPU芯片的型号和架构上。

- NVIDIA A100/H100:专为AI训练和高性能计算(HPC)设计,搭载第三代Tensor Core和更高的显存带宽(如H100的3TB/s),适合处理超大规模模型。

- NVIDIA V100/T4:面向推理和轻量级训练场景,T4的低功耗设计更适用于边缘计算。

- AMD Instinct MI系列:采用CDNA架构,强调高吞吐和能效比,适合特定科学计算场景。

不同架构的GPU在计算单元(CUDA核心/Tensor核心)、显存容量(16GB至80GB)和互联技术(NVLink vs PCIe)上差异显著,直接影响并行计算效率。

应用场景:匹配需求是关键

GPU服务器的选型需紧密结合实际需求:

- AI模型训练

需要高显存(如A100 80GB)和多GPU互联(NVLink),以支持千亿参数模型的分布式训练。 - 推理部署

更关注能效比和延迟,T4或A10 GPU凭借低功耗和INT8/FP16加速能力,是主流选择。 - 科学计算(如流体力学、分子动力学)

需双精度浮点性能(FP64),AMD MI250X等GPU在此场景表现突出。 - 图形渲染与虚拟化

NVIDIA RTX系列或专业级Quadro GPU支持实时光追和虚拟化分割(vGPU)。

性能参数:核心指标对比

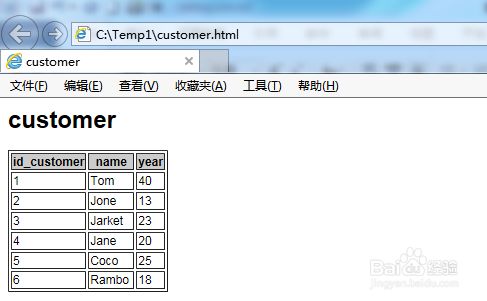

以下为常见GPU关键参数对比:

| GPU型号 | 显存容量 | Tensor Core | FP32算力 (TFLOPS) | 适用场景 |

|---|---|---|---|---|

| NVIDIA A100 | 40/80GB | 第三代 | 5 | 大规模训练/HPC |

| NVIDIA H100 | 80GB | 第四代 | 51 | 下一代AI模型 |

| NVIDIA T4 | 16GB | 第二代 | 1 | 推理/边缘计算 |

| AMD MI250X | 128GB | CDNA2 | 9 (FP64) | 科学计算 |

注:数据来自NVIDIA/AMD官方技术文档,部分为理论峰值。

服务器配置:不只是GPU

除了GPU本身,服务器整体设计同样重要:

- CPU与内存:需避免瓶颈,例如双路Intel Xeon或AMD EPYC处理器搭配DDR4/5高频内存。

- 存储与网络:NVMe SSD和100Gbps RDMA网络(如InfiniBand)可提升数据吞吐效率。

- 散热与功耗:高端GPU(如H100)单卡功耗达700W,需液冷或定制散热方案。

成本差异:自建 vs 云服务

- 自建集群:前期投入高(单台服务器成本可达数万美元),适合长期稳定需求。

- 云GPU服务器(如AWS EC2、阿里云GN7):按需租用,灵活性高,但长期成本可能超过自建。

- 性价比权衡:A100每小时租金约3-5美元,而T4仅需0.5美元,需根据任务类型选择。

如何选择?3个核心原则

- 明确需求优先级:训练速度、显存容量、能效比,哪项最关键?

- 兼容性与生态:CUDA生态(NVIDIA)更成熟,但AMD在开源框架中逐步提升支持。

- 扩展性:支持多GPU互联的服务器更适合未来升级。

GPU服务器并非“越贵越好”,而是需要根据业务场景、预算规模和性能需求精准匹配,初创公司可选择云服务+T4快速验证AI模型,而科研机构可能需自建A100/H100集群处理PB级数据。

建议通过实际业务测试(如Benchmark工具)验证服务器性能,或咨询专业厂商获取定制方案。

参考文献

- NVIDIA A100技术白皮书, 2020.

- AMD Instinct MI250X架构解析, 2022.

- AWS EC2 GPU实例文档.

- 《AI硬件选型指南》, Gartner, 2025.