GPU计算服务器如何成为企业高效运算的必备利器?

- 行业动态

- 2025-05-08

- 6

GPU计算服务器通过并行处理大幅提升计算效率,尤其适合深度学习、科学模拟等高负载任务,其强大的图形处理能力可加速复杂模型训练与数据分析,支持多GPU协同扩展算力,同时优化能耗比,降低长期运营成本,为高性能计算提供高效解决方案。

为什么企业需要GPU计算服务器?

在数字化转型的浪潮中,GPU计算服务器正成为企业提升竞争力的“秘密武器”,无论是处理复杂的AI模型、加速科学计算,还是优化实时数据分析,GPU服务器的优势已远超传统CPU架构,以下是其核心价值的深度解析:

性能飞跃:释放算力潜能

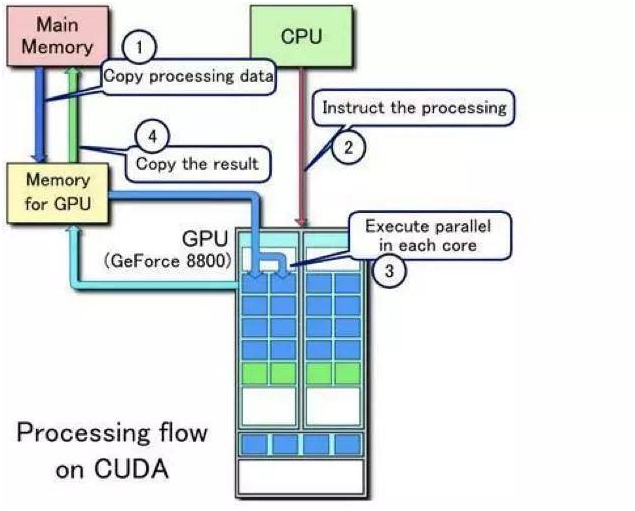

GPU(图形处理器)天生为并行计算而生,与CPU相比,其核心数量多出数百倍,可同时处理成千上万的计算线程,NVIDIA A100 GPU的单精度浮点性能达19.5 TFLOPS,远超高端CPU的算力水平。

- 典型场景:

- AI训练:将深度学习模型训练时间从数周缩短至几天。

- 科学模拟:流体力学、分子动力学等仿真效率提升10倍以上。

- 实时渲染:8K视频渲染速度比CPU快50-100倍。

成本效益:长期投入更划算

虽然GPU服务器初期成本较高,但其超高效率可显著降低长期运营成本:

- 能耗比优化:相同任务下,GPU的能耗仅为CPU集群的1/5。

- 硬件集约化:1台配备8块GPU的服务器可替代数百台CPU节点。

- 人力成本节约:缩短项目周期,减少运维团队规模。

案例:某电商平台采用GPU服务器后,推荐算法迭代速度提升80%,年度IT支出降低35%。

行业覆盖:从科研到商业的全域赋能

GPU服务器的应用已渗透各领域:

| 行业 | 应用场景 | 效果提升 |

|———-|————–|————–|

| 医疗健康 | 基因测序、医学影像分析 | 数据处理速度提升40倍 |

| 自动驾驶 | 传感器融合、路径规划 | 模型训练效率提高60% |

| 金融科技 | 高频交易、风险建模 | 实时计算延迟降低至微秒级 |

| 制造业 | 数字孪生、缺陷检测 | 产品开发周期缩短70% |

技术生态:成熟的软硬件支持

主流厂商构建了完整的GPU生态链:

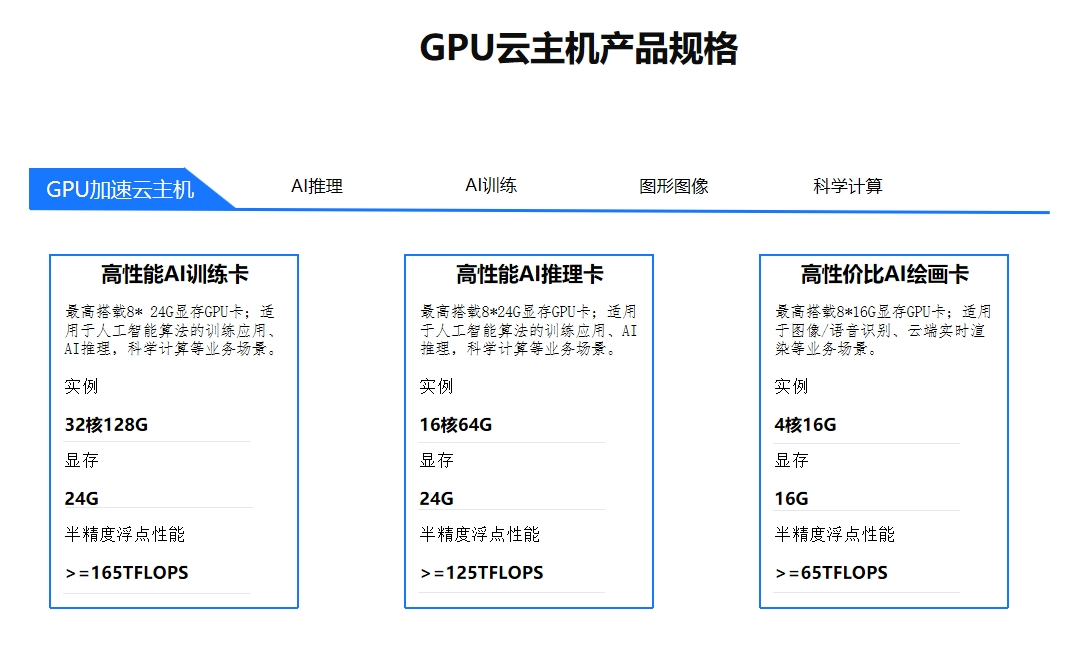

- 硬件兼容:支持NVIDIA Ampere架构、AMD CDNA等最新技术

- 软件框架:CUDA、TensorFlow、PyTorch等深度优化工具链

- 云服务集成:AWS EC2 P4d、阿里云GN7等即开即用实例

数据来源:NVIDIA 2025开发者报告显示,90%的AI项目选择GPU作为核心算力平台。

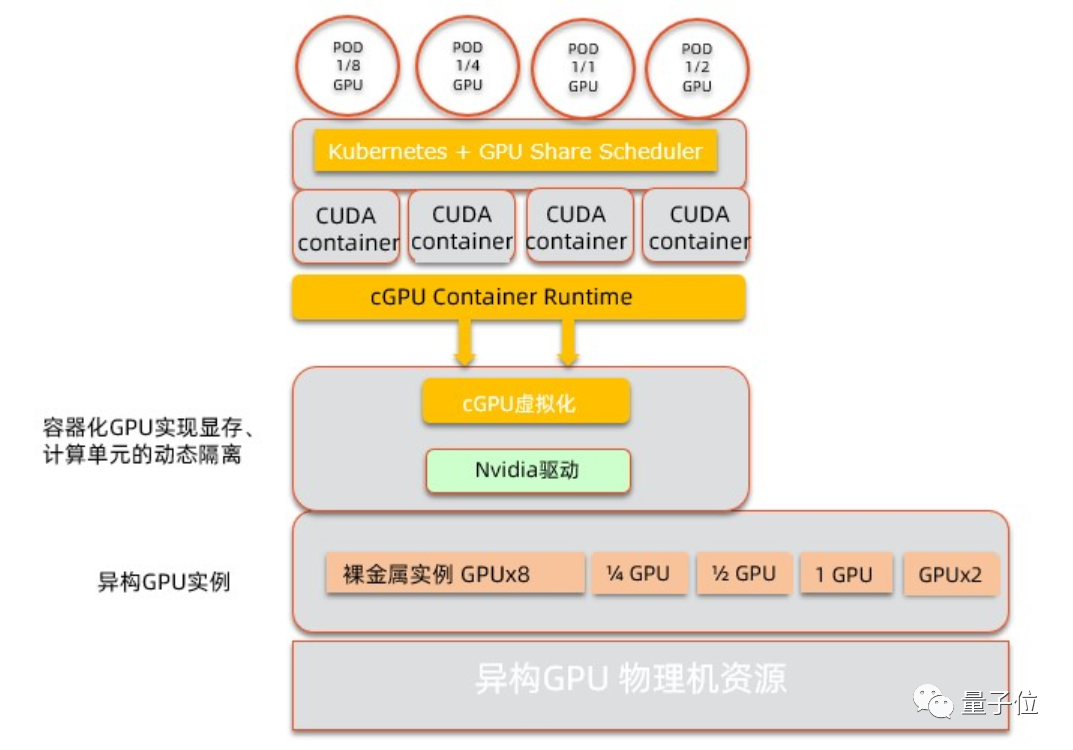

可扩展性:灵活应对业务增长

GPU服务器支持横向与纵向扩展:

- 单机多卡:通过NVLink实现GPU间900GB/s超高速互联

- 集群部署:利用RDMA网络构建千卡级计算集群

- 混合架构:与CPU、FPGA协同工作,适配不同负载需求

安全合规:企业级防护体系

现代GPU服务器提供多重安全保障:

- 硬件加密:NVIDIA Hopper架构支持TEE可信执行环境

- 数据隔离:通过vGPU技术实现多租户资源分割

- 认证标准:符合ISO 27001、GDPR等国际安全规范

未来趋势:GPU计算的新边界

据IDC预测,2025年全球GPU服务器市场规模将突破400亿美元,年复合增长率达28%,随着量子计算模拟、元宇宙内容生成等新兴场景爆发,GPU服务器将成为企业技术栈的标配。

参考文献

- NVIDIA官方技术白皮书《Accelerated Computing: The Future of Enterprise IT》

- IDC 2025全球AI基础设施市场报告

- AWS re:Invent 2025 GPU云计算最佳实践

- 《Nature》期刊:GPU在气候建模中的突破性应用