hive删除一行数据库

- 行业动态

- 2025-05-07

- 4199

在Hive中无法直接删除单行数据,需通过覆盖表实现,删除整个数据库使用:DROP DATABASE database_name CASCADE;(注意:该操作不可逆

Hive删除一行数据库操作详解与实践指南

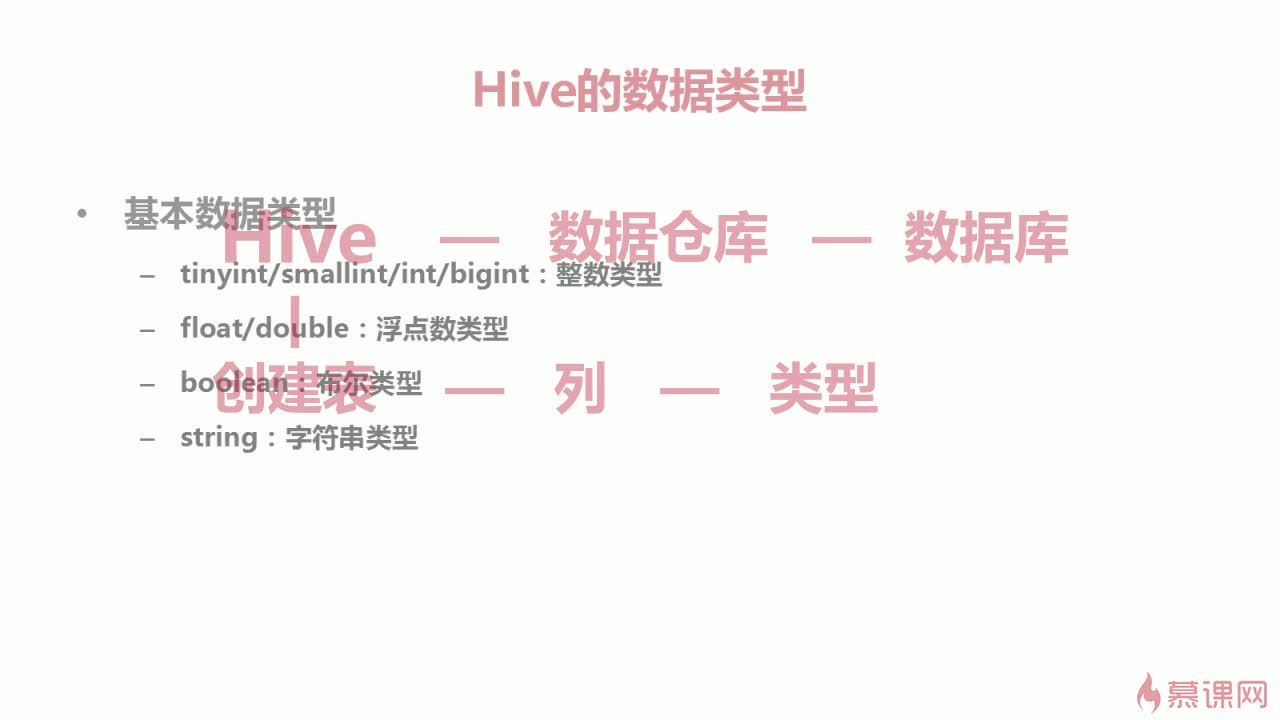

Hive数据管理基础认知

Hive作为大数据领域的事实标准数据仓库,其数据存储与操作机制与传统关系型数据库存在显著差异,在深入探讨删除操作前,需要先建立对Hive架构特性的正确理解:

| 特性维度 | Hive特性 | 传统数据库对比 |

|---|---|---|

| 存储格式 | 基于HDFS的分布式存储,数据按块存储 | 行式存储,支持索引 |

| 数据更新 | 写时复制机制,表不可直接修改 | 支持原地更新(UPDATE/DELETE) |

| 事务支持 | 0+版本支持ACID事务(需开启配置) | 原生事务支持 |

| 分区机制 | 支持多级分区(年/月/日/时等时间维度) | 有限分区能力 |

| 数据删除 | 基于文件系统操作,最小删除单位为分区/文件 | 支持行级删除 |

Hive删除操作的核心限制

Hive的架构设计决定了其数据操作的特殊性,主要体现在以下三个方面:

物理删除机制

Hive采用”写时复制”策略,所有删除操作本质都是创建新文件覆盖原有数据,这种机制带来两个重要影响:- 删除操作具有原子性,通过临时目录完成数据交换

- 无法实现真正的单行删除,最小操作单位是文件块

元数据管理特性

Hive的元数据存储在关系型数据库(如MySQL)中,包含:- 表结构定义(DDL)

- 分区信息

- 文件路径映射

删除操作需要同步更新元数据,这增加了操作复杂性

ACID事务限制

虽然Hive 3.0+支持ACID事务,但实际应用中存在诸多限制:- 需启用

hive.support.concurrency等配置 - 仅对ORC/Kudu等特定存储格式有效

- 性能开销显著(约30%+资源消耗)

- 需启用

删除操作的实现路径

根据数据组织形式,Hive提供多种删除实现方式,具体选择需结合业务场景:

全表覆盖删除法(最常用)

INSERT OVERWRITE TABLE target_table SELECT FROM target_table WHERE condition;

原理解析:

- 创建临时目录写入过滤后的数据

- 原子性替换原始数据目录

- HDFS层面完成文件删除

- 更新元数据分区信息

优势:

- 完全保留表结构

- 支持复杂过滤条件

- 可并行执行

局限性:

- 需要完整扫描表数据

- 临时存储空间消耗(约2倍数据量)

- 无法精确控制删除粒度

分区删除法

ALTER TABLE log_data DROP IF EXISTS PARTITION(dt='2023-08-15');

适用场景:

- 时间序列数据按天/小时分区

- 用户行为数据按地域分区

- 日志数据按设备类型分区

操作要点:

- 必须预先建立分区键

- 支持多级分区删除(如年.月.日)

- 删除后不可恢复

ACID事务删除(Hive 3.0+)

DELETE FROM user_behavior WHERE user_id = 'A123';

前置条件:

- 表存储格式为ORC/Kudu

- 开启事务支持配置:

SET hive.txn.manager=org.apache.hadoop.hive.ql.lockmgr.DbTxnManager; SET hive.compactor.initiator.on=true; SET hive.compactor.worker.threads=1;

注意事项:

- 仅支持单表操作

- 需要MRF(元数据回收服务)支持

- 性能损耗约25-40%

- 事务日志存储在HDFS指定目录

删除操作的性能优化策略

针对大规模数据删除场景,建议采用以下优化组合:

| 优化策略 | 实施方法 | 预期效果 |

|---|---|---|

| 分区裁剪 | 使用PARTITION()函数限定扫描范围 | 减少50-80%数据扫描量 |

| 文件合并 | 设置mapreduce.job.reduces=1强制单Reducer | 提升小文件处理效率 |

| 资源隔离 | 使用Tez引擎并设置hive.tez.container.size参数 | 降低YARN集群资源竞争 |

| 索引加速 | 对过滤字段建立Compaction索引(BITMAP/BLOOM) | 提升查询过滤速度 |

| 并行执行 | 拆分大查询为多个子查询并行执行 | 缩短整体执行时间 |

数据恢复与审计机制

Hive删除操作的不可逆性要求建立完善的数据保护体系:

版本化存储

- 使用HDFS快照功能:

hdfs dfs -createSnapshot /user/hive/warehouse/log_data_v1 - 保留最近N个版本(建议3-5个)

- 快照空间占用约1-2%原始数据量

- 使用HDFS快照功能:

操作审计日志

- 开启Hive审计日志:

set hive.audit.log=true; - 包括:

- 操作时间戳

- 执行用户

- SQL文本

- 影响行数估算

- 执行时长

- 开启Hive审计日志:

增量备份策略

- 每日增量备份元数据(通过mysqldump导出Hive元数据库)

- 每周全量备份HDFS数据目录

- 备份文件存储多副本(建议3副本)

典型应用场景分析

场景1:日志清理(时间窗口删除)

-删除7天前的日志数据 ALTER TABLE app_logs DROP IF EXISTS PARTITION(log_date < DATE_SUB(CURRENT_DATE,7));

优化建议:

- 建立二级分区(year/month/day)

- 配置生命周期策略(Hadoop自动清理)

- 使用ORC列式存储压缩日志

场景2:用户数据清除(精准删除)

-删除指定用户的浏览记录 INSERT OVERWRITE TABLE user_profiles SELECT FROM user_profiles WHERE user_id != 'delete_target';

注意事项:

- 确保WHERE条件建立索引

- 验证新表数据完整性(COUNT校验)

- 删除后立即触发Compaction

场景3:异常数据修正(事务删除)

-启动事务 SET hive.txn.manager=org.apache.hadoop.hive.ql.lockmgr.DbTxnManager; DELETE FROM transactions WHERE order_id = 'INVALID_001'; -提交事务 COMMIT;

风险控制:

- 提前测试事务回滚机制

- 监控MRF工作状态

- 限制并发事务数量(建议<10)

常见错误与解决方案

| 错误现象 | 原因分析 | 解决方案 |

|---|---|---|

| “Partition not found” | 分区名称拼写错误/不存在该分区 | 检查PARTITION()语法,使用DESC查看表结构 |

| “FileSystem closed” | HDFS客户端会话超时 | 增加dfs.client.socket-timeout参数值 |

| “Lock acquisition failed” | 并发事务锁冲突 | 设置hive.txn.lock.timeout参数,错峰执行 |

| “Memory limit exceeded” | Mapper内存不足 | 调优mapreduce.map.memory.mb参数,增加YARN队列资源 |

| “Metadata exception” | 元数据版本不一致 | 重启Hive服务,检查元数据库连接状态 |

FAQs

Q1:Hive是否支持类似MySQL的DELETE FROM table WHERE条件的行级删除?

A1:标准Hive不支持直接的行级删除,可以通过INSERT OVERWRITE配合WHERE条件实现类似效果,但本质上是重写整个表,对于精确删除单行数据,建议使用ACID事务表(需Hive 3.0+且开启事务支持),但需注意性能损耗。

Q2:删除分区后发现误操作,如何快速恢复数据?

A2:若已开启HDFS快照功能,可通过hdfs dfs -cp命令从快照目录恢复数据。hdfs dfs -cp /snapshot/log_data_v1/pt=2023-08-15/ /user/hive/warehouse/log_data/,若未开启快照,需从备份系统恢复,恢复过程可能耗时较长,建议定期验证备份可用性