上一篇

GPU服务器卡顿频发?背后原因究竟是什么

- 行业动态

- 2025-04-29

- 4711

GPU服务器卡顿常见原因包括:显存不足或超负荷运算导致资源耗尽,硬件散热不良引发降频;驱动版本不兼容或存在破绽,软件配置错误;多任务并行时资源争用,CPU-GPU数据传输延迟;算法设计低效或计算负载不均衡,电源供电不稳定等。

为什么GPU服务器会卡顿?深度解析常见原因与解决方案

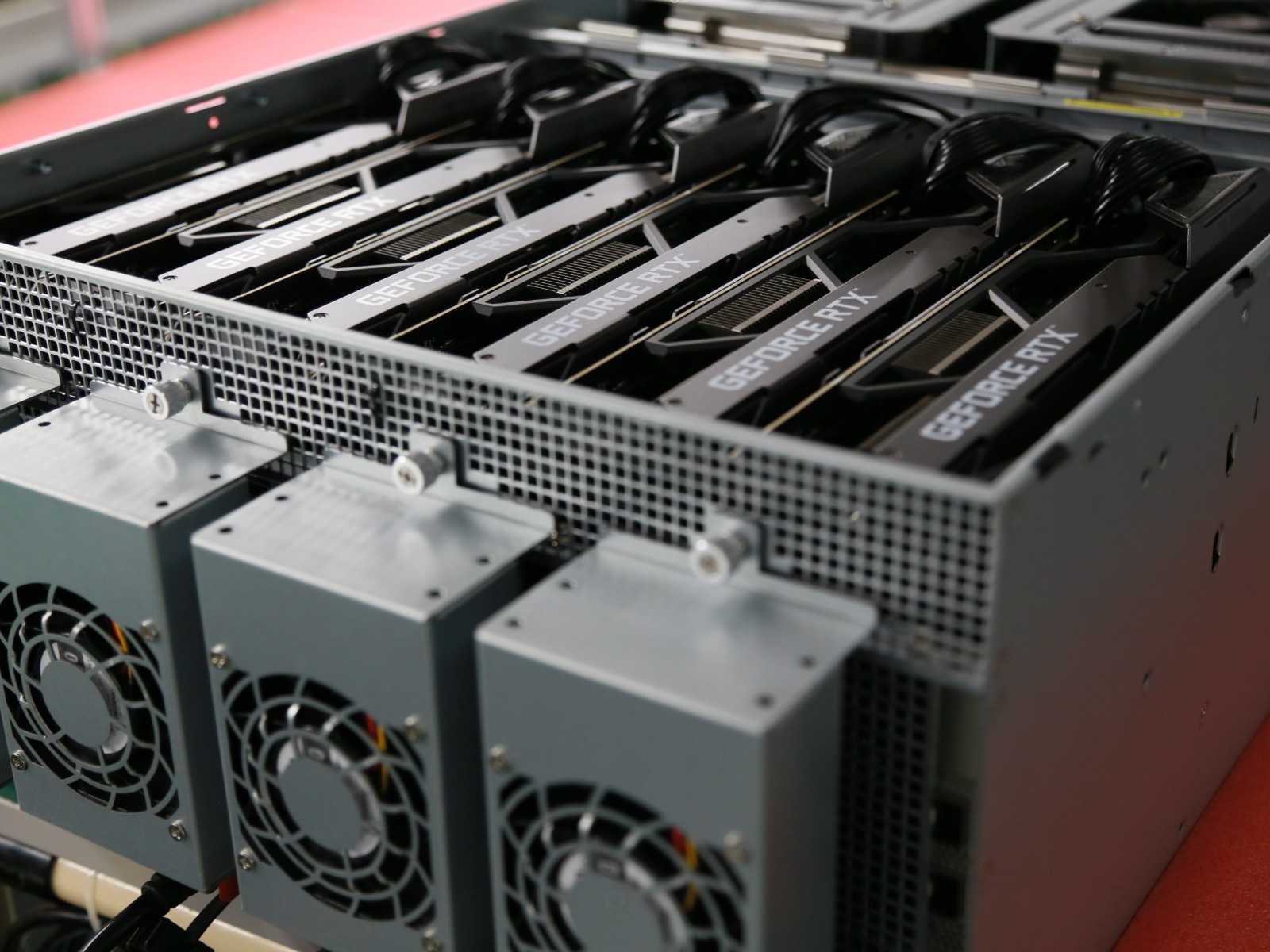

GPU服务器作为高性能计算的核心设备,广泛应用于AI训练、科学模拟、图形渲染等领域,但在实际使用中,卡顿问题频发,直接影响工作效率,以下是导致GPU服务器卡顿的六大核心原因及针对性解决方案,帮助用户快速排查问题。

硬件资源不足:显存与算力瓶颈

- 显存溢出:当任务所需显存超过GPU物理显存容量时,系统会频繁调用内存或硬盘交换数据,导致卡顿甚至崩溃。

解决方案:使用nvidia-smi监控显存占用,优化模型批量大小(batch size)或升级高显存GPU(如A100/A800)。 - 算力不足:复杂计算任务超出GPU算力,例如FP16精度模型在仅支持FP32的旧型号GPU上运行效率低下。

解决方案:更换支持混合精度计算的GPU(如V100、A100),或通过TensorRT优化推理速度。

软件环境配置不当

- 驱动与框架版本冲突:未及时更新NVIDIA驱动(如CUDA 12.x不兼容PyTorch 1.8以下版本),导致计算任务无法充分利用硬件加速。

解决方案:通过官方文档核对CUDA与深度学习框架的兼容性表,定期升级驱动。 - 系统内核参数未优化:默认的Linux内核参数(如

ulimit、vm.swappiness)可能限制GPU资源调度。

解决方案:调整交换分区策略,禁用不必要的后台进程,优化内存分配机制。

任务调度与资源争抢

- 多任务并行抢占资源:同一服务器运行多个AI训练任务时,GPU资源可能被过度分割,引发显存碎片化。

解决方案:使用容器化技术(如Docker)隔离任务,或通过Kubernetes设置资源配额。 - CPU与GPU协同效率低:数据预处理(如图像解码)未充分并行化,导致GPU因等待数据而空闲。

解决方案:采用异步数据加载(如PyTorch的DataLoader多线程模式)或使用GPU加速的数据预处理库(如DALI)。

散热与硬件故障

- 过热降频:长时间高负载运行导致GPU温度超过阈值(如NVIDIA GPU的80℃),触发保护机制强制降频。

解决方案:清理服务器风道灰尘,加强散热系统(如更换液冷方案),使用nvidia-smi -q -d TEMPERATURE监控温度。 - 硬件老化或损坏:显存颗粒故障、电源供电不稳等问题可能引发间歇性卡顿。

解决方案:定期运行硬件诊断工具(如NVIDIA的nvidia-smi dmon),及时更换异常硬件。

网络与存储瓶颈

- 分布式训练中的网络延迟:多节点训练时,跨服务器通信带宽不足导致同步等待时间增加。

解决方案:升级至RDMA网络(如InfiniBand),或使用梯度压缩技术减少数据传输量。 - 存储I/O性能不足:训练数据存储在低速硬盘(如HDD)时,读取速度无法匹配GPU计算需求。

解决方案:改用NVMe SSD或内存文件系统(如/tmp),预加载高频访问数据至缓存。

代码与算法效率问题

- 未启用混合精度训练:默认使用FP32精度计算浪费显存和算力。

解决方案:在PyTorch中启用AMP(Automatic Mixed Precision),显存占用可减少30%-50%。 - 冗余计算与内存泄漏:未释放的临时变量占用显存,或循环中的重复计算增加负担。

解决方案:使用torch.cuda.empty_cache()手动清理缓存,利用代码分析工具(如Py-Spy)定位性能瓶颈。

快速自查清单

- 运行

nvidia-smi查看GPU利用率与显存占用。 - 检查驱动版本与CUDA环境是否匹配。

- 监控CPU/GPU温度是否异常。

- 使用

dstat或htop分析系统资源争抢情况。 - 排查代码中的显存泄漏或计算冗余。

引用说明

本文技术细节参考:

- NVIDIA官方文档《CUDA Best Practices Guide》

- PyTorch社区《Mixed Precision Training Tutorial》

- Linux内核手册《System Performance Tuning》

- AWS白皮书《Optimizing GPU Instance Performance》

通过硬件升级、环境优化与代码调整,可系统性解决GPU服务器卡顿问题,建议定期维护并建立性能监控体系,确保计算资源高效利用。