上一篇

分布式数据库系统死机原因和应对方法

- 行业动态

- 2025-05-08

- 4

分布式数据库死机主因网络分区、节点故障、过载及数据不一致;应对需冗余设计、心跳监测、负载均衡与自动切换,结合一致性

分布式数据库系统死机原因与应对方法深度解析

分布式数据库死机的核心原因分类

| 类别 | 典型原因 |

|---|---|

| 硬件层故障 | 节点宕机(服务器/存储设备)、网络分区、电源中断、磁盘损坏 |

| 软件层缺陷 | 代码Bug(死锁/内存泄漏)、配置错误(参数/版本不兼容)、资源耗尽(CPU/内存/连接数) |

| 网络层异常 | 网络延迟/丢包、带宽饱和、DNS解析失败、跨机房链路中断 |

| 数据层问题 | 数据不一致(CAP冲突)、大表扫描锁表、写入压力过载、索引膨胀 |

| 外部依赖风险 | 上下游系统接口超时、第三方服务(如Kafka)不可用、时钟同步失效 |

| 人为操作失误 | 误删数据/库、错误部署拓扑、权限配置错误 |

具体原因与场景化分析

硬件层故障

- 节点宕机:单点服务器硬件故障(如内存烧毁)可能导致分片不可用,若未配置副本则业务中断。

- 存储设备故障:RAID卡失效或SSD坏块可能引发数据读取异常,触发数据库自我保护机制。

- 网络分区:机房级网络故障(如光纤被挖断)导致集群脑裂,多数节点无法选举出主节点。

软件层缺陷

- 代码级Bug:

- 死锁:分布式事务未正确处理隔离级别,导致全局锁竞争(如MySQL分布式XA事务)。

- 内存泄漏:长时间运行的查询或线程池未释放,逐渐耗尽JVM堆内存。

- 配置错误:

- 参数设置不当(如Redis最大内存限制过低),导致频繁触发持久化或淘汰策略。

- 版本兼容性问题(如TiDB升级后未同步PD组件版本),引发元数据不一致。

- 资源耗尽:

- 连接池溢出:高并发下未限制客户端连接数,数据库线程耗尽(如PostgreSQL max_connections)。

- CPU过载:复杂查询(如多表JOIN)未走索引,触发全表扫描消耗计算资源。

网络层异常

- 网络延迟/丢包:跨地域部署时,高延迟导致心跳超时(如ETCD集群要求RTT<100ms)。

- 带宽饱和:大规模数据迁移(如同步备份)占用带宽,影响正常读写流量。

- DNS故障:域名解析失败导致节点间通信中断(如MongoDB副本集依赖SRV记录)。

数据层问题

- 数据不一致:

- CAP定理权衡下,AP模式(如Cassandra)可能因网络分区导致临时数据冲突。

- 强一致性系统(如Spanner)在共识协议(Paxos/Raft)超时后拒绝服务。

- 写入压力过载:

- 突发流量(如电商瞬秒)超出数据库TPS阈值,触发限流或熔断机制。

- 日志系统(如Kafka)积压导致生产者阻塞,反压至数据库写入端。

外部依赖风险

- 上下游接口超时:支付系统回调延迟导致订单状态更新失败,锁定库存表。

- 第三方服务不可用:依赖的认证服务(OAuth)宕机,阻止用户鉴权请求。

人为操作失误

- 误删数据:Drop table误操作且无备份,导致分片数据永久丢失。

- 错误拓扑变更:扩容时未同步配置文件,新节点无法加入集群。

系统性应对策略

高可用架构设计

| 策略 | 实施方案 |

|---|---|

| 多副本冗余 | 采用Raft协议(如etcd/TiKV)实现数据副本,容忍N-1节点故障 |

| 跨机房部署 | 通过DNS负载均衡+异步复制(如MySQL主从+Canal)实现异地灾备 |

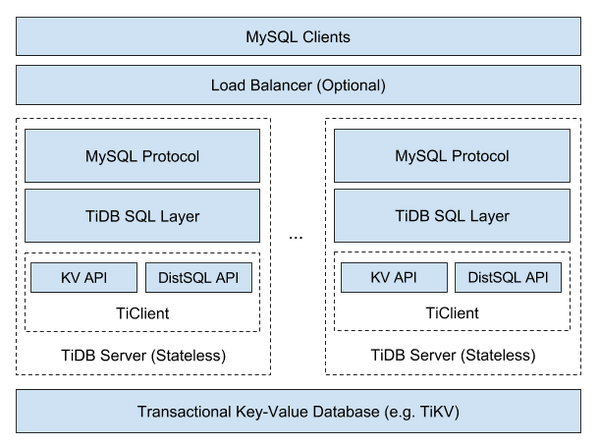

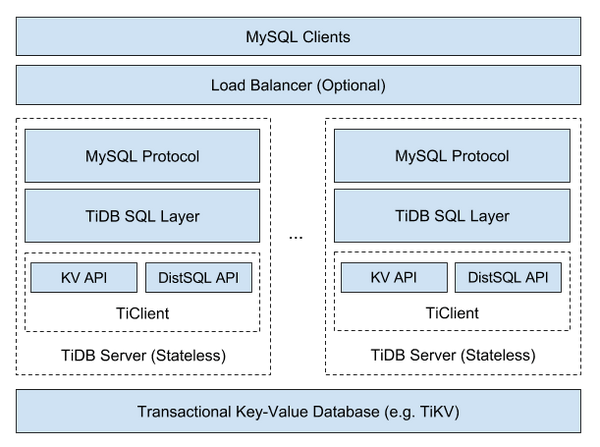

| 无状态设计 | 将查询/计算层(如ES)与存储层分离,避免单点瓶颈 |

监控与告警体系

- 黄金指标监控:

- 基础层:CPU/内存/磁盘IO(Prometheus+NodeExporter)

- 数据库层:QPS/TPS、慢查询日志(如Percona Toolkit分析MySQL)

- 网络层:RTT延迟、带宽利用率(pingmesh+Prometheus)

- 智能告警:

- 动态阈值(如基于EWMA算法预测资源拐点)

- 根因分析(如Zipkin追踪分布式调用链)

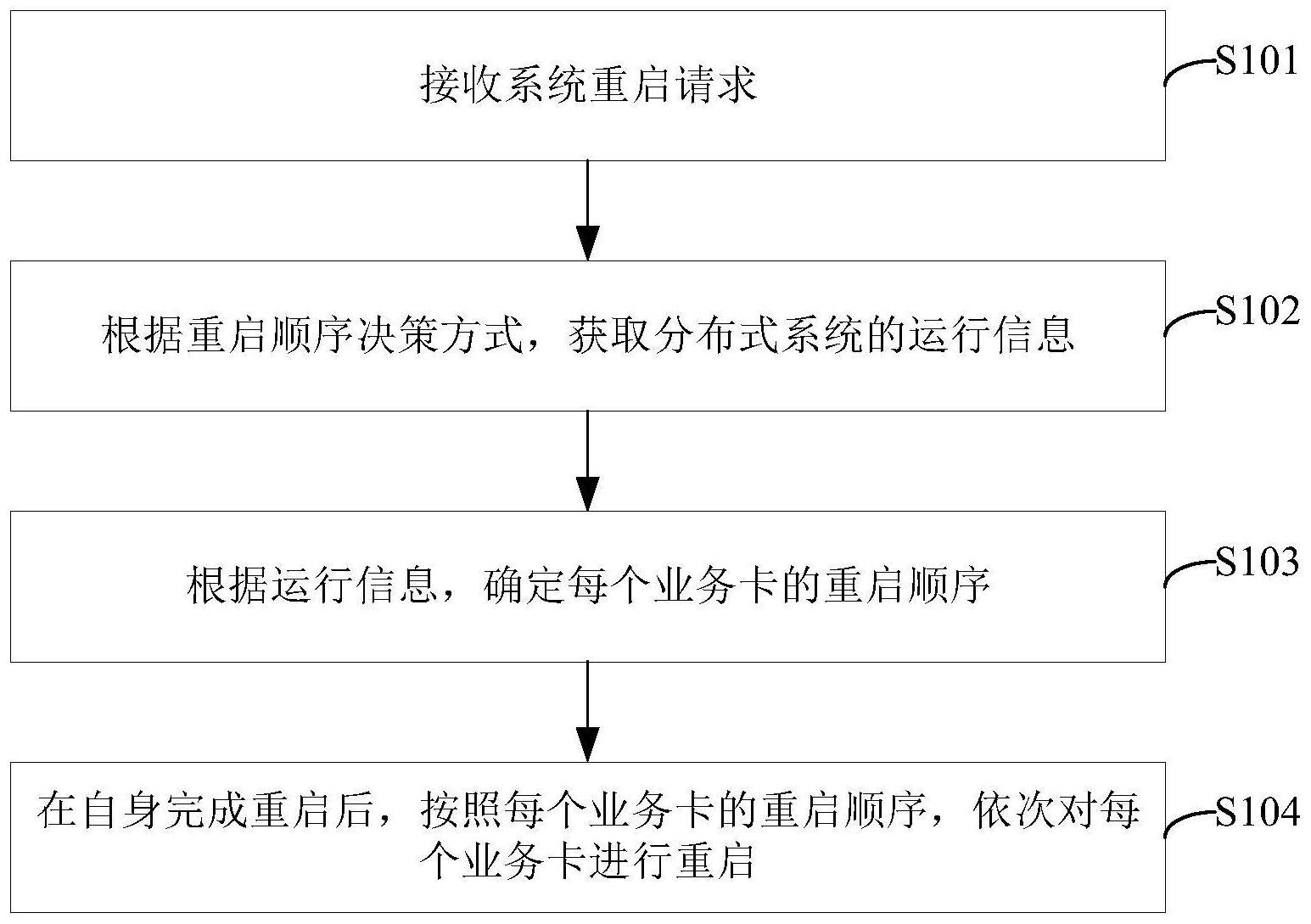

自动化容灾机制

- 故障检测:

- 心跳机制(如Consul健康检查)快速识别节点失联

- 日志异常检测(ELK+Machine Learning Job)

- 自愈流程:

- 自动重启容器(Kubernetes liveness probe)

- 流量切换(如Envoy服务发现动态路由)

- 数据恢复(Redis主从自动切换)

数据一致性保障

- 共识协议优化:

- 采用Raft而非Paxos降低理解成本(如etcd/CockroachDB)

- 调整选举超时时间(根据网络质量动态调节)

- 冲突解决策略:

- 乐观锁(如CAS操作)避免分布式死锁

- 版本向量(如Riak)解决AP模式下的数据冲突

容量规划与压测

- 弹性扩缩容:

- 基于队列长度自动扩容(如Kafka分区自动扩展)

- 分时复用资源(如AWS Aurora冷热存储分离)

- 全链路压测:

- 使用JMeter模拟高并发场景

- 观察分位数延迟(P99/P999)而非平均值

经典案例复盘

案例1:某银行核心系统宕机

- 原因:分布式事务未正确处理隔离级别,导致全局锁竞争

- 解决:引入TCC(Try-Confirm-Cancel)补偿机制,拆分大事务为子任务

案例2:某电商平台大促故障

- 原因:热点Key(如库存表)未做分片,Redis集群触发倾巢保护

- 解决:采用Sharding-JDBC哈希分片+本地缓存(Guava Cache)双重缓冲

预防性维护建议

- 混沌工程:定期注入故障(如Chaos Monkey随机终止Pod)

- 配置审计:GitOps管理数据库配置(如Ansible+VRA)

- 冷热数据分离:OLTP与OLAP业务物理隔离(如HBase列簇设计)

- 灰度发布:金丝雀发布策略(逐步扩大新版本流量)

FAQs

Q1:如何判断分布式数据库死机是网络问题还是软件Bug?

A1:优先检查监控告警中的网络指标(如RTT、丢包率),若跨机房延迟>50ms且持续恶化,大概率是网络分区,若各节点网络正常但日志出现死锁错误,则偏向软件问题,可通过netstat -an查看连接状态,结合Prometheus时序图定位异常时间点。

Q2:分布式数据库扩容时如何避免数据不一致?

A2:采用滚动升级+数据校验机制:1) 先扩容存储节点并同步数据;2) 启用Read Write模式验证新旧节点数据一致性;3) 使用CRC校验或Hash比对确保分片完整;4) 最后切换流量至新节点,过程中需暂停写操作或使用双写模式过渡