上一篇

GPU服务器传输速度为何迟迟提不上来?

- 行业动态

- 2025-05-07

- 3394

GPU服务器传输速度慢可能由网络带宽不足、硬件性能瓶颈或传输协议低效导致,高延迟路径、服务器负载过高、存储I/O限制及未压缩的大文件传输也会影响速度,防火墙策略、路由配置不当或跨国数据传输距离较远也可能成为关键因素。

为什么GPU服务器传输速度慢?这些因素可能是“罪魁祸首”

在使用GPU服务器时,数据传输速度直接影响计算任务的效率,如果发现服务器传输速度明显降低,可能是以下原因导致的,我们从硬件、网络、软件、环境等多维度分析,并提供针对性解决方案。

硬件配置问题

网卡性能不足

- 千兆网卡瓶颈:许多GPU服务器的默认网卡仅支持1Gbps带宽,而GPU计算任务的输入/输出数据量可能远超这一限制。

- 解决方案:升级为10G/25G/100G高速网卡,或采用RDMA(远程直接内存访问)技术,减少CPU参与数据传输的开销。

存储设备速度慢

- HDD机械硬盘的读写速度(约100-200MB/s)远低于SSD固态硬盘(500MB/s~7GB/s)。

- 解决方案:使用NVMe SSD或分布式存储系统(如Ceph、GlusterFS)提升I/O性能。

网络环境限制

带宽或延迟问题

- 公网传输瓶颈:若服务器部署在云端,通过公网传输数据可能受限于服务商提供的带宽上限(例如默认仅5Gbps)。

- 跨区域延迟:数据从本地到云服务器需经过多个网络节点,物理距离过远可能导致传输延迟。

- 解决方案:

- 选择支持内网高速传输的云服务(如AWS Direct Connect、阿里云高速通道)。

- 采用CDN或边缘节点缓存高频数据。

路由或拥塞问题

- 网络路径中的路由策略不合理或链路拥塞(如高峰期丢包率上升)。

- 解决方案:通过

traceroute或MTR工具诊断路由路径,优化网络配置或与服务商协商调整链路。

软件与协议优化不足

未启用高效传输协议

- 传统协议(如FTP、HTTP)传输效率低,而像TCP BBR、UDP-based QUIC等协议可提升吞吐量。

- 解决方案:

- 使用高性能协议如gRPC、WebSocket或专为HPC设计的NVIDIA GPUDirect。

- 启用多线程传输(如

aria2、axel)。

驱动或固件未更新

- 老旧的网卡驱动或GPU固件可能无法发挥硬件性能。

- 解决方案:定期更新驱动,例如通过

nvidia-smi检查GPU驱动版本,或使用厂商提供的管理工具(如Intel DSA)。

数据处理与资源分配

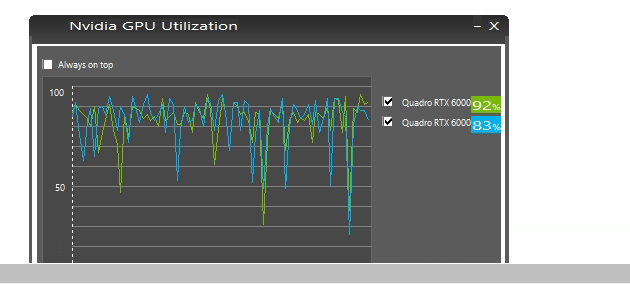

CPU成为瓶颈

- GPU计算依赖CPU预处理数据,如果CPU性能不足(如单核处理多线程任务),会拖累整体传输速率。

- 解决方案:选择多核CPU(如AMD EPYC或Intel Xeon Scalable),并通过并行化任务减轻负载。

未启用数据压缩

- 传输未压缩的原始数据(如视频、图像)会占用大量带宽。

- 解决方案:使用Zstandard、Snappy等低延迟压缩算法,在发送端压缩数据,接收端解压。

环境与外部干扰

物理环境干扰

- 服务器所在机房温度过高、电磁干扰或供电不稳可能导致硬件降速保护。

- 解决方案:监控服务器温度(使用

lm-sensors工具),确保散热系统正常。

安全策略限制

- 防火墙或安全组规则可能意外拦截数据包(例如限制端口或协议)。

- 解决方案:检查iptables、云服务商安全组配置,开放必要端口(如22/SSH、80/HTTP)。

服务商相关因素

共享带宽竞争

- 部分云服务商采用共享带宽模式,同一物理机上的其他用户可能占用大量带宽。

- 解决方案:购买独享带宽套餐,或选择高性能计算专属实例。

服务商区域性限制

- 某些地区的数据中心基础设施较差,或国际链路存在政策限制(如跨境传输审查)。

- 解决方案:选择靠近用户或数据源的服务区域,或与合规部门确认传输策略。

排查与优化步骤总结

诊断工具:

- 测试带宽:

iperf3、speedtest-cli - 监控硬件:

nvidia-smi、htop、iftop - 分析延迟:

ping、mtr

- 测试带宽:

优化优先级:

硬件升级 > 网络优化 > 软件调优 > 环境调整

引用说明

本文参考了以下技术文档与最佳实践:

- NVIDIA官方文档《GPUDirect Storage技术白皮书》

- AWS《高性能计算网络优化指南》

- IEEE论文《Data Compression for High-Speed Data Transfer》(2022)

- 阿里云《云服务器网络性能优化方案》