hive的sql优化

- 行业动态

- 2025-05-06

- 2

Hive SQL优化核心:合理分区/分桶,选ORC/Parquet格式,小表驱动JOIN,过滤条件前置,禁用全表扫描,调并行参数,精简字段

Hive作为大数据领域常用的SQL查询引擎,其性能优化是提升数据处理效率的关键,本文将从数据存储设计、查询语句优化、资源配置调整等多个维度,系统阐述Hive SQL优化的核心策略与实践方法。

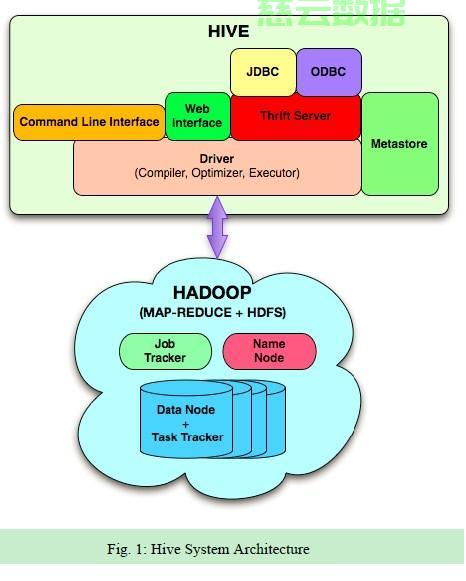

Hive执行原理与性能瓶颈

Hive通过将SQL转换为MapReduce任务执行,其性能受数据存储格式、任务并行度、数据倾斜等因素影响,典型执行流程包括:解析SQL→生成执行计划→拆分Stage→执行MapReduce任务,性能瓶颈常出现在以下环节:

- 全表扫描导致IO负载过高

- 数据倾斜引发单节点压力过大

- 小文件过多产生额外开销

- 复杂操作未充分利用分区特性

数据存储层优化(表结构设计)

数据分区策略

| 分区类型 | 适用场景 | 优化效果 |

|---|---|---|

| 静态分区 | 已知固定分区范围 | 减少全表扫描 |

| 动态分区 | 不确定分区值 | 避免手动管理分区 |

| 复合分区 | 多维度查询需求 | 提升查询裁剪精度 |

实践建议:

- 按高频查询字段建立分区(如时间、地区、用户ID)

- 控制分区数量在合理范围(建议不超过1000个)

- 使用

PARTITIONED BY创建分区表

文件存储优化

| 文件格式 | 特点 | 适用场景 |

|---|---|---|

| ORC | 列式存储+压缩+索引 | 读密集型查询 |

| Parquet | 列式存储+嵌套结构支持 | 复杂数据结构处理 |

| Avro | 模式进化支持 | 数据结构频繁变更场景 |

| TextFile | 简单易用 | 临时数据/调试场景 |

优化要点:

- 优先选择列式存储格式(ORC/Parquet)

- 开启文件级别压缩(SNAPPY/ZLIB)

- 设置合理BlockSize(默认128MB可调整至256MB)

索引技术应用

| 索引类型 | 实现方式 | 适用场景 |

|---|---|---|

| Compacted | BITMAP索引 | 低基数字段精确查询 |

| Bloom | 概率型索引 | 高基数字段过滤 |

| HBase索引 | 外部存储索引 | 实时查询加速 |

示例:

CREATE INDEX userid_idx ON user_behavior (user_id) AS 'COMPACT' WITH DEFERRED REBUILD; -后台异步构建索引

SQL查询优化策略

谓词下推优化

通过WHERE子句提前过滤数据,减少扫描量,需注意:

- 分区字段过滤自动下推

- 非分区字段需开启

hive.optimize.ppd=true - 复杂条件需括号明确优先级

示例:

SELECT FROM sales WHERE category='electronics' AND price > 1000; -自动下推category分区过滤,price条件需开启PPD

Join操作优化

| Join类型 | 优化策略 | 注意事项 |

|---|---|---|

| 大表Join小表 | 使用MapJoin | 设置mapjoin=auto |

| 维度表Join | 广播小表 | 小表需设置LATERAL VIEW |

| 大表Join大表 | 空值过滤+倾斜处理 | 启用skew join优化 |

优化示例:

/+ MapJoin(b) / SELECT /+ MapJoin(b) / a., b.name FROM orders a JOIN dim_product b ON a.product_id = b.id;

Group By优化

- 使用

DISTRIBUTE BY预分发数据 - 对倾斜key添加随机数打散

- 优先使用局部聚合(CombineFile)

倾斜处理示例:

SELECT user_id, count() FROM (SELECT user_id, cast(rand()10 as int) as r from logs) t GROUP BY user_id, r;

执行参数调优

并行度配置

| 参数 | 作用 | 推荐值 |

|---|---|---|

| mapreduce.job.split | 切片大小控制 | 根据文件大小动态调整 |

| hive.exec.parallel | 并发执行阶段 | TRUE(默认) |

| hive.exec.dynamic.partition.mode | 动态分区模式 | nonstrict(避免MR数量爆炸) |

内存优化配置

| 参数 | 作用 | 推荐值 |

|---|---|---|

| yarn.nodemanager.vmem-pmem-ratio | Map端虚拟内存比例 | 4(提升排序性能) |

| hive.tez.container.size | Tez容器内存 | 根据集群规格调整(如4GB) |

| hive.vectorized.execution.enabled | 向量化执行 | TRUE(Hive 3.x) |

高级优化技术

CBO(基于代价的优化)

通过ANALYZE TABLE收集统计信息,使优化器选择最优执行计划:

ANALYZE TABLE user_behavior COMPUTE STATISTICS; -收集行数、列基数、数据分布等信息

中间结果缓存

使用EXCHANGE TO_LOCAL将中间结果写入本地磁盘:

INSERT OVERWRITE DIRECTORY '/tmp/result' SELECT /+ REPLACE(3) / FROM lineitem;

自定义UDF优化

针对复杂计算逻辑开发UDF,减少数据扫描次数。

public class AgeCalculator extends UDF {

public IntWritable evaluate(Text birthdate) {

// 自定义年龄计算逻辑

}

}性能诊断工具

| 工具 | 功能 | 使用场景 |

|---|---|---|

| EXPLAIN DEXTREES | 查看执行计划树 | 验证优化器选择路径 |

| Job Browser | 任务执行监控 | 发现阶段耗时异常 |

| iostat/vmstat | 系统资源监控 | 定位硬件瓶颈 |

| Hive Profiler | SQL执行耗时分析 | 识别扫描/排序/聚合耗时 |

典型案例分析

场景:电商订单表按用户ID分组统计,出现严重数据倾斜。

原始SQL:

SELECT user_id, COUNT() FROM orders GROUP BY user_id;

优化方案:

添加随机数打散倾斜key:

SELECT user_id, count() FROM (SELECT user_id, cast(rand()10 as int) as r from orders) t GROUP BY user_id, r;

开启倾斜join优化:

SET hive.groupby.skewindata=true;

使用局部聚合:

SET hive.map.aggr=true; -开启Map端预聚合

FAQs

Q1:为什么开启ORC文件格式后查询速度反而变慢?

A:ORC文件虽然支持高效压缩和列式存储,但需要配合以下配置:

- 确保使用

ORC SerDe序列化方式 - 开启

hive.orc.write.format=0.12支持轻量级索引 - 调整

mapreduce.map.memory.mb适应列式读取特性 - 检查是否开启向量化执行(

hive.vectorized.execution.enabled=true)

Q2:如何判断SQL是否存在数据倾斜?

A:可通过以下方法诊断:

- 查看Job Browser中Reduce阶段任务时长,存在超长任务即表明倾斜

- 使用

EXPLAIN查看执行计划,观察是否有Skewed Join标记 - 检查HDFS输出目录,合并后的小文件数量异常增多可能暗示倾斜

- 开启

hive.groupby.skewindata=true后查看日志中的倾斜警告