hive的几种存储引擎

- 行业动态

- 2025-05-06

- 3

Hive支持多种存储引擎,包括HDFS(文本/序列文件)、ORC/Parquet(列式存储)、HBase/Cassandra及支持AC

Hive作为大数据领域常用的数据仓库工具,其存储机制直接影响查询性能与数据管理效率,本文将系统解析Hive的存储架构、核心存储格式、事务支持机制及优化策略,并通过对比分析帮助用户选择最佳实践方案。

Hive存储架构核心组件

Hive采用分层存储架构,核心组件包括:

- MetaStore:元数据服务,管理表结构、分区信息

- HDFS/对象存储:实际数据存储层

- 文件格式管理层:定义数据序列化方式

- 事务管理系统:保证数据一致性(基于ACID特性)

主流存储文件格式对比

| 格式 | 压缩支持 | 列式存储 | 索引支持 | 更新效率 | 典型场景 |

|---|---|---|---|---|---|

| TextFile | 手动配置 | 否 | 无 | 低 | 日志类非结构化数据 |

| SequenceFile | 自动 | 否 | 无 | 中 | 小文件批量处理 |

| RCFile | 块压缩 | 是 | 无 | 中 | 中等规模数据分析 |

| ORC | 高效压缩 | 是 | 集成 | 高 | 大并发OLAP查询 |

| Parquet | 高效压缩 | 是 | 第三方 | 高 | 跨引擎数据交换(Spark等) |

| Avro | 块压缩 | 是 | 有限 | 中 | 实时数据流处理 |

技术细节解析:

ORC格式:

- 支持轻量级索引(STRIPE级别)

- 复杂数据类型原生支持(MAP/ARRAY)

- 动态分区裁剪(仅读取查询涉及分区)

- 写入时统计信息收集(提升查询优化)

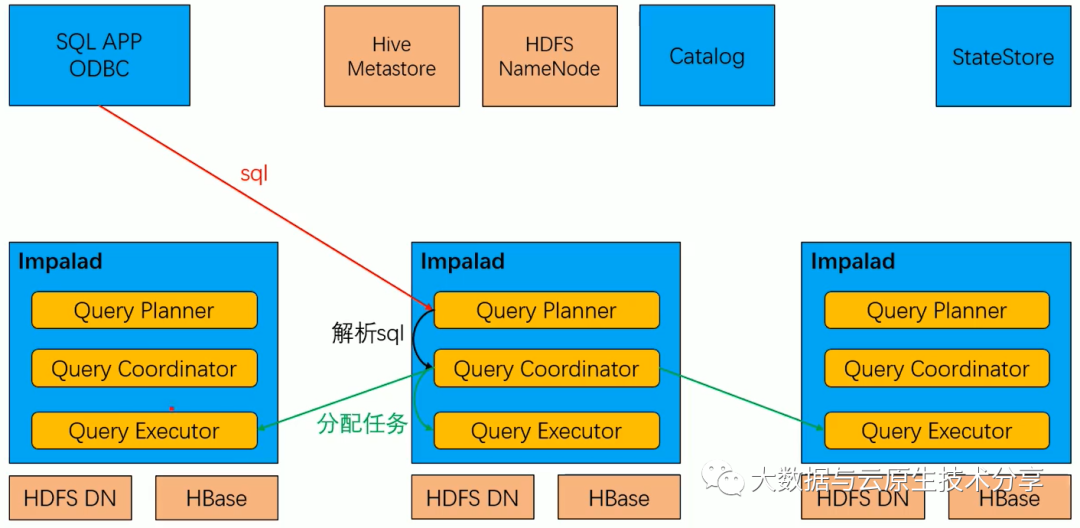

Parquet格式:

- 基于Apache Thrift的自描述文件结构

- 支持页式(Page)存储,优化IO效率

- 广泛兼容Spark/Impala/Presto等计算引擎

- 列式编码(Dictionary/Run-Length)提升压缩率

RCFile特性:

- 行组(Row Group)分块存储

- 同步/异步两种压缩模式

- 适合中等规模数据集(TB级)

存储系统集成方案

Hive可对接多种存储后端,需根据业务需求选择:

| 存储类型 | 适用场景 | 关键配置参数 |

|—————-|———————————-|———————————|

| HDFS | 传统大数据集群 | dfs.replication=3 |

| Amazon S3 | 云原生架构 | fs.s3a.committer.name=magic |

| Azure Blob | 混合云部署 | fs.azure.account.key.delimiter |

| ADLS Gen2 | 高性能云数仓 | enable.data.lake.storage=true |

| JDBC | 关系型数据库迁移 | javax.jdo.option.ConnectionURL |

跨存储引擎适配要点:

- 配置

fs.defaultFS指定存储根路径 - 启用

hive.exec.s3.use.instance.creds支持临时凭证 - 设置

mapreduce.job.cache.files预加载驱动包

事务与存储引擎演进

Hive事务机制发展路线:

- x时代:无事务支持,依赖外部工具保障一致性

- x版本:引入基础ACID支持(基于锁机制)

- x+版本:

- 采用乐观锁协议(Write IF)

- 实现快照隔离(Snapshot Isolation)

- 支持原子操作(INSERT OVERWRITE)

事务存储关键技术:

- 写前日志(WAL):/wh/warehouse/txns目录存储操作日志

- 酸式目录:.acidctea目录维护事务元数据

- 时间旅行查询:通过

txn_id回溯历史版本 - 垃圾回收:

hive.txn.manager=org.apache.hadoop.hive.ql.lockmgr.DbTxnManager配置项控制

存储优化实践指南

压缩策略:

- ORC推荐Zlib+Snappy组合(

orc.compress=ZLIB) - Parquet优先SNAPPY压缩(

parquet.compression=SNAPPY) - 开启BloomFilter减少IO(

hive.vectorized.execution.enabled=true)

- ORC推荐Zlib+Snappy组合(

分区设计:

- 动态分区上限设置(

hive.exec.dynamic.partition=nonstrict) - 日期分区采用YYYYMMDD格式(

PARTITIONED BY (dt string)) - 使用

NUMBUCKETS控制数据倾斜(CLUSTERED BY)

- 动态分区上限设置(

文件尺寸控制:

- 设置

mapreduce.job.split.metainfo.maxsize=100MB防止小文件过多 - 启用

hive.merge.mapfiles=true自动合并小文件 hive.merge.size.per.task=256MB控制合并粒度

- 设置

索引优化:

- 创建Compacted索引:

CREATE INDEX idx ON table CLUSTERED BY(col) - 配置索引缓存:

hive.index.compact.file.size=500MB - 索引生命周期管理:

ALTER INDEX REBUILD定期重建

- 创建Compacted索引:

FAQs

Q1:如何为实时分析选择存储格式?

A1:优先考虑Parquet格式,因其:

- 支持向量化读取加速查询

- 页式存储结构适合流式写入

- 广泛兼容实时计算引擎(如Flink)

- 配置

parquet.block.size=256M优化文件大小,启用parquet.enable.dictionary.encoding=true提升编码效率。

Q2:Hive事务表出现死锁如何处理?

A2:解决方案包括:

- 调整

hive.txn.timeout=300延长事务等待时间 - 启用

hive.support.concurrency=true允许并发插入 - 检查

hive.enforce.bucketing=true避免数据倾斜导致锁竞争 - 使用

EXPLAIN EXTENDED分析执行计划,识别热点