hive的数据加密存储

- 行业动态

- 2025-05-06

- 3

Hive通过HDFS透明加密实现数据存储加密,支持表级/分区加密,结合SSL传输加密及KMS密钥管理,配合

Hive的数据加密存储详解

在大数据处理场景中,Hive作为常用的数据仓库工具,其数据安全性至关重要,数据加密是保护敏感信息的核心手段,尤其在多租户环境或合规性要求严格的场景下,本文将从加密类型、实现方式、密钥管理及性能优化等方面,全面解析Hive的数据加密存储机制。

Hive数据加密的必要性

Hive存储的数据通常以文件形式保存在HDFS中,若未加密,可能存在以下风险:

- 静态数据泄露:HDFS中的文件可能被未授权用户直接读取。

- 传输链路劫持:客户端与Hive Server交互时,数据可能被中间人攻击截获。

- 合规性要求:金融、医疗等行业需满足GDPR、HIPAA等数据加密法规。

Hive数据加密的两种类型

| 加密类型 | 适用场景 | 关键技术 |

|---|---|---|

| 静态数据加密 | 数据存储在HDFS时 | HDFS透明加密(TDE)、应用层加密 |

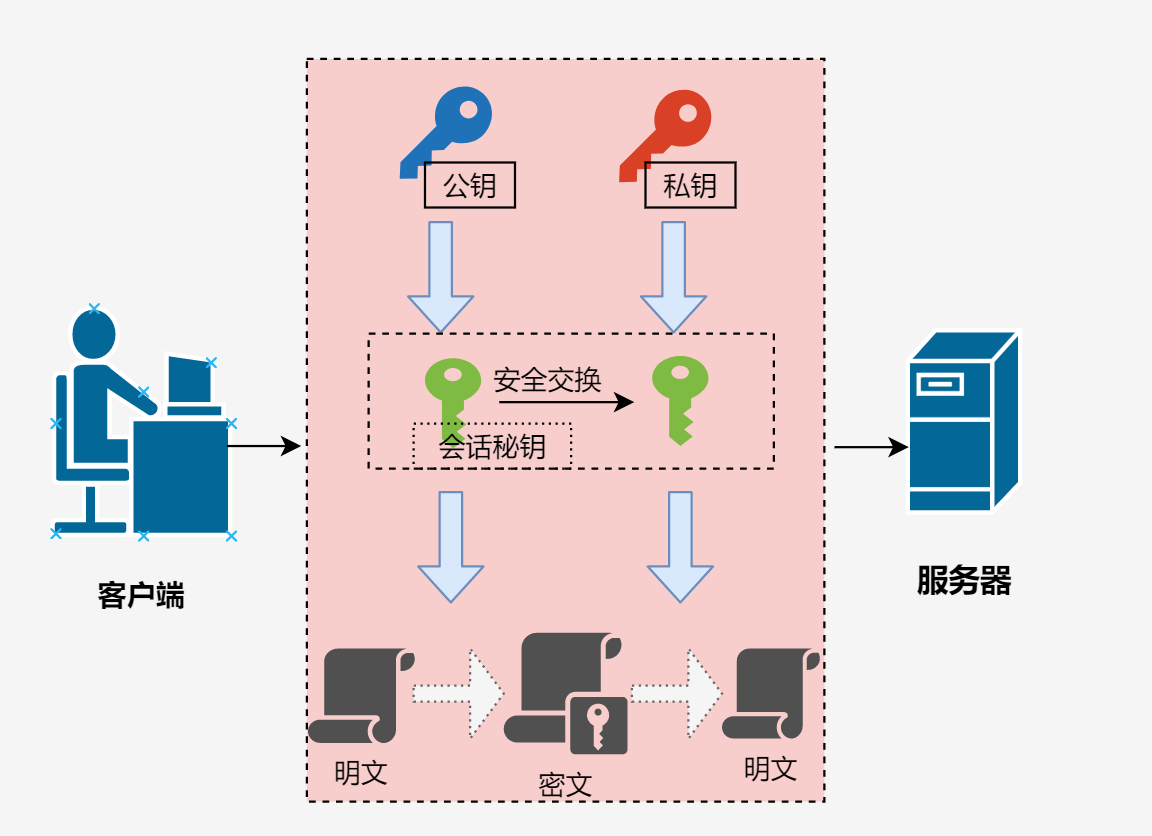

| 传输加密 | 客户端与Hive Server通信时 | SSL/TLS、Kerberos认证 |

静态数据加密

- HDFS透明加密(TDE)

Hadoop 3.x及以上版本支持HDFS透明加密,通过dfs.encryption配置开启,加密过程对用户透明,无需修改现有Hive表结构。

配置示例:<property> <name>dfs.encryption</name> <value>true</value> </property> <property> <name>dfs.encrypt.data.transfer.algorithm</name> <value>AES/CTR/NoPadding</value> <!-对称加密算法 --> </property>

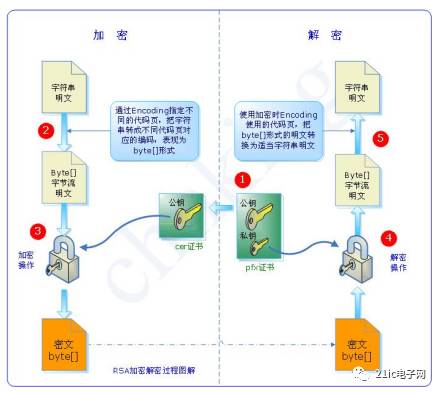

- Hive表级加密

通过STORED AS ORC TBLPROPERTIES ('orc.encrypt'='AES')指定列式存储格式(如ORC/Parquet)的加密,需配合Key Management Server(KMS)管理密钥。

传输加密

- SSL/TLS配置

Hive Server2默认使用HTTP协议,需手动启用SSL,修改hive-site.xml:<property> <name>hive.server2.use.ssl</name> <value>true</value> </property> <property> <name>hive.server2.keystore.path</name> <value>/path/to/keystore.jks</value> </property>

- Kerberos认证

在启用SSL的基础上,通过Kerberos实现双向认证,防止伪造客户端或服务端,需配置krb5.conf并同步所有节点时间。

密钥管理方案

密钥管理是加密系统的核心,Hive支持以下模式:

| 方案 | 特点 | 适用场景 |

|——————–|——————————————–|—————————|

| HDFS KMS集成 | 使用Hadoop自带的Key Management Server | 中小型集群,低成本 |

| 第三方KMS | 集成AWS KMS、Azure Key Vault等云服务 | 混合云/多云环境,高可用 |

| 自建KMS | 基于Hazelcast或自定义实现 | 超大规模集群,特殊合规需求 |

示例:集成AWS KMS

- 在EMR集群配置

hadoop-kms-site.xml:<property> <name>kms-provider.aws.key-id</name> <value>arn:aws:kms:us-east-1:123456789012:key/my-key</value> </property>

- Hive表创建时指定加密:

CREATE TABLE user_data (id BIGINT, name STRING) STORED AS ORC TBLPROPERTIES ('orc.encrypt'='AES', 'transactional'='true');

性能影响与优化

加密操作会增加CPU消耗和I/O延迟,实测表明:

- 写入性能下降约15%-30%(取决于硬件和加密算法)。

- 查询性能下降约5%-10%(主要影响扫描阶段)。

优化建议:

- 硬件加速:使用支持AES-NI指令集的CPU。

- 列式存储优化:ORC/Parquet格式压缩率高,可减少加密数据量。

- 分层加密:仅对敏感字段加密,非敏感字段保持明文。

操作步骤归纳

- 启用HDFS加密:

- 修改

hdfs-site.xml,设置dfs.encryption=true。 - 重启HDFS并格式化加密目录(首次启用需迁移数据)。

- 修改

- 配置Hive加密参数:

- 在

hive-site.xml中设置hive.exec.encrypt.output=true。

- 在

- 部署SSL/Kerberos:

- 生成SSL证书,配置

hive.server2.ssl-client.cert。 - 启用Kerberos并配置

hive.server2.authentication=KERBEROS。

- 生成SSL证书,配置

- 验证加密效果:

- 使用

hdfs dfs -cat查看文件是否为二进制乱码。 - 通过

EXPLAIN命令检查查询计划是否包含解密步骤。

- 使用

FAQs

Q1:启用HDFS加密后,历史数据是否需要重新加密?

A1:是的,首次启用加密时,需将现有数据迁移至加密目录,否则新写入的数据会加密而旧数据仍为明文,建议通过hdfs crypto -encryptPath命令批量处理历史数据。

Q2:Hive加密是否会影响ACID事务?

A2:会部分影响,启用加密后,事务日志(HIVE_TXN_LOG)也会被加密,可能导致事务提交时间延长,建议在事务频繁的场景中优先优化密钥管理效率