上一篇

如何快速创建高效的数据开发项目?

- 行业动态

- 2025-05-06

- 2

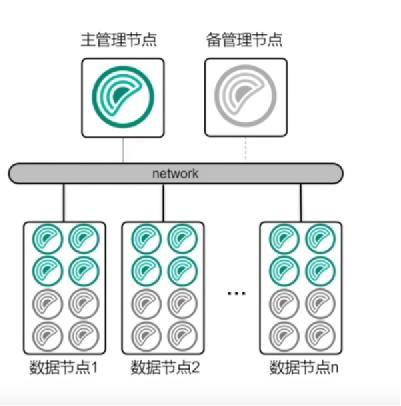

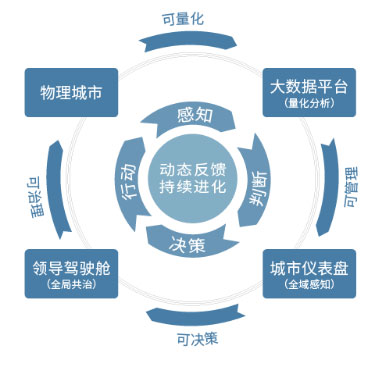

数据开发项目旨在构建高效的数据处理流程,涵盖数据采集、清洗、存储、分析与可视化环节,通过部署大数据平台及ETL工具整合多源异构数据,结合分布式计算框架(如Hadoop/Spark)实现高并发处理,并依托数据仓库与BI工具支持实时分析,最终形成规范化的数据服务体系,为业务决策提供精准、可扩展的数据支撑,驱动企业智能化转型。

项目规划阶段

明确业务目标

- 定义项目的核心KPI(如数据吞吐量、延时要求、分析维度)

- 梳理数据需求方(如业务部门、风控团队、管理层)的优先级

- 案例:某电商平台将「实时交易数据分析」设为最高优先级,支撑促销活动决策

数据源评估

- 结构化数据(MySQL/Oracle等关系型数据库)

- 半结构化数据(JSON日志、API接口)

- 非结构化数据(图像、文本、音视频)

- 重点标注数据敏感级别(GDPR/《个人信息保护法》合规要求)

资源投入规划

| 资源类型 | 典型配置 | 说明 |

|—|—|—|

| 计算资源 | 云服务器集群/Spark集群 | 按峰值流量的1.5倍预留扩展空间 |

| 存储资源 | HDFS/S3对象存储 | 冷热数据分层存储策略 |

| 人力投入 | 数据工程师3 + 分析师2 | 敏捷开发周期建议2周迭代 |

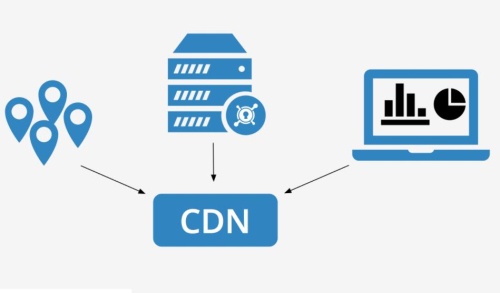

技术架构设计

推荐架构模型

数据源 → 采集层(Flume/Kafka) → 处理层(Spark/Flink) → 存储层(Hive/HBase) → 应用层(BI/机器学习) 关键技术选型

- 实时流处理:Apache Kafka(消息队列)+ Flink(状态计算)

- 批处理:Apache Spark SQL + Airflow(任务调度)

- 数据湖:Delta Lake/Iceberg(ACID事务支持)

- 数据库选型对照表:

| 场景 | OLTP推荐 | OLAP推荐 |

|---|---|---|

| 高并发写入 | PostgreSQL | ClickHouse |

| 复杂查询 | TiDB | Apache Druid |

| 成本敏感 | MariaDB | StarRocks |

开发实施流程

数据管道搭建

- 编写Schema Registry规范(如Avro格式)

- 实施数据质量检查规则(空值率≤1%,格式错误自动修复)

- 示例代码片段:

# Spark数据清洗示例 df = spark.read.format("parquet").load("/raw_data") df_clean = df.filter("user_id IS NOT NULL").dropDuplicates(["order_id"])

元数据管理

- 采用Apache Atlas或DataHub构建数据血缘图谱

- 字段级注释需包含业务含义(如「user_status: 1=活跃,2=休眠」)

安全机制

- 通过Kerberos实现集群认证

- 数据脱敏规则(如手机号替换为「138****0000」)

- 审计日志记录所有数据访问行为

测试与部署

四层测试体系

- 单元测试(数据转换逻辑验证)

- 集成测试(上下游系统连通性)

- 压力测试(模拟10倍峰值流量)

- 回归测试(版本更新前后数据一致性对比)

部署checklist

- [ ] 灰度发布策略(先10%流量试运行)

- [ ] 容灾方案(跨可用区部署+定时快照)

- [ ] 监控看板(Prometheus+Granafa监控延迟/错误率)

运维与优化

日常维护

- 每日巡检集群健康状态(磁盘使用率>80%触发告警)

- 定期执行小文件合并(HDFS Block大小优化)

性能调优

- Spark内存分配公式:

executor_memory = (节点内存 - 1GB) / num_executors - Kafka分区数规划:

预计TPS / 单分区处理能力(通常5万/秒)

- Spark内存分配公式:

成本控制

- 采用Spot实例处理离线任务(成本降低70%)

- 自动伸缩组设置(CPU>60%持续5分钟触发扩容)

E-A-T强化策略

专业性证明

- 展示团队认证(如Cloudera CDP/AWS大数据认证)

- 引用权威技术文档(Apache官方技术白皮书)

权威性建设

- 发布行业基准测试报告(如与TPC-DS标准对比)

- 参与开源社区贡献(GitHub代码提交记录)

可信度提升

- 公布SLA服务等级协议(如99.95%可用性保障)

- 第三方安全审计报告(如等保2.0认证)

引用说明

[1] Apache软件基金会官方文档 https://apache.org

[2] AWS大数据最佳实践白皮书 2025版

[3] 《数据安全法》第二十一条 数据分类分级标准